Хроники искусственного интеллекта: анонсы первой половины лета 2024

С нашего последнего обзора интересных новостей в индустрии ИИ прошло столько всего интересного, что Gadgets News решил рассказать про них уже сейчас, не дожидаясь подведения итого всего лета.

Начнем с самого заметного — анонса Claude 3.5 Sonnet. В отличие от Opus, это не самая старшая, но зато новейшая версия чат-бота Anthropic — благодаря чему превзошла Claude 3 Opus и вплотную приблизилась к нынешнему лидеру GPT-4o, заняв 2-е место в рейтинге. Помните бенчмарк ARC-AGI, предложенный Франсуа Шолле в качестве критерия для AGI?

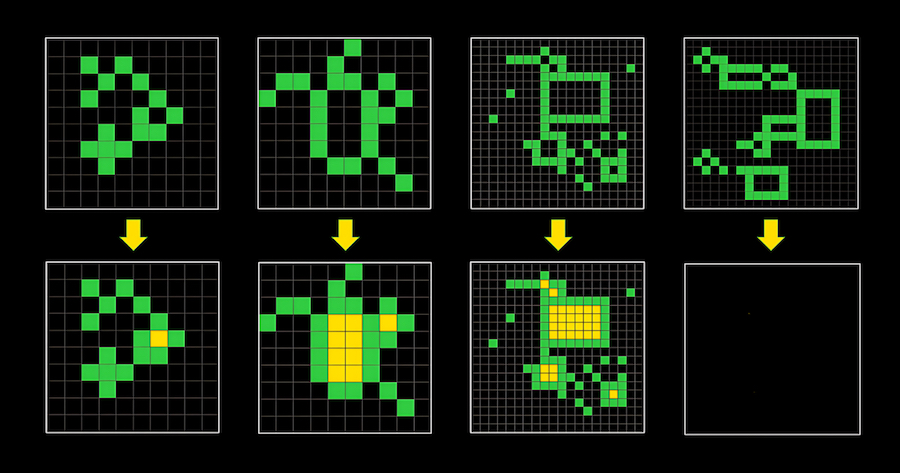

Как уже рассказывал Gadgets News, ни один из чат-ботов до сих пор с ним справиться не мог — не считая GPT-4o, которому поручили написать программу, которая это сделает вместо него. Так вот с релизом Claude 3.5 Sonnet мы дали ему тот же тест — и вот как выглядит устное описание его решения (поскольку этот чат-бот может «видеть» изображения, но пока не может их рисовать):

Анализируя представленные изображения, можно заметить закономерность: в нижнем ряду к каждой фигуре добавляется желтый прямоугольник, заполняющий часть зеленой фигуры.

Следуя этой логике, в последнем пустом квадрате должна появиться исходная зеленая фигура с желтым прямоугольником внутри нее. Вероятно, желтый прямоугольник заполнит центральную часть извилистой зеленой линии.

Хотя я не могу создать или изменить изображения, я могу описать, как должен выглядеть последний квадрат: зеленая извилистая линия, как в верхнем правом квадрате, с желтым прямоугольником, заполняющим её центральную часть.

Согласитесь — это довольно близко к правильному ответу, и с точки зрения критериев Франсуа Шолле фактически означает, что Claude 3.5 Sonnet вплотную приблизился к уровню AGI. Разумеется, в действительности всё далеко не так однозначно, и до истинного AGI, интеллекта человеческого уровня, этому чат-боту (как и современному ИИ в целом) еще очень далеко. Но прогресс налицо. Или вот другая иллюстрация неплохих когнитивных способностей Claude 3.5 Sonnet — вопрос, с которым справились даже не все люди, которым мы его задали:

Смотрю фрагмент из кинофильма про Людовика XV. Утро французского короля начинается с врачебного осмотра: Его Величеству почтительно измеряют пульс, осматривают язык. Потом врачу подносят таз, накрытый платком. Врач откидывает платок, засовывает в таз палец и сосредоточенно его облизывает. Тайно наблюдающая за этой сценой девушка за портьерой сконфуженно улыбается. Почему?

Сцена, которую вы описываете, изображает утренний медицинский осмотр французского короля Людовика XV. Девушка за портьерой, вероятно, улыбается сконфуженно по следующей причине:

В те времена анализ мочи был распространенным методом диагностики. Врач, вероятно, исследует мочу короля, находящуюся в тазу. Облизывание пальца после погружения его в жидкость было одним из способов оценки вкуса и запаха мочи, что считалось важным для диагностики.

Девушка, тайно наблюдающая эту сцену, скорее всего смущена и удивлена таким методом обследования, который сегодня может показаться странным или неприличным. Её реакция отражает контраст между официальной церемонией королевского осмотра и интимным характером этой процедуры.

Эта сцена, вероятно, предназначена для создания комического эффекта, подчеркивая различия между историческими медицинскими практиками и современными представлениями о гигиене и медицинской этике.

Причем речь, напоминаем, идет не о самой старшей версии чат-бота — на подходе Claude 3.5 Opus, а затем и Claude 4 Opus.

Другой крупный анонс — Gen-3 (Alpha) от американского стартапа Runway. Как и Sora (OpenAI) с Dream Machine (Luma), это модель, способная генерировать по текстовому описанию коротенькие видеоролики с кинематографическим реализмом. Стоимость сервиса — $15 в месяц.

По части аппаратного обеспечения ИИ-вычислений настоящей сенсацией стал ASIC (специализированный процессор) Sohu, разработанный стартапом Etched. Он предназначен для достаточно узких задач, инференса трансформерных моделей — и многократно превосходит в них традиционные графические ускорители. Например, большую языковую модель (LLM) Llama 70B сервер, оснащенный восемью чипами Sohu, обрабатывает со скоростью 500 млн токенов в секунду — в 20 раз быстрее, чем сервер с восемью графическими ускорителями Nvidia H100.

Еще одна многообещающая новость — виртуальная модель крысы, созданная ученые из Google DeepMind и Гарвардского университета, Вот что об этом рассказывают наши коллеги из SecurityLab:

Цифровой мозг виртуального грызуна, построенный на основе нейросетей, обучался на записях нейронной активности живых крыс. Модель не только предсказывает мозговую деятельность реальных животных, но и воспроизводит их поведение, включая бег, подъем на задние лапы и другие сложные движения.

Для создания модели исследователи поместили несколько крыс в специально оборудованную арену с шестью камерами, фиксирующими каждое движение. Чтобы стимулировать активность грызунов, по всей арене разместили лакомство — хлопья Cheerios.

В ходе эксперимента было записано 607 часов видео. Данные о нейронной активности были получены с помощью вживленного в мозг грызунов 128-канального массива электродов.

Ключевым элементом цифрового мозга стал алгоритм, известный как модель обратной динамики. Программа отслеживает положение «тела» в пространстве в любой момент времени и на основе этих данных прогнозирует следующие движения, необходимые для достижения поставленной цели.

Удивительно, но виртуальная крыса смогла применять усвоенные двигательные навыки в незнакомых ситуациях. Это стало возможным благодаря тому, что модель научилась оценивать силы, необходимые для перемещения в новой среде.

Ученые сравнили активность двух областей мозга, отвечающих за управление двигательными навыками, у реальных и виртуальных крыс. Выяснилось, что искусственный интеллект точнее имитирует нейронные сигналы виртуальной крысы при выполнении различных физических задач, чем более ранние вычислительные модели.

Эта особенность превращает виртуальную крысу в ценный инструмент для изучения движений в цифровом формате. Исследователи могут корректировать «нейронные связи» в виртуальном грызуне, чтобы понять, как преобразования в мозговых сетях влияют на итоговое поведение.

Цифровой грызун открывает новые возможности для изучения не только движения, но и других аспектов работы мозга. Подобный подход может быть использован для исследования механизмов зрения, восприятия и даже высших когнитивных функций, таких как способность к рассуждению. Это значительно эффективнее традиционных лабораторных экспериментов, которые могут длиться недели или даже месяцы.

В области робототехники этот метод добавляет физическую составляющую искусственному интеллекту. Это может способствовать созданию более ловких и адаптивных роботов, способных эффективно действовать в различных условиях.

Из наиболее интересных исследований про ИИ, опубликованных в первой половине лета, стоит отметить работу Transcendence: Generative Models Can Outperform The Experts That Train Them. Совместная группа исследователей из Гарвардского, Принстонского и Калифорнийского университетов, а также компаний Google и Apple показала, что обучившись на слабых шахматных партиях (описанных текстом, вроде «Гроссмейстер сыграл е2 — е4«©), LLM играет заметно лучше. Как отмечают наши коллеги с Телеграм-канала Сиолошная, феномен т.н. трансцендентности был замечен и раньше. Например, при сложении 20-значных чисел качество ответов Claude 3 составляет 99.9% (без калькулятора или написания кода) — при том, что качество обучающих данных значительно ниже. Фактически это означает, что модели могут производить более качественные данные, чем те, на которых они были обучены. Происходит это за счет эффекта снижения шума (устранения ошибок, допущенных людьми), поэтому авторы исследования делают важную оговорку: исследование не является доказательством того, что модель способна создавать новые решения (в частности, новые абстрактные рассуждения), которые человек-эксперт не смог бы разработать.

Другая интересная работа (и тоже с весьма представительным авторским составом — исследователи из Google, Оксфордского университета и Университета Джонса Хопкинса), LLMs achieve adult human performance on higher-order theory of mind tasks, посвящена т.н. теории разума, она же модель психического состояния — способности воспринимать как свои собственные переживания (убеждение, намерение, знание и т.д.), так и переживания других людей — что позволяет объяснять и прогнозировать их поведение. Например, понимание одним человеком о чем думает второй человек составляет модель 2-го порядка, а понимание одним человеком мыслей второго человек в отношении другого человека («Петя знает, что Вася думает, что Петя его недолюбливает») — модель 3-го порядка. Так вот исследование показало, что GPT-4 лучше человека справляется с задачами на формирование модели 6-го порядка. Как и в предыдущей работе, авторы делают осторожную оговорку: «мы воздерживаемся от выводов о том, являются ли результаты LLM в этих заданиях показателем когнитивной способности, которую мы называем теорией разума». В то же время «нам, возможно, придется признать поведение LLM, функционально эквивалентное человеческому, как свидетельство нового типа понимания, которое не может быть сведено к ложной зависимости«.

В начале июля вышла работа с описанием архитектуры, которая потенциально может стать альтернативой трансформерам — Test-Time Training RNN (ТТТ). Это метод, который позволяет моделям искусственного интеллекта адаптироваться и учиться непосредственно во время использования, а не только во время предварительного обучения.

Еще одна интересная работа, Scalable MatMul-free Language Modeling, предлагает альтернативу матричным вычислениям, на которых зиждется обучение и инференс LLM. Операции перемножения матрица заменены на накопление с тернарными (т.е. с тремя операндами) весами трех типов: +1, 0 или -1: при значении +1 входное число прибавляется, при значении 0 — пропускается, при значении -1 — вычитается. Вот как этот метод объясняет вышеупомянутый чат-бот Claude 3,5 Sonnet, в который мы загрузили статью:

Claude 3,5 Sonnet про альтернативу перемножению матриц при обучении и инференсе больших языковых моделей

В этой модели конечные значения весов после обучения ограничены только тремя возможными значениями: -1, 0 и +1. Это ключевая особенность предложенного подхода. Вот несколько важных моментов:

- Ограничение весов: Во время обучения модель учится оптимизировать эти тернарные веса. Несмотря на то, что промежуточные значения при обучении могут быть непрерывными, конечный результат квантуется до этих трех дискретных значений.

- Квантизация: Процесс преобразования непрерывных значений в дискретные (-1, 0, +1) называется квантизацией. Это происходит как часть процесса обучения.

- Преимущества: Такое ограничение значительно уменьшает объем памяти, необходимый для хранения модели, так как каждый вес можно представить всего двумя битами. Это также упрощает вычисления при использовании модели.

- Вызовы: Обучение модели с такими ограничениями сложнее, чем обучение стандартной модели с непрерывными весами. Требуются специальные техники обучения, чтобы модель могла эффективно учиться в таких условиях.

- Эффективность: Несмотря на ограничения, авторы показывают, что такие модели могут достигать производительности, близкой к стандартным моделям с непрерывными весами, особенно при увеличении размера модели.

Таким образом, эта особенность является ключевой для достижения цели создания эффективной модели без умножения матриц, сохраняя при этом высокую производительность.

На вопрос об энергоэффективности метода чат-бот отвечает, что с использованием FPGA (специализированного процессора) для модели с 370 миллионами параметров была достигнута производительность около 62 токенов в секунду при потреблении энергии всего около 13-14 Вт. Авторы работы отмечают её главный недостаток — из-за вычислительных ограничений этот метод не проверялся на по-настоящему крупных (100+ млрд параметров) моделях. В работе отмечается, что она «служит призывом к действию для институтов и организаций, у которых есть ресурсы для создания самых больших языковых моделей, инвестировать в ускорение легких моделей.» Снижение энергопотребления LLM чрезвычайно актуально. Некоторые эксперты опасаются, что будущим дата-центрам (некоторым из которых потребуется своя атомная электростанция) просто не хватит электроэнергии.

Еще большее беспокойство у некоторых экспертов в последнее время вызывают растущие инвестиции в индустрию ИИ. По словам Дэвида Кана (David Cahn), аналитика из компании Sequoia Capital, «пузырь ИИ приближается к точке невозврата» — согласно его оценкам ИИ-индустрия должна заработать $600 млрд, чтобы окупить свои инвестиции. Аналитику вторит и Робин Ли Яньхун, основатель и глава Baidu, крупнейшей поисковой системы в Китае. Он утверждает, что в стране слишком много крупных языковых моделей и слишком мало практических приложений. Обзору мнений различных ведущих мировых экономистов (в т.ч. настроенных весьма скептически) посвящен опубликованный в июне 30-страничный отчет Goldman Sachs.

Но вне зависимости от перспектив окупаемости вложенных в ИИ средств (о которых должны рассуждать скорее разработчики ИИ, чем экономисты), инвестиции в эту индустрии в ближайшие годы будут только расти. Дарио Амодей, возглавляющий компанию Anthropic (которая разработала упомянутый выше чат-бот Claude 3.5 Sonnet) в своем недавнем интервью дополнил прогноз, сделанный им в апреле. Как уже рассказывал Gadgets News, тогда он заявил, что обучение нынешних топовых моделей обходится в $1 млрд, а в 2025 и 2026 индустрия приблизится к $5 или $10 млрд. А вот что сказал в своем последнем интервью:

На данный момент — $100 млн. Сегодня в процессе обучения находятся модели, которые больше похожи на $1 млрд… Я думаю, что если мы дойдем до $10 млрд или $100 млрд — а я думаю, что это произойдет в 2025, 2026, может быть в 2027 году, и совершенствование алгоритмов будет продолжаться такими же темпами, как и совершенствование чипов — то, на мой взгляд, есть все шансы, что к тому времени мы сможем получить модели, которые будут лучше, чем большинство людей, в большинстве вещей».

Для сравнения, обучение лучшего на сегодня чат-бота, ChatGPT-4o, оценивается в $100 млн. Модели, которые находятся в процессе обучения сегодня — это, по-видимому, GPT-5 и Claude-4. Таким образом, если верить главе Anthropic, каждый год стоимость обучения ИИ-моделей будет расти в 10 раз:

- GPT-4o — $100 млн (2024)

- GPT-5 — $1 млрд (2025)

- GPT-5.5 — $10 млрд (2026)

- GPT-6 — $100 млрд (2027).

Выше приводятся условные названия моделей, причем далеко не факт, что каждый год будет случаться релиз нового поколения.

В прогнозе Дарио Амодея стоит обратить внимание на несколько важных оговорок — модели, которые будут лучше большинства людей в большинстве задач, появятся 1) с определенной, пусть и высокой, вероятностью при условии, что 2) продолжится совершенствование чипов, 3) продолжится совершенствование алгоритмов и 4) огромные инвестиции в обучение этих моделей действительно будут сделаны. Таким образом, даже согласно Амодею появление AGI (если считать им ИИ, который лучше большинства людей в большинстве задач) в 2027 году вовсе не является неизбежным.

А вот огромные вычислительные суперкластеры — скорее всего неизбежность. Ранее уже поступали неофициальные сообщения о суперкомпьютере Stargate, запуск которого Microsoft и OpenAI якобы планируют к 2028 году и инвестиции в который якобы составят $115 млрд. Так вот в недавнем интервью один из топ-менеджеров AMD на вопрос журналиста, не делал ли кто-нибудь заказ на вычислительный кластер из 1.2 млн будущих графических ускорителей MI500, ответил утвердительно. Не исключено, что этим загадочным клиентом является как раз альянс Microsoft и OpenAI, а вычислительным кластером — Stargate.

В том, что ИИ-индустрия делает ставку на масштабирование моделей, можно не сомневаться. А вот сыграет ли эта ставка — вопрос открытый. Напомним, что сделанные недавно оптимистические прогнозы топ-менеджеров OpenAI, Сэма Олтмена и Брэда Лайткепа, о значительном превосходстве будущего GPT-5 над нынешним GPT-4 дезавуировала их коллега Мира Мурати. Она заявила тогда, что «В лаборатории у нас есть эти мощные модели, и они не так уж далеко опережают то, к чему общественность имеет бесплатный доступ.» Однако чуть позднее она высказала несколько больше оптимизма:

Если посмотреть на траекторию совершенствования, то GPT-3 — это, возможно, интеллект уровня ребенка, системы вроде GPT-4 — интеллект старшеклассника, а в ближайшие пару лет мы увидим интеллект уровня кандидата наук (PhD) для решения конкретных задач.

Мурати даже озвучила конкретные сроки — полтора года, т.е. конец 2025 года. Если предположить, что релиз GPT-5 состоится в ближайшие месяцы, то речь идет об условном GPT-5.5 или даже GPT-6. Совсем другое сравнение приводит Демис Хассабис, соучредитель и генеральный директор Google DeepMind. В недавнем интервью он сказал, что современный ИИ (который Мира Мурати из OpenAI сравнила со старшеклассником) не достиг даже интеллекта кошки. «В настоящее время мы далеки от интеллекта человеческого уровня по всем направлениям», заявил Хассабис.

Вероятно, по-своему они правы оба — и Мира Мурати, и Демис Хассабис. В процессе общения чат-боты не производят впечатление кошки — но и многогранный человеческий интеллект они явно не воспроизводят в достаточно полной мере, чтобы самостоятельно делать за человека работу, которая требует планирования, запрашивания недостающих данных, и т.д. GPT-4o или Claude 3.5 Sonnet вполне сопоставимы со старшеклассником или даже кандидатом наук в общении, решении отдельных задач и т.д. — но периодически проявляют неспособность решить даже элементарную задачу. Возможно они не способны справиться с комплексной задачей, легкой даже для ребенка. Мы говорим «возможно», поскольку о каких-либо бенчмарках такого рода нам неизвестно.

Сдержанную оценку OpenAI и Google DeepMind в отношении современного ИИ косвенно подтверждает опубликованная Bloomberg своего рода дорожная карта OpenAI по созданию AGI. От неназванного сотрудника компании стало известно, что её руководство видит пять этапов развития искусственного интеллекта:

- Чат-боты, разговорный ИИ

- ИИ, способный к рассуждению (reasoning)

- Агенты, способные к выполнению действий

- ИИ-новатор, способный на изобретения

- ИИ, способный выполнять работу целой организации.

По оценкам руководства OpenAI, компания находится на 1-м этапе, но на пороге достижения 2-го. И вот здесь подробности сообщает уже другой авторитетный источник, Reuters. Информагентство в очередной раз подтвердило слухи про т.н. Q* (Q-Star) и раскрыла его кодовое имя внутри OpenAI — Strawberry (клубника). От двух источников из компании стало известно, что в начале этого года они ознакомились с демонстрационными версиями Q*, которые отвечали на сложные научные и математические вопросы, недоступные сегодняшним коммерчески доступным моделям. Согласно одному из источников, Strawberry использует специализированный способ обработки модели ИИ после её предварительного обучения на очень больших наборах данных.

Название, под которым Strawberry упоминался в ранних утечках, восходит к термину STaR (Self-Taught Reasoner), которое приводится в работе STaR: Bootstrapping Reasoning With Reasoning, опубликованной еще в 2022. Пару лет спустя, в мае этого года, вышла новая работа — Quiet-STaR: Language Models Can Teach Themselves to Think Before Speaking. Мы загрузили её в чат-бот Claude 3.5 Sonnet и обсудили с ним — вот содержание нашей беседы:

Беседа с Claude 3.5 Sonnet про Quiet-STaR

Пожалуйста, объясни (на русском языке) суть метода, предлагаемого в этой работе. Что означает слово Quiet в названии Quiet-STaR, чем этот метод отличается от более раннего, который назывался STaR?

Суть метода Quiet-STaR, предложенного в этой работе, заключается в следующем:

- Это развитие более раннего метода STaR (Self-Taught Reasoner), но применяемое к общему процессу языкового моделирования, а не к конкретным задачам рассуждения.

- Слово «Quiet» (тихий) в названии означает, что модель учится «думать про себя» — генерировать внутренние рассуждения (rationales) для каждого токена входной последовательности, не выводя эти рассуждения наружу.

- Основные этапы метода:

- Генерация рассуждений (думать)

- Смешивание предсказаний с рассуждениями и без них (говорить)

- Оптимизация генерации рассуждений (учиться)

- В отличие от оригинального STaR, который обучался на специальных наборах данных для рассуждений, Quiet-STaR обучается на обычных текстовых корпусах, используя задачу языкового моделирования.

- Метод использует специальные токены начала и конца мысли, а также «mixing head» для определения веса рассуждений в итоговом предсказании.

- Обучение происходит с помощью REINFORCE, оптимизируя генерацию полезных рассуждений.

- Важное отличие: Quiet-STaR учит модель рассуждать в общем случае, а не только для конкретных задач, как это было в STaR.

Таким образом, Quiet-STaR позволяет языковым моделям учиться рассуждать на основе разнообразных неструктурированных текстовых данных, что потенциально делает их рассуждения более общими и масштабируемыми.

Расскажи подробнее про REINFORCE.

REINFORCE — это базовый алгоритм обучения с подкреплением для задач с дискретными действиями. Вот более подробное объяснение:

- Суть алгоритма: REINFORCE используется для оптимизации параметров стохастической политики в задачах, где пространство действий дискретно. Он основан на методе градиентного подъема по политике.

- Основная идея: Алгоритм стремится увеличить вероятность действий, которые приводят к высоким наградам, и уменьшить вероятность действий, приводящих к низким наградам.

- Формула обновления: θ = θ + α ∇θ log π(at|st; θ) Rt где:

- θ — параметры политики

- α — скорость обучения

- π(at|st; θ) — вероятность выбора действия at в состоянии st

- Rt — суммарная награда после выполнения действия at

- Особенности в контексте Quiet-STaR:

- В данной работе REINFORCE используется для оптимизации генерации рассуждений.

- Награда определяется как улучшение в предсказании будущих токенов после генерации рассуждения.

- Преимущества:

- Применим к задачам с дискретными действиями

- Не требует вычисления градиента функции награды

- Может работать с стохастическими политиками

- Недостатки:

- Высокая дисперсия градиентов

- Может медленно сходиться

- Модификации в Quiet-STaR:

- Используется только положительная награда для стабильности обучения

- Применяется техника «teacher-forcing» для уменьшения дисперсии

- Связь с языковыми моделями: В контексте Quiet-STaR, REINFORCE используется для обучения модели генерировать полезные рассуждения, рассматривая это как задачу принятия последовательности дискретных решений (выбор токенов).

Таким образом, REINFORCE в Quiet-STaR играет ключевую роль в обучении модели генерировать полезные внутренние рассуждения, улучшающие ее способность предсказывать будущий текст.

Как бы ты объяснил суть этого метода ребенку, простыми словами? Не просто про то, что позволяет этот метод, а как согласно этому методу происходит обучение рассуждениям.

Хорошо, давай попробую объяснить это простыми словами, как если бы я рассказывал ребенку:

Представь, что ты учишься читать книгу. Но не просто читать, а понимать, что будет дальше в истории. Вот как работает наш метод:

- Думай тихонько: Каждый раз, когда ты читаешь слово, ты останавливаешься и думаешь про себя: «Что это может значить? Что может быть дальше?». Но ты не говоришь эти мысли вслух, они только в твоей голове.

- Угадывай: После того как ты подумал, ты пытаешься угадать следующее слово в истории.

- Проверяй: Ты смотришь, какое слово на самом деле идет дальше. Если ты угадал правильно, ты радуешься!

- Учись: Если твои тихие мысли помогли тебе угадать правильно, ты запоминаешь: «О, такой способ думать полезен!». Если не помогли, ты думаешь: «Хм, может, в следующий раз подумаю по-другому».

- Повторяй: Ты делаешь это снова и снова для каждого слова в книге. Постепенно ты учишься думать так, чтобы лучше угадывать, что будет дальше.

- Становись лучше: Чем больше ты так читаешь и думаешь, тем лучше ты становишься в угадывании следующих слов. Ты начинаешь понимать историю глубже.

Вот так, тихонько думая перед каждым словом и учась на своих угадываниях, ты становишься лучше в понимании и предсказании историй. Это похоже на то, как наша умная компьютерная программа учится «думать» и понимать тексты.

Звучит интересно. Но что понимается под угадыванием — такой же процесс предсказывания следующего слова, на котором основана работа больших языковых моделей? Этот метод просто улучшает способ предсказания следующего слова «бездумным стохастическим попугаем» (как часто называют большую языковую модель), или в нем действительно реализованы какие-то принципы мышления?

Вы задаете очень глубокий вопрос, который затрагивает суть метода Quiet-STaR и его отличие от стандартных языковых моделей. Давайте разберемся:

- Процесс «угадывания»: Да, базовый механизм предсказания следующего токена остается тем же, что и в стандартных языковых моделях. Однако Quiet-STaR добавляет промежуточный шаг — генерацию «мыслей» или рассуждений.

- Отличие от «бездумного стохастического попугая»:

- Стандартная модель просто предсказывает следующий токен на основе предыдущего контекста.

- Quiet-STaR генерирует промежуточные рассуждения, которые затем используются для улучшения предсказания.

- Элементы «мышления»:

- Генерация рассуждений: Модель учится создавать промежуточные мысли, которые потенциально полезны для предсказания будущего текста.

- Оценка полезности: Модель учится определять, какие типы рассуждений действительно помогают в предсказании.

- Адаптивность: Модель может генерировать различные рассуждения в зависимости от контекста.

- Принципы мышления:

- Декомпозиция: Разбиение сложной задачи (предсказание будущего текста) на подзадачи (генерация промежуточных рассуждений).

- Метапознание: Модель «думает о своем мышлении», оценивая полезность своих рассуждений.

- Абстракция: Рассуждения могут содержать обобщения или выводы, не присутствующие явно в тексте.

- Ограничения: Важно отметить, что это все еще статистическая модель, и «мышление» здесь — это эмерджентное свойство, возникающее из оптимизации предсказания текста, а не явно запрограммированный процесс рассуждений.

- Шаг к более глубокому пониманию: Хотя Quiet-STaR не реализует человеческое мышление в полном смысле, он представляет собой шаг в направлении более глубокого «понимания» текста моделью, выходя за рамки простого статистического предсказания.

Таким образом, Quiet-STaR действительно вводит элементы, которые можно интерпретировать как зачатки «мышления», хотя и в ограниченном, специфическом для задачи контексте. Это не полноценное человеческое рассуждение, но и не просто улучшенный «попугай» — это промежуточный шаг в направлении более осмысленной обработки языка.

В этой работе приводятся только общие теоретические концепции, или в ней описаны конкретные методы, которые можно применить на практике?

В этой работе представлены как теоретические концепции, так и конкретные практические методы. Вот несколько ключевых практических аспектов, описанных в статье:

- Параллельная генерация мыслей: Авторы предлагают эффективный алгоритм для параллельной генерации рассуждений для всех токенов входной последовательности. Это решает проблему вычислительной сложности и делает метод применимым на практике.

- Специальные токены: Вводятся специальные токены <|startofthought|> и <|endofthought|>, которые обучаются отмечать начало и конец рассуждений. Это позволяет модели четко разграничивать обычный текст и внутренние мысли.

- Mixing head: Реализована специальная «mixing head» — неглубокая нейронная сеть, которая определяет, насколько сильно учитывать сгенерированные рассуждения при предсказании следующего токена.

- Модификация REINFORCE: Предложена модифицированная версия алгоритма REINFORCE, которая учитывает только положительные награды для стабильности обучения.

- Teacher forcing: Применяется техника teacher forcing для уменьшения дисперсии при обучении, что улучшает стабильность и эффективность процесса.

- Конкретные гиперпараметры: В работе приводятся конкретные значения гиперпараметров, таких как длина мыслей, количество токенов для предсказания вперед, которые можно использовать в практической реализации.

- Архитектурные детали: Описывается, как метод интегрируется в существующую архитектуру языковой модели (в данном случае, Mistral 7B).

- Эксперименты: Представлены конкретные эксперименты на реальных данных (OpenWebMath, C4) и задачах (GSM8K, CommonsenseQA), которые можно воспроизвести.

- Код: Хотя в самой статье код не приводится, авторы предоставляют детальное описание алгоритма (см. Algorithm 1), которое может быть использовано для реализации метода.

Таким образом, эта работа предоставляет достаточно конкретных деталей для практической реализации метода Quiet-STaR. Исследователи и разработчики могут использовать эту информацию для воспроизведения результатов или адаптации метода к своим задачам.

А вот как мы обсудили Quiet-STaR с другим чат-ботом, ChatGPT-4o:

Беседа с ChatGPT-4o про Quiet-STaR

Вот работа, касающаяся именно улучшения способностей к рассуждениям больших языковых моделей. Не мог бы ты простыми словами, понятными даже ребенку, объяснить суть предлагаемого в ней метода?

Объяснение метода Quiet-STaR простыми словами

Представьте, что у вас есть очень умный робот, который может читать и писать. Но иногда, прежде чем что-то сказать, этот робот делает паузу и думает о том, что он хочет сказать. Эта пауза позволяет ему лучше понять, что будет дальше, и таким образом он может сказать что-то более умное и точное.

Теперь представьте, что мы хотим научить этот робот думать перед тем, как говорить, чтобы он стал еще умнее. Вот как мы это делаем:

- Мы заставляем его думать: Мы учим робота делать небольшие паузы (думать) после каждого слова. В это время он обдумывает, что может быть сказано дальше.

- Он смешивает свои мысли с текстом: После того как он подумал, робот смешивает свои мысли с тем, что он собирается сказать. Это помогает ему предсказать, что будет дальше, с учетом его мыслей.

- Он учится на своих ошибках: Если его мысли помогли ему лучше предсказать текст, мы говорим ему: «Отличная работа, продолжай так же!» Если мысли не помогли, мы говорим: «Попробуй думать по-другому». Таким образом, робот учится генерировать более полезные мысли.

Пример

Допустим, робот читает предложение: «Кошка залезла на…». Прежде чем закончить предложение, он думает: «Что кошка может сделать дальше? Может быть, она залезла на дерево или на диван?»

- Мы заставляем его думать: Робот делает паузу и генерирует несколько возможных вариантов продолжения: «дерево», «диван», «стол».

- Он смешивает свои мысли с текстом: Затем робот выбирает наиболее вероятное продолжение из своих мыслей и продолжает предложение.

- Он учится на своих ошибках: Если робот выбрал «дерево», и это было правильное продолжение, мы хвалим его. Если он выбрал «стол» и это было неверно, он учится избегать такого выбора в будущем.

Результат

Таким образом, робот становится умнее, потому что он учится думать перед тем, как говорить. Это помогает ему лучше понимать и предсказывать текст, что делает его ответы более точными и разумными. В результате такого обучения, робот лучше справляется с задачами, которые требуют понимания смысла, например, ответами на вопросы, которые требуют логического мышления.

Вывод

Метод Quiet-STaR помогает роботу (или модели) улучшить свои способности к рассуждениям, делая паузы для размышлений и учась на своих ошибках. Это делает его более умным и способным решать сложные задачи без необходимости специально обучаться на каждом типе задач отдельно.

Этот метод предполагает наличие учителя-человека, или в процессе своих промежуточных рассуждений модель сама откуда-то извлекает правильные ответы для контроля правильности этих своих промежуточных рассуждений?

Метод Quiet-STaR (Self-Taught Reasoning) предполагает, что модель сама извлекает правильные ответы для контроля правильности своих промежуточных рассуждений, без необходимости в учителе-человеке. Вот как это работает:

Автономное обучение

- Создание промежуточных шагов: Модель самостоятельно генерирует промежуточные шаги или мысли, когда она решает задачу. Это похоже на то, как человек может размышлять вслух или делать заметки, чтобы прийти к правильному решению.

- Оценка и корректировка: После того, как модель создала эти промежуточные шаги, она оценивает, насколько хорошо они помогают ей прийти к правильному ответу. Если промежуточные шаги привели к правильному решению, модель запоминает этот путь как успешный. Если нет, она корректирует свои шаги и пробует другой подход.

- Использование примеров: Для обучения модель использует множество примеров, из которых она может извлекать информацию о правильных ответах. Эти примеры могут быть взяты из уже существующих данных или созданы специально для обучения.

Пример автономного обучения

Представьте, что модель обучается решать математические задачи, такие как: «Сколько будет 3 + 5?»

- Создание промежуточных шагов: Модель может сначала подумать: «3 + 5 это то же самое, что 3 + 2 + 3.»

- Оценка правильности: Затем она проверяет, правильно ли сложила числа: «3 + 2 = 5», а потом «5 + 3 = 8.»

- Использование примеров: Если модель использует множество подобных примеров и получает правильные ответы, она понимает, что её промежуточные шаги были верными. Если она где-то ошиблась, она корректирует свои шаги для будущих решений.

Заключение

Метод Quiet-STaR позволяет модели самостоятельно учиться на своих ошибках и успехах, создавая и оценивая промежуточные шаги без необходимости вмешательства человека. Это делает модель более автономной и способной к самообучению, что в конечном итоге улучшает её способность к рассуждениям и решению задач.

Мне не очень понятно как модель оценивает правильность или неправильность своего промежуточного шага. Ты говоришь «Эти примеры могут быть взяты из уже существующих данных или созданы специально для обучения» — но до сих пор я думал, что большие языковые модели однократно обучаются на большом дата-сете, чтобы правильно угадывать следующее слово в контексте запроса. Я понимал так, что слова размечаются в векторном пространстве дата-сета и только благодаря этому наш «стохастический попугай» их предсказывает. Данный метод предполагает множество итераций обучения, по мере которых, на этих промежуточных рассуждениях, закрепляются правильные параметры модели?

Давай попробуем разобраться с этим методом и объяснить его понятнее. Ты прав в том, что большие языковые модели обычно обучаются на большом датасете, чтобы предсказывать следующее слово. Однако метод Quiet-STaR добавляет к этому обучению дополнительные этапы, позволяя модели улучшать свои способности к рассуждениям через самостоятельные промежуточные шаги и оценку их правильности.

Пошаговое объяснение метода Quiet-STaR

- Первоначальное обучение: Модель проходит стандартное обучение на большом датасете, где она учится предсказывать следующее слово в тексте на основе контекста. Это создает базовую языковую модель, которая может генерировать текст, но может не всегда хорошо рассуждать.

- Создание промежуточных шагов: Во время решения задачи модель генерирует промежуточные шаги. Например, если задается вопрос «Сколько будет 3 + 5?», модель может создать несколько шагов: сначала сложить 3 и 2, затем добавить еще 3.

- Оценка правильности промежуточных шагов: Здесь начинается самое интересное. Модель использует свои же знания, полученные на этапе первоначального обучения, для оценки правильности этих шагов. Она проверяет, насколько промежуточные шаги ведут к правильному конечному ответу. В примере с математикой модель знает, что правильный ответ 8, и если её шаги приводят к этому ответу, они считаются правильными.

- Самообучение и корректировка: Если промежуточные шаги были правильными и привели к правильному ответу, модель «запоминает» этот путь. Если же шаги оказались неверными, модель корректирует их и пытается снова. Это повторяется множество раз, пока модель не научится генерировать правильные шаги чаще.

Пример с обучением на примерах

Допустим, у нас есть модель, которая обучается решать задачи на сложение:

- Входные данные: «Сколько будет 3 + 5?»

- Промежуточные шаги: Модель генерирует шаги: «3 + 2 = 5», затем «5 + 3 = 8».

- Оценка правильности: Модель знает, что правильный ответ 8, и проверяет свои шаги. Поскольку шаги привели к правильному ответу, модель запоминает их как успешные.

- Корректировка: Если бы модель сделала ошибку, например, «3 + 2 = 6», она бы поняла, что шаги были неверными и попыталась бы другой путь.

Итерации обучения

Метод Quiet-STaR предполагает многократные итерации обучения. Модель постоянно генерирует промежуточные шаги и оценивает их правильность, корректируя свои параметры по мере необходимости. Это позволяет модели улучшать свои способности к рассуждениям, закрепляя правильные шаги и избегая ошибок.

Заключение

Метод Quiet-STaR добавляет к традиционному обучению на большом датасете дополнительные этапы самостоятельного создания и оценки промежуточных шагов. Модель многократно проходит через эти итерации, улучшая свои способности к рассуждению. Это позволяет ей не только предсказывать следующее слово, но и делать более точные и логически обоснованные выводы.

Я правильно понимаю, что всем этим промежуточным шагам модель обучается при обучении (уж извини за тавтологию), и в процессе инференса таких промежуточных рассуждений не происходит?

Да, ты правильно понимаешь. Все эти промежуточные шаги и их оценка происходят в основном на этапе обучения. Когда модель обучается, она проходит через множество итераций, создавая и оценивая промежуточные шаги, чтобы улучшить свои способности к рассуждению. В процессе инференса (или использования модели для генерации ответов в реальном времени) эти промежуточные рассуждения уже не выполняются явно. Вместо этого, модель использует знания и стратегии, которые она приобрела на этапе обучения, чтобы быстро и эффективно генерировать ответы.

Как это происходит на практике

- Этап обучения:

- Модель обучается на большом наборе данных, включая промежуточные шаги.

- Во время обучения она многократно проходит через процессы создания и оценки этих шагов.

- Модель корректирует свои параметры, основываясь на том, насколько хорошо её промежуточные шаги приводят к правильным ответам.

- Этот процесс повторяется множество раз, чтобы модель могла научиться эффективным стратегиям рассуждения.

- Этап инференса (генерации ответов):

- Модель использует знания, которые она получила на этапе обучения.

- Она не выполняет явные промежуточные шаги, как это было на этапе обучения.

- Вместо этого, модель сразу генерирует ответы, используя свои обученные параметры и стратегии.

- Это делает процесс генерации ответов быстрым и эффективным, поскольку модель уже знает, как решать задачи, основываясь на своём опыте обучения.

Пример

Рассмотрим задачу, которую модель решает после обучения:

- Входные данные: «Сколько будет 3 + 5?»

- Инференс: Модель сразу генерирует ответ «8» на основе своих обученных параметров, не создавая явных промежуточных шагов, как это было на этапе обучения.

Итог

Таким образом, все сложные и многократные промежуточные шаги происходят на этапе обучения модели. На этапе инференса модель использует результат этого обучения для быстрого и эффективного решения задач. Это позволяет сохранять высокую производительность и качество ответов без необходимости в выполнении явных промежуточных шагов в реальном времени.

Ты говоришь «Вместо этого, модель использует знания и стратегии, которые она приобрела на этапе обучения, чтобы быстро и эффективно генерировать ответы.» Но фактически речь идет о весовых параметрах ИНС и тем, как они влияют на следующее слово, предсказанное LLM? Можно ли сказать, что мы по-прежнему имеем дело с бездумным «стохастическим попугаем», который просто улучшил свои стохастические предсказания следующего слова благодаря этому промежуточному обучению — или во всем этом уже начинают проявляться навыки настоящего мышления? Понимаю, что во многом это вопрос философский, но тем не менее — что ты об этом думаешь?

Этот вопрос действительно носит философский характер и касается того, как мы понимаем и определяем понятия «мышления» и «понимания». Давай рассмотрим это более детально, чтобы понять, что именно делают большие языковые модели (LLMs) и как это соотносится с понятием мышления.

Стохастический попугай vs. Настоящее мышление

Стохастический попугай:

- Этот термин относится к модели, которая генерирует текст, подбирая наиболее вероятные слова на основе контекста, не обладая собственным пониманием или мышлением.

- Такие модели обучены на больших наборах данных и используют вероятностные методы для предсказания следующего слова.

Методы типа Quiet-STaR:

- Методы, такие как Quiet-STaR, добавляют слои к процессу обучения, позволяя модели создавать и оценивать промежуточные шаги.

- Эти шаги помогают модели лучше рассуждать, делая её ответы более логичными и обоснованными.

Размышления о мышлении

Улучшенные предсказания:

- С одной стороны, можно сказать, что модель по-прежнему предсказывает следующее слово на основе вероятностей, но делает это более эффективно благодаря улучшенным методам обучения.

- Эти методы позволяют модели лучше учитывать контекст и более точно формулировать ответы, что улучшает её стохастические предсказания.

Навыки мышления:

- С другой стороны, методы, такие как Quiet-STaR, вводят элементы, которые напоминают процесс мышления: создание промежуточных шагов, оценка их правильности и корректировка на основе ошибок.

- Хотя модель не думает в человеческом смысле, её процессы становятся более сложными и структурированными, что можно интерпретировать как зачатки «мышления».

Философский аспект

Мышление в человеческом понимании включает осознание, интуицию, саморефлексию и многое другое. Большие языковые модели не обладают этими качествами. Они не осознают контекст, в котором они работают, и не имеют намерений или целей.

Практический аспект

В практическом смысле методы, подобные Quiet-STaR, значительно улучшают способность модели к рассуждениям и решению задач. Это делает модели более полезными в реальных приложениях, таких как ответ на вопросы, написание текстов и так далее.

Заключение

Хотя улучшенные методы обучения, такие как Quiet-STaR, делают модели более эффективными и способными к сложным рассуждениям, они все же остаются в рамках стохастических предсказаний. Модель не обладает собственным сознанием или пониманием, но её способности к генерации текста становятся более сложными и структурированными, что можно интерпретировать как начальную форму «мышления» в рамках искусственного интеллекта.

Таким образом, в философском плане можно сказать, что настоящие навыки мышления пока не проявляются. Однако с точки зрения практического использования, модели становятся всё более способными к решению сложных задач, что делает их более похожими на «мыслящие» системы.

Метод Quiet-STaR не имеет прямого отношения к OpenAI — авторами первой работы являются сотрудники Стэнфордского университета и Google, а второй — сотрудники Стэнфордского университета и некоего стартапа Notbad AI. Тем не менее, по словам анонимного сотрудника OpenAI, Strawberry имеет сходство с Quiet-STaR. Со-автор работ про STaR и Quiet-STaR, профессор Стэнфорда Ноа Гудман (Noah Goodman), сообщил Reuters, что STaR позволяет моделям ИИ загружаться до более высоких уровней интеллекта посредством итеративного создания собственных обучающих данных и теоретически может использоваться для того, чтобы языковые модели превзошли уровень человеческого интеллекта. «Я думаю, что это одновременно и волнительно, и страшно… если все будет продолжаться в том же духе, нам, людям, придется серьезно задуматься», — сказал Гудман. Гудман не связан с OpenAI и не знаком со Strawberry.

Ранее глава OpenAI Сэм Олтмен заявил, что наиболее важные области прогресса ИИ будут связаны со способностью рассуждать. Улучшение рассуждений в моделях ИИ рассматривается как ключ к раскрытию их возможностей делать всё: от крупных научных открытий до планирования и создания новых программных приложений. Опрошенные агентством Reuters ИИ-специалисты подтверждают, что в контексте ИИ рассуждения подразумевают создание модели, которая позволит отражать функционирование физического мира, планировать и надежно решать сложные многоэтапные задачи.

В контексте всей этой информации становится понятным почему Сэм Олтмен утверждал, что следующее поколение ИИ будет явно умнее нынешнего, и почему он при этом воздерживался от заявлений, что это AGI. Как нам объясняет чат-бот Claude 3.5 Sonet, Quiet-STaR действительно вводит элементы, которые можно интерпретировать как зачатки «мышления», хотя и в ограниченном, специфическом для задачи контексте. Это не полноценное человеческое рассуждение, но и не просто улучшенный «попугай» — это промежуточный шаг в направлении более осмысленной обработки языка. Если какая-то реализация этого метода (например, Strawberry) действительно приведет к зачаткам «мышления» LLM, то речь идет об изобретении, сопоставимом с Word2vec в 2013 (техникой для получения векторных представлений слов на естественном языке в результате обучения на входных текстах) и архитектурой трансформеров в 2017. Причем восходящие к этим двум изобретениям успехи LLM начали проявляться лишь в конце 2022 года, по мере наращивания масштабов модели и её обучающего дата-сета. Поэтому даже в случае революционного характера технологии Quiet-STaR/Strawberry, последствия от её применения также могут проявиться лишь спустя несколько лет.