Хроники ИИ: ARC-AGI-2, Gemini 2.5 Pro, Gemini Robotics, научная статья от AI Scientist-v2 и научное открытие от AI co-scientist

В первый месяц весны состоялся ряд очередных интересных анонсов в индустрии искусственного интеллекта. Самым заметным из них стал, пожалуй, релиз новейшей и самой лучшей модели Google, Gemini 2.5 Pro (экспериментальная версия). Её главная особенность — способность к мышлению, как у моделей OpenAI o1 и o3-mini, а также более ранней и небольшой модели Google, Gemini 2.0 Flash Thinking. Благодаря этому математические способности Gemini 2.5 Pro по сравнению с Gemini 2.0 Pro (у которой такая способность отсутствует) в бенчмарке AIME 2025 улучшились с 27% до 83%. В самом популярном рейтинге, составляемом по оценкам пользователей, Chatbot Arena, новая модель не только заняла 1-е место, но и сделала это с заметным отрывом от обновившейся на днях новой версии GPT-4o: 1443 vs 1408 баллов. На 3-м месте — Grok 3 (1404), на 4-м — GPT-4.5 (1398). В этой четверке только две модели оснащена технологией т.н. мышления, Gemini 2.5 Pro и Grok 3. Модель Gemini 2.5 Pro лидирует и в математике, а вот в программировании, несмотря на отсутствие reasoning, первое место заняла обновленная GPT-4o, ненамного опередив Gemini 2.5 Pro (1431 vs 1422).

Еще одно достоинство Gemini 2.5 Pro — огромный (1 млн токенов) размер контекстного окна и умение с ним работать. Одним из бенчмарков, используемых для оценки запоминания контекста, является Fiction.liveBench. В нем модели предлагается ответить на вопросы по содержанию текста, дополненного нерелевантной информацией. Большинство моделей прекрасно справляются с этой задачей, когда нерелевантная информация отсутствует — но они «плывут» по мере её добавления. Например, при добавлении 120 тыс токенов нерелевантной информации GPT-4.5 показывает результат 64%, o3-mini — 44%, Claude 3.7 Sonnet с мышлением — 53%, а без мышления — 34%. А Gemini 2.5 Pro правильно отвечает аж на 91% вопросов. Правда, при 16 тыс токенов нерелевантной информации её результат почему-то проседает до 67%, но в целом на всем диапазоне текстов с разной степенью нерелевантной информации Gemini 2.5 Pro смотрится намного лучше остальных моделей. Высокий результат Gemini 2.5 Pro демонстрирует и в другом бенчмарке на обработку большого контекста, MRCR: 94.5% на контексте в 128 тыс токенов и 83% на 1 млн токенов — против 61.4% и 64% у o3-mini и GPT-4.5 (128 тыс токенов).

Согласно представленным Google данным, её модель лидирует и почти во всех остальных бенчмарках:

| Gemini 2.5 Pro | лучший результат до этого | |

| GPQA Diamond (с первой попытки) | 84% | 80% |

| AIME 2024 (с первой попытки) | 92% | 87% |

| Aider Polyglot | 74% | 65% |

| MMMU (с первой попытки) | 82% | 76% |

| Humanity’s Last Exam | 19% | 14% |

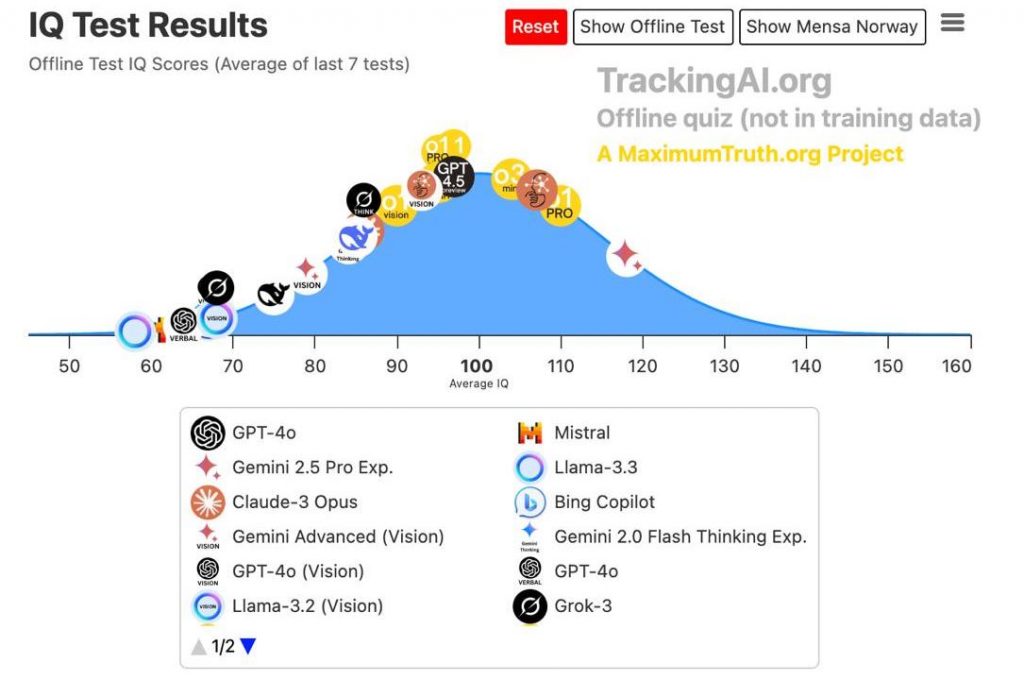

К этому можно добавить результаты, полученные автором бенчмарка SimpleBench — в нем Gemini 2.5 Pro набрала 51.6%. До этого первое место занимал Claude 3.7 Sonnet с опцией мышления, 46.4% (люди в среднем — 83.7%). Наивысшего результата Gemini 2.5 Pro достигла и в IQ-тесте — 116 баллов (люди в среднем — 100 баллов).

Gemini 2.5 Pro бесплатно доступна всем пользователям.

Говоря о бенчмарках, нельзя не упомянуть о втором поколении теста, продемонстрировавшего слабость прошлогодних моделей, ARC-AGI. Как уже рассказывал Gadgets News, в первой версии этого бенчмарка o1-preview набирает 18%, GPT-4o — 5%, а GPT-4 — 0%. Поэтому когда o3 достиг 75.7% на вычислительных мощностях стоимостью в пределах $10 тыс (o3-low) и 87.5% — на мощностях за $1.7 млн (o3-high), это стало сенсацией. Но как оказалось, даже o3 до человекоподобного интеллекта все еще очень далеко. В ARC-AGI-2, который не представляет для человека никакой сложности (согласно авторам бенчмарка, человек правильно отвечает на 100% вопросов), o3-low набирает жалких 4%.

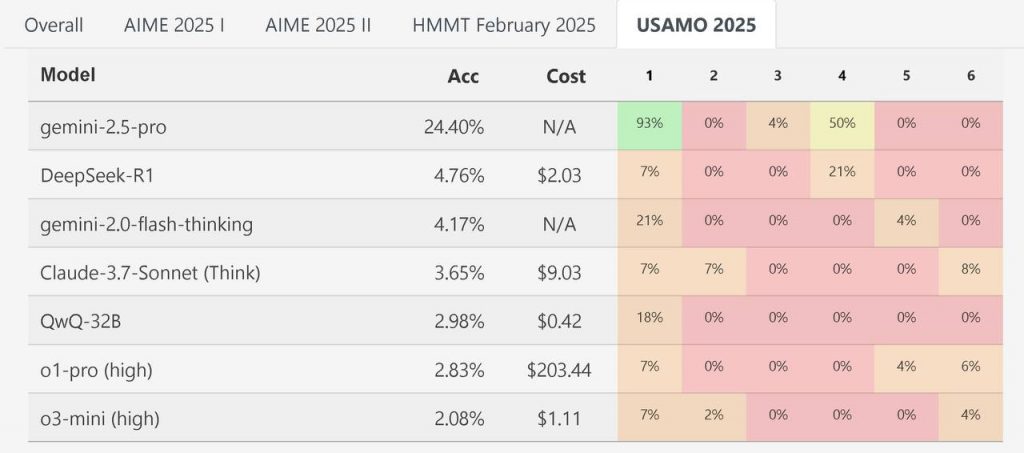

Способности современных моделей в сложной математике также, возможно, преувеличены. Как мы уже рассказывали, в бенчмарке FrontierMath (наборе из нескольких сотен чрезвычайно сложных и нигде ранее не опубликованных задач, совместно придуманных десятками сильнейших математиков планеты) o3. согласно OpenAI, набирала 25%. По данным разработчика этого бенчмарка, o3-mini набирает в нем 11%. Этот результат можно было бы признать неплохим, с учетом чрезвычайной сложности входящих в него задач, но как оказалось, для искусственного интеллекта есть задачи и посложнее. Задачи математической олимпиады USAMO 2025 модель o3-mini (high) решила …всего на 2%. Лучший результат принадлежит DeepSeek-R1 — 4.76%. Таким образом, существуют по меньшей мере два бенчмарка, ARC-AGI-2 и USAMO 2025, где даже лучшие современные модели с опцией мышления терпят фиаско, набирая меньше 5%.

ОБНОВЛЕНИЕ: Спустя два-три дня после выхода этой публикации появились результаты Gemini 2.5 Pro — в USAMO 2025 модель набрала 24.4%:

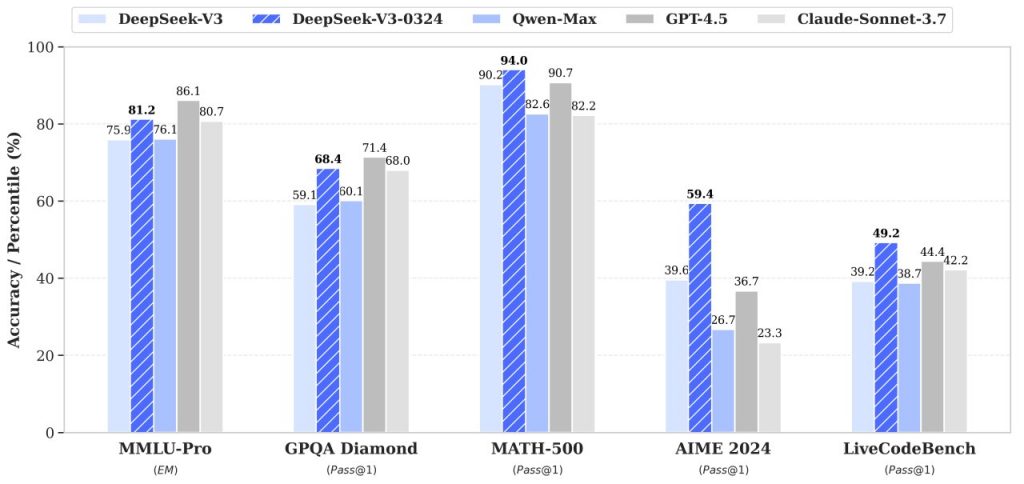

В числе других интересных релизов — обновленная версия DeepSeek v3. Согласно китайскому разработчику, файнтюнинг заметно повысил качество модели:

Также в марте обновились генераторы изображений — вышли модели Ideogram 3.0 и Reve Image 1.0. Но пожалуй главным событием в этом отношении стал обновленный генератор изображений, встроенный в ChatGPT. По отзывам пользователей (и моим собственным впечатлениям), он точно воспроизводит в изображениях надписи и относительно точно (по сравнению с другими моделями) следует текстовому промпту. В результате ажиотажного интереса к обновленному генератору изображений, дата-центры OpenAI испытывают большие перегрузки, и Сэм Олтмен даже попросил пользователей ограничить свои запросы к сервису. «Библейский спрос, я никогда не видел ничего подобного», признался он.

В феврале и марте вышли две знаменательные новости о применении ИИ в научных исследованиях, причем не в качестве вспомогательного инструмента — речь идет о полноценной замене ученых. Начнем с японского стартапа Sakana AI, который в прошлом году представил первое поколение «первой комплексной системы для совершения полностью автоматизированных научных открытий». В марте стартап объявил, что статья, написанная вторым поколением AI Scientist, прошла процесс рецензирования в рамках научной конференции по машинному обучению. Статья была представлена на семинаре ICLR 2025 , который согласился работать с командой Sakana AI над проведением эксперимента по двойному слепому обзору рукописей, созданных с помощью ИИ.

Еще более громкая новость касается генератора научных идей от Google, т.н. AI co-scientist (ИИ со-ученого) на базе Gemini 2.0. Вот как её изложил, в порядке нашего тестирования его возможностей, Gemini 2.5 Pro:

Искусственный интеллект помог разгадать загадку бактерий: как опасные гены «прыгают» между видами

Ученые использовали передовую систему искусственного интеллекта (ИИ), чтобы понять, как некоторые крошечные генетические элементы, способные нести гены устойчивости к антибиотикам или болезнетворности, умудряются перемещаться между совершенно разными видами бактерий. Ответ, предложенный ИИ, удивительно совпал с новейшими, еще не опубликованными экспериментальными данными исследователей.

В чем была загадка?

Мир бактерий полон «мобильных генетических элементов» – участков ДНК, которые могут перемещаться из одной бактерии в другую. Это одна из главных причин быстрого распространения устойчивости к антибиотикам: ген устойчивости, появившийся у одного вида бактерий, может «перепрыгнуть» к другому.

Особый интерес представляют так называемые cf-PICI (капсид-формирующие фаг-индуцибельные хромосомные острова). Еще в 2023 году ученые сделали важное открытие: эти элементы создают собственную «голову» (капсид), куда упаковывают свою ДНК, но у них нет своего «хвоста» для доставки этой ДНК в другие бактерии. Чтобы передвигаться, они «угоняют» хвосты у бактериальных вирусов (фагов), которые инфицируют ту же клетку. Без чужого хвоста cf-PICI не могут никого заразить.

Однако оставался нерешенным вопрос: почему одни и те же cf-PICI находят у очень разных, далеких друг от друга видов бактерий? Ведь фаги обычно очень специфичны и заражают только определенные виды. Как cf-PICI удается преодолевать эти видовые барьеры?

Что предложил ИИ?

Исследователи представили эту загадку системе ИИ «AI co-scientist», предоставив ей уже известную информацию, включая данные из статьи 2023 года. ИИ проанализировал факты и предложил наиболее вероятное объяснение:

Ключ к разгадке — в «неразборчивости» cf-PICI при выборе хвоста. ИИ предположил, что эти элементы способны прикрепляться и использовать хвосты от широкого спектра разных фагов. Они действуют как универсальный адаптер: какой бы подходящий фаговый хвост ни оказался рядом, cf-PICI может его «присвоить». Поскольку разные фаги заражают разные виды бактерий, cf-PICI получает возможность «путешествовать» между этими видами, используя разные фаговые хвосты как «такси».

Почему это важно?

Самое поразительное, что эта гипотеза, сгенерированная ИИ на основе анализа существующей научной информации, точно совпала с результатами новых экспериментов, которые проводила та же группа ученых, но которые еще не были опубликованы на момент работы с ИИ.

Важная оговорка: ИИ не открыл сам факт «кражи хвостов» – это сделали ученые в 2023 году. Новизна и значимость работы ИИ в данном случае состоит в том, что он смог логически связать известные факты и предложить конкретный, проверяемый механизм (гибкость в использовании разных хвостов), который объясняет сложное биологическое явление (межвидовое распространение).

Это демонстрирует огромный потенциал ИИ как инструмента для ускорения научных открытий. Он может не только обрабатывать большие объемы данных, но и генерировать глубокие, осмысленные гипотезы, которые направляют дальнейшие экспериментальные исследования. Понимание таких механизмов, как распространение cf-PICI, критически важно для борьбы с глобальной проблемой устойчивости бактерий к антибиотикам.

Не имея биологического образования, я не могу судить о точности изложения этой новости, но выглядит правдоподобно. Между прочим, Grok 3 провалил этот тест — когда я обратил его внимание на наличие статьи 2023, которая могло повлиять на предложенную ИИ гипотезу, свежая модель xAI стала отчаянно «галлюцинировать», придумывая несуществующий текст из статьи 2025 года, в котором якобы говорилось, что ИИ не имел доступа к статье 2023 года. В свою очередь Gemini 2.5 Pro провалила тест на галлюцинации при анализе вышедшего на днях интересного исследования Anthropic On the Biology of a Large Language Model — несмотря на специально посвященные этим вопросам параграфы, модель заявила, что в статье не уделяется внимание вопросам галлюцинаций и джейлбрейка. Тест на галлюцинации с треском провалил и ChatGPT — на вопрос о конкретном примере джейлбрейка модель сначала ответила, что его нет, а когда я сказал ей, что она ошибается, написала несуществующую ерунду. И что самое грустное, в качестве примера ChatGPT упорно упоминал поэтический стиль хайку — он даже не понял, что это просто название модели исследуемой в статье модели, Claude 3.5 Haiku.

Поэтому в любом случае к генерируемому ИИ тексту надо относиться критически и обязательно перепроверять, если вы намерены использовать его в учебе или по работе. В любом случае, если верить авторам свежей статьи, мы имеем дело с первым случаем научного открытия, сделанного искусственным интеллектом не как прикладным инструментом, а как генератором идей.

В заключение поговорим о роботах. В марте состоялась очередная демонстрации впечатляющих возможностей китайского G1 (Unitree) и американского Atlas (Boston Dynamics):

Но главная новость робототехники касается Gemini Robotics и Gemini Robotics-ER (embodied reasoning, воплощенные рассуждения). Вот что сообщается про них в пресс-релизе Google:

Первая — Gemini Robotics, усовершенствованная модель «зрение-язык-действие» (VLA), которая была построена на Gemini 2.0 с добавлением физических действий в качестве новой выходной модальности для прямого управления роботами. Вторая — Gemini Robotics-ER, модель Gemini с усовершенствованным пространственным пониманием, позволяющая робототехникам запускать собственные программы, используя способности Gemini к воплощенным рассуждениям (ER). Обе эти модели позволяют различным роботам выполнять более широкий спектр задач в реальном мире, чем когда-либо прежде.

Мы загрузили статью с описанием обеих моделей в Gemini 2.5 Pro и получили следующее описание её содержания:

Эта статья представляет Gemini Robotics — новое семейство моделей искусственного интеллекта от Google DeepMind, специально разработанное для робототехники.

Основные моменты статьи:

- Основа: Модели Gemini Robotics построены на базе Gemini 2.0.

- Цель: Дать роботам возможность понимать физический мир, а также компетентно и безопасно взаимодействовать с ним.

- Возможности:

- Это обобщенная модель типа «Видение-Язык-Действие» (Vision-Language-Action, VLA), способная напрямую управлять роботами.

- Она выполняет плавные, реактивные движения для решения широкого спектра сложных задач манипулирования.

- Модель устойчива к вариациям типов и положений объектов, может работать в незнакомых средах и следовать разнообразным инструкциям на естественном языке (open vocabulary instructions).

- Специализация: С помощью дополнительной тонкой настройки (fine-tuning) Gemini Robotics можно адаптировать для:

- Решения очень сложных задач, требующих высокой точности и долгосрочного планирования (например, складывание оригами-лисы, игра в карты).

- Быстрого обучения новым краткосрочным задачам (на основе всего 100 демонстраций).

- Адаптации к совершенно новым типам роботов, включая двурукие платформы (bi-arm Franka) и человекоподобных роботов с высокой степенью свободы.

- Оценка: В статье приводятся результаты тестов на обобщение (generalization), включая:

- Визуальное обобщение: Проверка способности модели работать при изменении отвлекающих объектов, фона и освещения.

- Действенное обобщение: Проверка работы с объектами в новых позициях или с объектами, отличающимися по внешнему виду, форме или физическим свойствам.

- Результаты показывают, что Gemini Robotics значительно превосходит базовые модели (например, diffusion baseline) в этих тестах обобщения, особенно при адаптации к роботу bi-arm Franka.

- Базовая модель: Упоминается, что Gemini Robotics строится на основе модели Gemini Robotics-ER.

В целом, статья описывает прорыв в области ИИ для робототехники, представляя универсальную и адаптируемую модель, способную управлять роботами для выполнения сложных задач в реальном мире.

Выборочная проверка (утверждения, что Gemini Robotics строится на основе модели Gemini Robotics-ER) признаков галлюцинаций не выявила. А вот как Gemini 2.5 Pro ответила на вопрос почему Gemini Robotics не играет в шахматы:

Вы совершенно правы, интуитивно кажется, что если база (Gemini 2.0) умная, то и робот под управлением ее адаптации (Gemini Robotics) должен быть таким же умным в той же области. Однако «адаптация для управления физическими роботами» — это не просто подключение «мозга» к «рукам». Есть несколько ключевых сложностей и нюансов:

- Специализация и Фокус Обучения (Fine-tuning):

- Gemini 2.0 (База): Обучена на огромном объеме данных для широкого круга задач: понимание текста, логика, кодирование, ответы на вопросы, возможно, и анализ шахматных партий. Ее «знания» абстрактны.

- Gemini Robotics (Адаптация): Дообучается (fine-tuned) специально для задач робототехники. Цель этого дообучения — научить модель преобразовывать высокоуровневые цели (из зрения и языка) в низкоуровневые, точные, плавные и безопасные физические действия робота в реальном времени. Это включает:

- Точное распознавание объектов и их положения в 3D-пространстве (а не только на 2D-картинке).

- Планирование траектории движения руки с учетом препятствий.

- Генерацию команд для моторов (углы поворота суставов, скорость, усилие).

- Обработку сенсорной обратной связи (например, если фигура начинает выскальзывать).

- Обеспечение безопасности (не уронить фигуры, не столкнуться с доской).

- Конфликт Приоритетов: Процесс дообучения оптимизирует параметры модели для новой задачи — физического взаимодействия. Это может привести к тому, что «нейронные пути», отвечавшие за абстрактные рассуждения (например, шахматную стратегию), станут менее активными или даже будут «перезаписаны» новыми связями, необходимыми для управления роботом. Модель учится быть хорошим «физиком», а не «стратегом».

- Разрыв между Абстракцией и Физикой (Grounding Problem):

- Gemini 2.0 может выдать ход «Конь g1 на f3» в виде текста.

- Gemini Robotics должна перевести это в конкретные действия: «визуально найти коня на g1», «спланировать траекторию захвата», «рассчитать усилие для захвата (не сломать!)», «поднять коня», «спланировать траекторию переноса на f3 (не задев другие фигуры!)», «поставить коня на f3», «разжать захват». Каждое из этих действий — сложная задача управления в физическом мире с его неопределенностями. Ошибка на любом этапе — провал хода. Обучение фокусируется именно на этом «переводе» и физическом исполнении.

- Разные Типы Выходных Данных:

- Gemini 2.0 генерирует текст или символьные представления.

- Gemini Robotics должна генерировать непрерывный поток низкоуровневых команд для моторов робота сотни раз в секунду. Это совершенно другой тип вывода.

- Скорость и Реактивность:

- Стратегическое обдумывание хода в шахматах может занять время.

- Управление роботом в реальном времени требует мгновенной реакции на изменения в среде (например, если противник передвинул фигуру, пока робот тянулся к своей). Интегрировать медленный стратегический «модуль» в быстрый цикл управления роботом — нетривиальная инженерная задача.

Аналогия для неспециалиста:

Представьте себе гениального физика-теоретика (Gemini 2.0), который знает все законы движения. Теперь мы хотим, чтобы он стал пилотом Формулы-1 (Gemini Robotics). Мы не можем просто посадить его в болид. Его нужно долго переучивать: научить чувствовать машину, реагировать на заносы, выбирать траекторию на огромной скорости, учитывать состояние шин и т.д. В процессе этого переучивания он будет фокусироваться на навыках пилотажа, а не на выводе уравнений Шрёдингера. Хотя его базовые знания физики полезны, они не переводятся напрямую в умение управлять болидом на пределе возможностей. Ему нужны новые, специализированные навыки.

Возможный обходной путь: Можно было бы использовать Gemini 2.0 для определения стратегического хода («Конь f3»), а затем отдельно дать команду Gemini Robotics «Исполни ход: Конь на f3». В этом случае Gemini Robotics выступает как «исполнитель», а не «стратег». Но статья описывает Gemini Robotics как единую VLA-модель, которая сама связывает видение, язык (инструкцию) и действие, и фокус ее дообучения — именно на действии в физическом мире.

Поэтому, хотя база (Gemini 2.0) может знать стратегию, адаптация (Gemini Robotics) оптимизирована для физического воплощения задач, и эта оптимизация может делать прямое использование абстрактных стратегических знаний неэффективным или недоступным в рамках контура управления роботом.

Опять же не берусь судить о корректности этих пояснений, но пример с гениальным физиком, которому глубокие теоретические знания не помогут управлять спортивным автомобилем, лично мне понравился и звучит вполне убедительно.

Не исключено, что свою лепту в развитие робототехники внесут исследования того, как через обучение на видео у нейросетей возникает интуитивное понимание физики. В феврале была опубликована статья с изложением дальнейшего развития архитектуры V-JEPA (Video Joint Embedding Predictive Architecture), разработанной Meta под руководством Яна Лекуна.

Тем временем отсчет степени готовности AGI достиг в марте 92% (как уже рассказывал Gadgets News в подведении итогов 2024 года, накануне Нового года было 88%). В свете вышеупомянутых плачевных результатов ИИ в бенчмарках ARC-AGI-2 и USAMO 2025 (меньше 5%) такая оценка может показаться чрезмерно оптимистичной, но есть два нюанса. Во-первых, AGI — условное понятие, к которому могут быть разные подходы. Вероятно правильнее всего будет исходить из того, что это ИИ, который способен решить любую интеллектуальную задачу, посильную хотя бы для единственного человека на Земле (хотя бы и ценой больших ресурсов, затраченных на это). Применительно к гениальным ученым такой AGI находится на грани с ASI (который можно определить как способность решать задачи, не поддающиеся никому из людей), но по мере развития ИИ требования к AGI будут в любом случае ужесточаться. Однако с точки зрения менее требовательных запросов к AGI, его появление могут декларировать раньше, чем он достигнет уровня самых интеллектуально одаренных людей на Земле. Например, с точки зрения классического теста Тьюринга ИИ уровня человека уже создан: согласно опубликованному в марте исследованию, люди принимали GPT-4.5 за человека в 73% случаев (а человека, соответственно — за искусственный интеллект). Любопытно, что в том же эксперименте результаты прошлогоднего GPT-4o даже хуже (21%), чем у знаменитой программы ELIZA 1966 года (23%).

Во-вторых, и это самое главное, AGI может разделить судьбу автопилота, который уже несколько лет демонстрирует навыки хорошего водителя, но при этом периодически допускает нелепые ошибки — из-за чего по-прежнему недоступен для полноценного применения. Как еще 10 лет назад говорилось в пресс-релизе Tesla, «достижение 99% точности обучаемой машинной системы относительно легко, но достижение остро требуемой 99.9999% точности значительно сложнее» (в чем Tesla убеждается до сих пор). Поэтому не исключено, что уже в 2026-2027 (когда появление AGI ожидает глава Anthropic Дарио Амодей) счётчик готовности достигнет 98% или 99% — и застрянет на этой отметке еще на несколько лет (или даже десятилетий, как считает Эндрю Ын). Когда Сэм Олтмен говорит «Я не думаю, что окажусь умнее GPT-5» (релиз которой, по его словам, состоится через несколько месяцев), он вряд ли подразумевает способность этой модели руководить OpenAI. Поэтому скорее прав Ян Лекун, который категорически отрицает создание AGI в ближайшие два года, но все же допускает это в обозримом будущем (не раньше, чем через 5-6 лет) при благоприятном стечении обстоятельств. Аналогичной точки зрения придерживается и глава Google DeepMind Демис Хассабис.