Хроники ИИ: GPT-5 и Grok 4

В июле и августе состоялись два важных анонса в ИИ-индустрии: 9 июля вышел Grok 4, а 7 августа — долгожданный GPT-5. Начнем с последнего.

Судя по всему, GPT-5 может смело претендовать на звание главного разочарования 2025 года. Перечислю все известные мне недостатки той или иной степени важности:

1. На презентации были допущены настолько нелепые ляпы с графиками, что они уже стали мемом.

2. Вопреки обещанию заменить набор прежних моделей на одну единую систему, это было сделано не в полной мере. Ниже перечислены преемники прежних моделей:

| было | стало |

| GPT-4o | gpt-5-main |

| GPT-4o-mini | gpt-5-main-mini |

| o3 | gpt-5-thinking |

| o4-mini | gpt-5-thinking-mini |

| GPT-4.1-nano | gpt-5-thinking-nano |

| o3 Pro | gpt-5-thinking-pro |

Обобщенно это выглядит так:

- GPT-4o, GPT-4.1, GPT-4.1-mini, GPT-4.5 → GPT-5

- OpenAI o3, o4-mini, o4-mini-high → GPT-5 Thinking

- OpenAI o3-pro → GPT-5 Pro (доступен только подписчикам тарифных планов Pro и Team).

Для бесплатных пользователей выбор модели происходит автоматически, подписчики Plus ($20 в месяц) могут вручную выбирать между GPT-5 и GPT-5 Thinking, а подписчики Pro ($200 в месяц) — между GPT-5, GPT-5 Thinking и GPT-5 Thinking Pro. С одной стороны это выглядит как гибкость и возможность самостоятельно определять тщательность решения той или иной задачи. С другой — означает ограниченную способность GPT-5 самостоятельно определять уровень сложности поставленной перед ним задачи. Это подтверждается тем, что автоматический выбор модели происходит далеко не идеально, что отчасти признал и Сэм Олтмен — по его словам, «кажется, мы кое-где основательно накосячили при запуске».

3. На другую зависимость GPT-5 от пользователя указывает его значительная чувствительность к содержанию текстового запроса — об этом свидетельствуют отзывы пользователей (отмечающих насколько лучше GPT-5 справляется с более тщательно сформулированным заданием) и специальное руководство от OpenAI.

4. Прирост интеллектуальных возможностей GPT-5 оказался довольно скромным и в отличие от первых reasoning-моделей OpenAI не вызвал «вау-эффекта». Например, при решении самых трудных задач бенчмарка по программированию LiveCodeBench Pro модель набирает всего 2.8% (хотя это лучше, чем 0.0% у o3-high). Разочарование усиливается из-за завышенных ожиданий — полгода назад Сэм Олтмен заявил, что не считаете себя умнее GPT-5. Но если вы пожалуетесь этому чат-боту, что при покупке обуви в вашей коробке вместо правой кроссовки оказалась левая, а вместо левой — правая, он не поймет подвоха и, посочувствовав, расскажет как оформить претензию…

5. Ну и пожалуй самое грустное — галлюцинации. Как уже рассказывал Gadgets News, если у GPT-5 этот показатель не претерпит существенных изменений, то это станет индикатором серьезных проблем у нынешней ставки на языковые модели в деле создания AGI. К сожалению, так и произошло — по данным самой OpenAI, в соответствующем бенчмарке SimpleQA уровень галлюцинаций сократился незначительно:

- GPT-4o (52%) → gpt-5-main (47%)

- o3 (46%) → gpt-5-thinking (40%)

Рискну утверждать, что это ключевая проблема современных систем ИИ на базе LLM, и без ее решения ни о каком появлении AGI не может быть и речи — как бы умён ни был ИИ, его неспособность сказать «не знаю» при отсутствии ответа на вопрос делает его ненадежным.

Ситуация с галлюцинациями и оптимистический настрой OpenAI в отношении этой проблемы напоминает проблему автопилота, про который немало лет обещали, что уже «вот-вот». Разве что с той разницей, что если надежность автопилота последовательно улучшается с каждым новым поколением, то ИИ, по мере того как он стал умнее, галлюцинирует даже больше (хотя непосредственно GPT-5 несколько стабилизировал эту тенденцию). При этом в OpenAI явно недооценили серьезность проблемы. «Мы решим проблему галлюцинаций; на это может уйти год или два», заявил глава OpenAI в июне 2023. Скорее всего он выразил точку зрения ведущего на то время сотрудника компании, Ильи Суцкевера:

Что касается галлюцинаций, то у него (ИИ) есть склонность время от времени выдумывать всякую ерунду, и это тоже сильно ограничивает его полезность. Но я очень надеюсь, что, просто улучшив это последующее обучение с подкреплением на основе обратной связи от человека, мы сможем научить его не галлюцинировать. Теперь вы можете сказать, действительно ли он научится? Я отвечу так: давайте узнаем.

Сегодня мы работаем так: нанимаем людей, чтобы они научили нашу нейросеть вести себя, научили ChatGPT вести себя. Вы просто взаимодействуете с ней, и она видит вашу реакцию, делает вывод: о, это не то, что вы хотели. Вы недовольны его результатом. Следовательно, результат был плохим, и в следующий раз он должен сделать что-то по-другому. Я думаю, что вероятность того, что этот подход сможет полностью устранить галлюцинации, довольно высока.

из интервью Forbes

Таким образом, релиз GPT-5 не стал переломным этапом в истории ИИ и не прибавил оптимизма сторонникам создания AGI на базе больших языковых моделей. Что не исключает решения этой проблемы в будущем (хотя отдельные научные работы утверждают обратное). В любом случае в OpenAI продолжают верить в огромный потенциал своего детища — в интервью The Verge глава компании Сэм Олтмен заявил, что «в недалеком будущем OpenAI потратит триллионы долларов на строительство центров обработки данных».

Еще одним критерием оценки ИИ является METR — бенчмарк для измерения скрытых злонамерений ИИ и его способности выполнять большие, многоэтапные задачи. Ключевые элементы этого бенчмарка:

- временной горизонт (time horizon) — время, которое требуется среднему человеку для выполнения требуемой задачи;

- уровень надежности выполнения этой задачи (50% или 80%).

По оценкам авторов бенчмарка, временной горизонт GPT-5 при 50% надежности составляет 2 ч 17 м — заметно больше, чем у модели o3 (1 ч 30 м). При этом продолжительность временного горизонта с 80% надежностью в 4-8 раз меньше, чем у временного горизонта с 50% надежностью (в случае GPT-5 прирост временного горизонта этой модели по сравнению с o3 при 80% надежности значительно скромнее — с 20 до 25 минут). По наблюдениям авторов METR, на протяжении последних шести лет временной горизонт удваивался каждые 7 месяцев. За последнее время эта динамика даже ускорилась, поэтому давайте считать, что удвоение временного горизонта будет происходить каждые полгода. Исходя из верности этого эмпирического наблюдения и ежегодного релиза очередной версии GPT, будущий рост временного горизонта при 80% надежности может выглядеть следующим образом:

| Год | Модель | Временной горизонт |

| 2026 | GPT-6 | 50 м |

| 2027 | GPT-7 | 3 ч 20 м |

| 2028 | GPT-8 | 13 ч 20 м |

| 2029 | GPT-9 | 53 ч 20 м (5-дневная рабочая неделя) |

| 2030 | GPT-10 | 213 ч 20 м (21-дневный рабочий месяц) |

Теоретически AGI (ИИ уровня хорошего специалиста в своей области) будет иметь неограниченный временной горизонт почти со 100% надежностью. Но если считать неким подобием AGI систему, которая способна заменить месячный труд человека хотя бы с 80% надежностью, то исходя из этой динамики AGI появится к 2030 году — срок, разделяемый многими экспертами. Но при этом, как отмечают наши коллеги с ресурса LessWrong, METR заточен на хорошо формализуемые задачи, связанные с программированием, а временной горизонт рассчитывается для новичков, а не опытных сотрудников. И как мы уже говорили, едва ли можно считать приемлемым 80% уровень надежности. Но главной проблемой остается неприемлемо высокий (40% у gpt-5-thinking) уровень галлюцинаций — без решения этой проблемы все эти оценки сроков появления AGI носят довольно умозрительный характер.

Менее заметным событием стал июльский релиз Grok 4. Он обучался на 200 тыс ГПУ и, по словам Илона Маска, в академических задачах превосходит людей со степенью PhD. В опубликованном на сайте Humanity’s Last Exam чарте Grok 4 и GPT-5 находятся примерно на одном уровне:

- без использования Python и Интернета — по 25%

- с использованием Python и Интернета — 44% и 42%.

А в одном из самых трудных для ИИ (и при этом легких для человека) бенчмарке ARC-AGI-2 модель Grok 4 заметно превосходит GPT-5 — 16% vs 10%. В предыдущей версии бенчмарка, ARC-AGI, результаты обеих моделей примерно на одном уровне, 67% и 66%, как и в бенчмарке SimpleBench (60% и 57%). В IQ-тесте средний результат Grok 4, по сравнению с GPT-5 Pro, выглядит скромнее — 110 vs 123. Впрочем, пиковое значение у обеих моделей — 130. Для сравнения, у человека в среднем — 100. Это очередная иллюстрация того насколько далеки все эти тесты и бенчмарки от полноценной оценки интеллектуальных качеств испытуемого.

В отличие от Grok 3, в Grok 4 инструменты были заложены в обучение — что значительно улучшило результат при использовании этих инструментов в процессе обработки пользовательских запросов. В числе таких инструментов — используемые непосредственно в Tesla и SpaceX метод конечных элементов (численный метод решения дифференциальных уравнений с частными производными, а также интегральных уравнений, возникающих при решении задач прикладной физики) и вычислительная гидродинамика. Интеграция с этими инструментами для обработки пользовательских запросов состоится позднее в этом году. В конечном итоге это позволит Grok взаимодействовать с реальным миром через роботов.

Кроме того, в Grok 4 значительно улучшен голосовой интерфейс — по возможностям он напоминает прошлогодний GPT-4o — говорит шепотом, поёт и т.д. Слабое место Grok 4 — работа с изображениями и видео (понимание и генерация). Grok 4 построен на 6-м поколении фундаментальной модели xAI, но уже в 7-м поколении эта проблема будет исправлена. В следующем или даже в этом году Grok 4 будет способен генерировать визуальные объекты для программируемых игр. В 2026 Илон Маск ожидает полноценный кинофильм, сгенерированный Grok 4.

Уже в этом месяце стартует обучение Grok 5, и Илон Маск заявил, ни много ни мало, что у этой модели есть шанс стать настоящим AGI. В ближайшие два года, то есть к середине 2027 года, глава xAI ожидает, что ИИ будет делать научные открытия. Последнее, кстати, отчасти уже происходит — согласно одному сотруднику OpenAI, GPT-5 смог улучшить решение открытой математической проблемы.

Если отбросить в сторону эмоции по поводу чрезмерного оптимизма Илона Маска (xAI) и Сэма Олтмена (OpenAI), а также несбывшегося прогноза Дарио Амодея (Anthropic), что к октябрю ИИ будет писать 90% программного кода, то ни о каком замедлении прогресса не может быть и речи. ИИ все еще очень далек от того, чтобы полностью заменить человека хотя бы в некоторых специальностях. Но с каждым новым релизом агентских функций и обновлением моделей возможности ИИ неуклонно растут. Из забавной игрушки всего несколько лет назад, большие языковые модели превратились в серьезный инструмент решения сложных интеллектуальных задач. В частности, с релизом GPT-5 окончательно устарел бенчмарк AIME — модель достигла в нем 100%. А ведь еще год назад, до появления reasoning, лучшая на то время модель, GPT-4o, набирала всего 13%. Как это часто бывает, разочарование возникает из-за завышенных ожиданий от динамики прогресса и постепенности наблюдаемых улучшений. Но если бы сегодняшним скептикам пару лет назад, еще до появления reasoning, дали программировать или решать математическое задачи при помощи GPT-5, то они бы наверняка испытали потрясение.

Что касается робототехники, то одним из самых впечатляющих достижений за последние месяцы стал HITTER (HumanoId Table TEnnis Robot) — созданный в Калифорнийском университете (Беркли) человекоподобный робот, умеющий играть в настольный теннис в полностью автономном режиме.

Роботы умели играть в настольный теннис и раньше, но на моей памяти это первый случай, когда в теннис играет человекоподобный робот, который в процесс игры перемещается на ногах. И хотя наша повседневная физическая реальность гораздо сложнее подобных игр, развитие подобных навыков безусловно способствует появлению в будущем роботов, способных выполнять работу по дому.

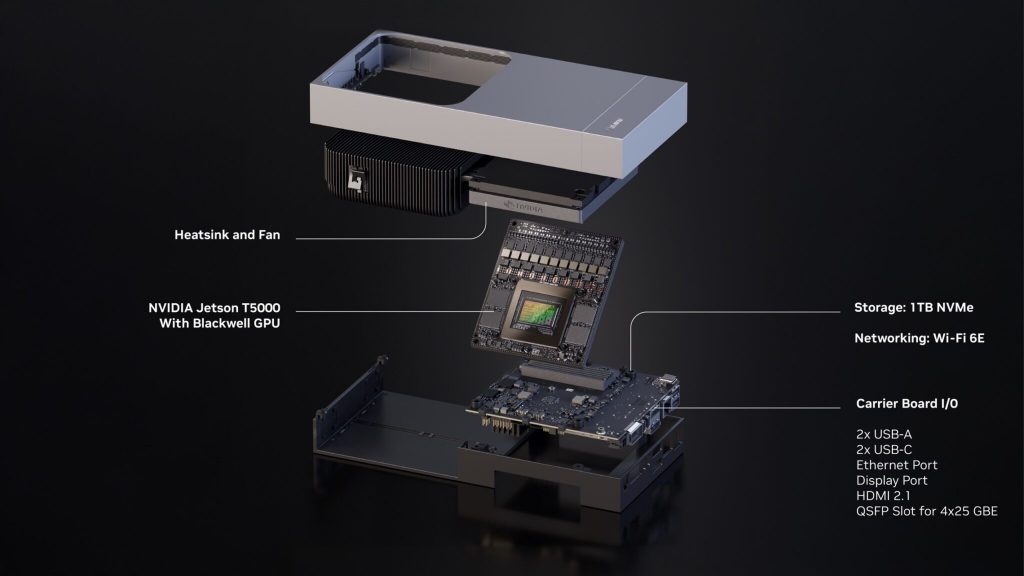

Автономная обработка огромных объемов информации, в режиме реального времени поступающей с камер и различных сенсоров, требует большой вычислительной производительности в сочетании с умеренным энергопотреблением. Одним из решением этой проблемы является Jetson Thor — вычислительная платформа от Nvidia на базе модуля Jetson T5000 (в бюджетной версии — Jetson T4000). Его производительность — 2 петафлопса (с точностью FP4 на разреженных матрицах), объем оперативной памяти LPDDR5X — 128 Гб (273 Гб/с), энергопотребление — от 40 до 130 Вт. Оптовая (от 1 тыс шт) цена модуля Jetson T5000 — $3 тыс. Столько же стоил представленный в начале года миникомпьютер Project DIGITS, на котором можно запускать модели с 200 млрд параметров, причем его производительность вдвое меньше (как у Jetson Thor на базе Jetson T4000) — 1 петафлопс (FP4).