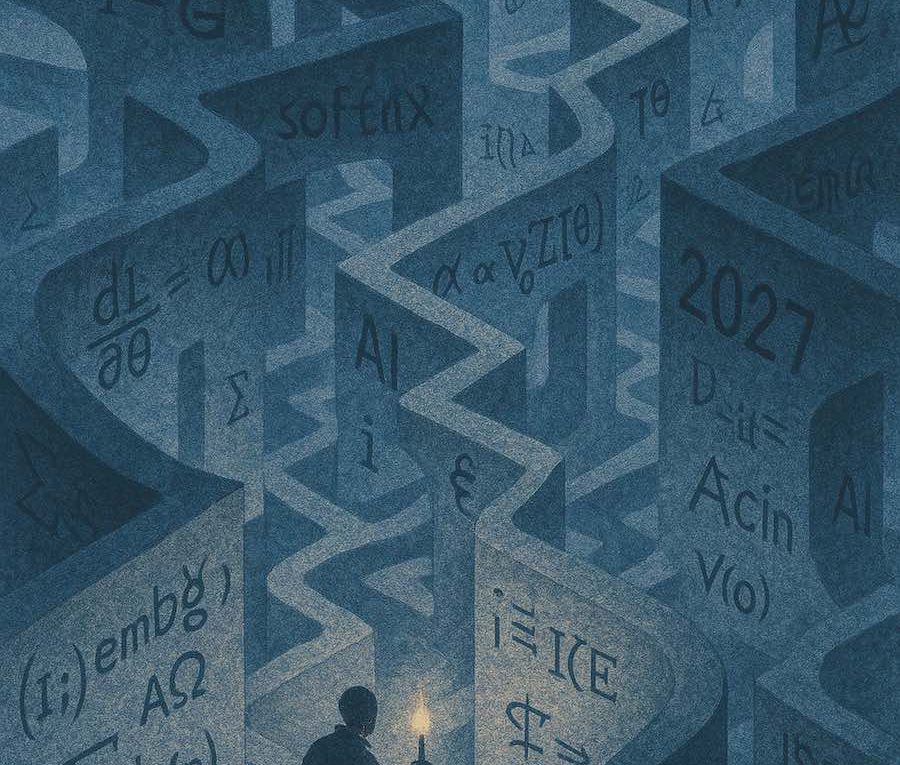

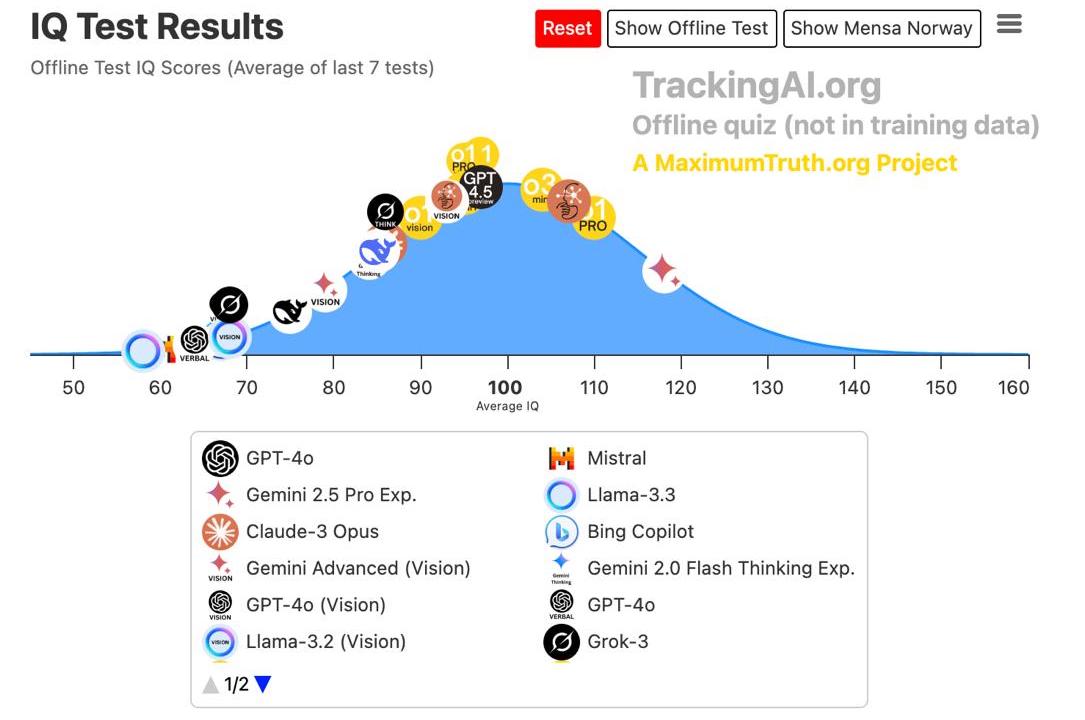

Аргументы в пользу появления AGI к 2030 году; три причины, по которым это может произойти через десятки лет; и свежее эссе Сэма Олтмена о мягкой сингулярности

Предлагаем вашему вниманию переводы двух статей, опубликованных на ресурсе 80,000 Hours, который «проводит исследования и оказывает поддержку, помогая талантливым людям

Читать далее