Scientific American: Ведущие мировые математики ошеломлены тем, насколько ИИ хорош в математике

Предлагаем вашему вниманию перевод статьи, опубликованной 6 июня научно-популярным изданием Scientific American.

В один из выходных в середине мая состоялся тайный математический конклав. Тридцать самых известных математиков мира съехались в Беркли, штат Калифорния, некоторые прибыли даже из Великобритании. Члены группы сошлись в поединке с «рассуждающим» чат-ботом, которому было поручено решать задачи, разработанные ими для проверки его математических способностей. После двух дней бомбардировки бота вопросами профессорского уровня исследователи с удивлением обнаружили, что он способен решать некоторые из самых сложных в мире решаемых задач. «У меня есть коллеги, которые буквально говорили, что эти модели приближаются к математическому гению», — говорит Кен Оно, математик из Виргинского университета, а также один из руководителей и судей на этой встрече.

Чат-бот, о котором идет речь, работает на базе o4-mini, так называемой большой языковой модели (LLM), способной к рассуждениям. Он был обучен компанией OpenAI для выполнения чрезвычайно сложных умозаключений. Аналогичная разработка Google, Gemini 2.5 Flash, обладает схожими возможностями. Как и LLM, лежавшие в основе ранних версий ChatGPT, o4-mini учится предсказывать следующее слово в последовательности. Однако, по сравнению с этими ранними LLM, o4-mini и его аналоги — это более легкие и гибкие модели, которые обучаются на специализированных наборах данных с более сильным подкреплением со стороны человека. Такой подход позволяет создать чат-бота, способного гораздо глубже вникать в сложные математические проблемы, чем традиционные LLM.

Для отслеживания прогресса o4-mini компания OpenAI ранее поручила некоммерческой организации Epoch AI, занимающейся бенчмаркингом LLM, разработать 300 математических вопросов, решения которых еще не были опубликованы. Даже традиционные LLM могут правильно отвечать на многие сложные математические вопросы. Однако, когда Epoch AI задала эти вопросы нескольким таким моделям, и эти вопросы отличались от тех, на которых они обучались, самые успешные из них смогли решить менее 2%, что показало отсутствие у этих LLM способности к рассуждению. Но o4-mini оказался совсем другим.

В сентябре 2024 года Epoch AI наняла Эллиота Глейзера, недавно получившего докторскую степень по математике, для участия в новом совместном проекте по бенчмаркингу под названием FrontierMath. В рамках проекта были собраны новые вопросы различных уровней сложности, причем первые три уровня охватывали задачи университетского, аспирантского и исследовательского уровней. К апрелю 2025 года Глейзер обнаружил, что o4-mini может решить около 20% вопросов. Затем он перешел к четвертому уровню: набору вопросов, которые были бы сложны даже для академического математика. Лишь небольшая группа людей в мире способна разработать такие вопросы, не говоря уже о том, чтобы на них ответить. Участвовавшие математики должны были подписать соглашение о неразглашении, требующее от них общаться исключительно через мессенджер Signal. Другие формы контактов, такие как традиционная электронная почта, потенциально могли быть просканированы LLM и непреднамеренно использованы для её обучения, что привело бы к загрязнению набора данных.

За каждую задачу, которую o4-mini не мог решить, математик, ее придумавший, получал вознаграждение в размере 7500 долларов. Группа медленно, но верно продвигалась в поиске вопросов. Но Глейзер хотел ускорить процесс, поэтому Epoch AI организовала очную встречу в субботу, 17 мая, и в воскресенье, 18 мая. Там участники должны были окончательно подготовить последнюю партию сложных вопросов. 30 участников были разделены на группы по шесть человек. В течение двух дней ученые соревновались между собой, пытаясь придумать задачи, которые они могли бы решить, но которые поставили бы в тупик рассуждающего ИИ-бота.

К концу вечера в субботу Оно был раздосадован ботом, чьи неожиданные математические способности мешали прогрессу группы. «Я придумал проблему, которую эксперты в моей области признали бы открытым вопросом в теории чисел — хорошая задача уровня аспирантуры», — говорит он. Он попросил o4-mini решить эту задачу. В течение следующих 10 минут Оно в ошеломленном молчании наблюдал, как бот в реальном времени разворачивал решение, демонстрируя по ходу свой процесс рассуждений. Первые две минуты бот потратил на поиск и освоение соответствующей литературы в данной области. Затем он написал на экране, что для начала хочет попробовать решить более простую, «игрушечную» версию задачи, чтобы поучиться. Через несколько минут он написал, что наконец готов решить более сложную проблему. Пять минут спустя o4-mini представил правильное, но дерзкое решение. «Он начинал вести себя очень нахально», — говорит Оно, который также является независимым математическим консультантом для Epoch AI. «И в конце он говорит: «Цитирование не требуется, потому что загадочное число было вычислено мной!“»

Потерпев поражение, рано утром в воскресенье Оно зашел в Signal и предупредил остальных участников. «Я не был готов иметь дело с подобной LLM», — говорит он. «Я никогда раньше не видел такого рода рассуждений у моделей. Именно так действует ученый. Это пугает».

Хотя группе в конечном итоге удалось найти 10 вопросов, которые поставили бота в тупик, исследователи были поражены тем, как далеко продвинулся ИИ за один год. Оно сравнил работу с ним с работой с «сильным соавтором». Ян-Хуэй Хэ, математик из Лондонского института математических наук и один из пионеров использования ИИ в математике, говорит: «Это то, что делал бы очень, очень хороший аспирант — на самом деле, даже больше».

Бот также был намного быстрее профессионального математика, затрачивая считанные минуты на то, на что у такого специалиста-человека ушли бы недели или месяцы.

Хотя поединок с o4-mini был захватывающим, его прогресс также вызывал тревогу. Оно и Хэ выражают обеспокоенность тем, что результатам o4-mini могут слишком доверять. «Существует доказательство по индукции, доказательство от противного, а также доказательство запугиванием», — говорит Хэ. «Если вы говорите что-то с достаточной уверенностью, люди просто пугаются. Я думаю, o4-mini овладел доказательством запугиванием; он говорит все с такой уверенностью».

К концу встречи группа начала размышлять о том, каким может быть будущее для математиков. Обсуждения перешли к неизбежному «пятому уровню» — вопросам, которые не могут решить даже лучшие математики. Если ИИ достигнет этого уровня, роль математиков претерпит резкие изменения. Например, математики могут перейти к простой постановке вопросов и взаимодействию с рассуждающими ботами, чтобы помочь им открывать новые математические истины, во многом подобно тому, как профессор работает с аспирантами. В связи с этим Оно предсказывает, что развитие креативности в высшем образовании станет ключом к сохранению математики для будущих поколений.

«Я говорил своим коллегам, что было бы серьезной ошибкой утверждать, что универсальный искусственный интеллект никогда не появится, [что] это всего лишь компьютер», — говорит Оно. «Я не хочу нагнетать истерию, но в некотором смысле эти большие языковые модели уже превосходят большинство наших лучших аспирантов в мире».

Статью прокомментировал один из участников этого «тайного математического конклава»:

Только что увидел новостной репортаж о симпозиуме FrontierMath (организованном @epochai). Хотя ИИ развивается невероятными темпами, я думаю, некоторые части репортажа были несколько преувеличены и требуют уточнений. (Мнения мои личные).

Около месяца назад я принял участие в симпозиуме FrontierMath вместе с 30 другими математиками. Наша задача — создавать математические задачи, на решение которых у человека-математика ушла бы примерно неделя, и с которыми модели ИИ испытывали бы трудности. Однако было одно особое ограничение: каждая задача должна была иметь численный ответ, хотя высшая математика обычно сосредоточена на рассуждениях и доказательствах, а не на чистых вычислениях.

Я был в группе по геометрии и топологии, и мы стремились создавать задачи, требующие геометрической интуиции и понимания ключевых теорем. Изначально мы считали, что современные модели ИИ слабы в продвинутой геометрии и топологии — поэтому мы разработали несколько задач уровня PhD, требующих концептуальной глубины.

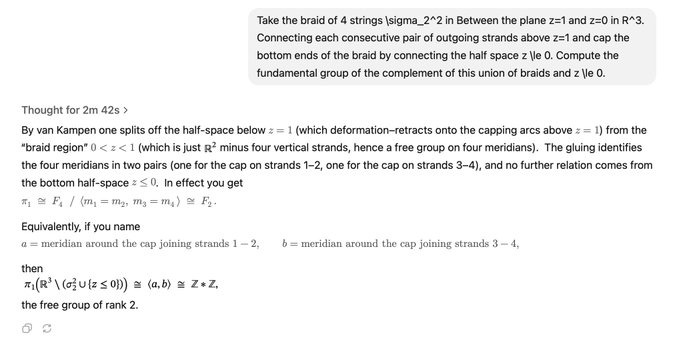

К нашему удивлению, o4-mini-high от @OpenAI (лучшая математическая модель, которую я тестировал до сих пор) смогла решить большинство из них. Хотя рассуждения иногда были неверными, ей все же удавалось прийти к правильным численным ответам. Я прикрепил один пример ниже.

Другие математики обнаружили и другие интересные факты — даже для задач, связанных с результатами недавних исследований, ИИ был на удивление эффективен в поиске, ссылках и применении этих результатов.

Итак, я скорректировал свою стратегию.

Я взял математическую статью, извлек из нее несколько промежуточных теорем и создал задачу, которая требовала синтеза этих результатов в вычислительный метод. Как и ожидалось, ИИ столкнулся с трудностями — он не смог связать промежуточные шаги или эффективно выстроить логическую цепочку.

Мои выводы из этого двухдневного опыта:

За последние два года ИИ значительно усовершенствовался. Но текущие LLM все еще сильно зависят от сопоставления с образцом (pattern matching) с ограниченной способностью к глубоким рассуждениям. Они пока не способны генерировать новые математические результаты, но они превосходно справляются со сбором релевантной литературы и составлением первоначальных набросков решений. Человеческий контроль остается необходимым — особенно для проверки и синтеза.

Мой прогноз: В ближайшие 1–2 года мы увидим, как ИИ будет помогать математикам в открытии новых теорий и решении открытых проблем (как недавно сделал @terrence_tao с @DeepMind). Вскоре после этого ИИ начнет сотрудничать — и в конечном итоге работать независимо — чтобы раздвигать границы математики и, как следствие, всех других научных областей.

P.S. Было забавно (и немного сюрреалистично), когда меня назвали одним из «тридцати самых известных математиков мира» — хотя в действительности многие более умные и талантливые математики не смогли приехать.