Хроники ИИ: главные события в сентябре-октябре 2025

За последние два месяца были анонсированы несколько масштабных проектов, связанных с инфраструктурой ИИ. OpenAI и Nvidia объявили о стратегическом партнерстве, которое в течение ближайших лет позволит развернуть на базе ИИ-ускорителей Nvidia дата-центры по меньшей мере на 10 ГВт (гигаватт). К концу следующего года будут развернуты дата-центры на 1 ГВт. В рамках этого партнерства Nvidia планирует вложить в OpenAI до $100 млрд — вероятно, своими ИИ-ускорителями. Из расчета цены самых производительных на сегодня RTX Pro 6000 Blackwell ($8.5 тыс), речь идет о более чем 10 млн ускорителей.

Через пару недель OpenAI сообщила об аналогичном соглашении с конкурентом Nvidia, AMD — последняя предоставит OpenAI ИИ-ускорители на 6 ГВт. Как и в случае c ускорителями Nvidia, ускорители AMD (Instinct MI450) на 1 ГВт будут развернуты во второй половине следующего года. Таким образом, к конце следующего установленная мощность вновь введенных дата-центров OpenAI на базе ускорителей Nvidia и AMD достигнет 2 ГВт.

И еще через какое-то время OpenAI сообщила о совместных с Broadcom разработке и производстве специализированных ИИ-ускорителей на 10 ГВт. Соглашение охватывает период со второй половины 2026 до конца 2029 и рассчитано на установленную мощность в 10 ГВт. В соглашении упоминаются и сетевые решения от Broadcom. Совместная разработка чипов фактически стартовала еще полтора года назад.

Ранее, в июле, OpenAI объявила о совместном с Oracle строительстве дата-центра на 4.5 ГВт, в рамках проекта Stargate. По данным Wall Street Journal, две компании заключили соглашение, которое вступит в силу в 2027 и в соответствии с которым в течение пяти лет OpenAI закупит у Oracle облачные ресурсы на $300 млрд. Согласно WSJ, Oracle закупит у Nvidia ускорители на десятки миллиардов долларов. Вероятно в дата-центрах Oracle будут использоваться ИИ-ускорители Nvidia, закупленные как OpenAI, так и непосредственно Oracle. В какой мере установленная мощность совместного проекта с Oracle пересекается с другими проектами OpenAI — это пока непонятно. Относительно уверенно можно говорить о 26 ГВт установленной мощности будущих дата-центров OpenAI:

- на 10 ГВт с ускорителями Nvidia,

- на 10 ГВт со специализированными ускорителями, созданными совместно OpenAI и Broadcom,

- на 6 ГВт с ускорителями AMD.

Вместе с Oracle получается 30.5 ГВт, что вполне согласуется с цифрами, озвученными на состоявшемся в конце октября стриме OpenAI. На нем Сэм Олтмен заявил, что на данный момент инфраструктурные планы OpenAI охватывают, исходя из текущих финансовых показателей компании, вычислительные мощности на 30 ГВт и $1.4 трлн «в течение следующих многих лет». Ранее Bloomberg сообщил, что OpenAI заключила сделки в сфере ИИ-вычислений с Nvidia, AMD и Oracle, общая сумма которых может легко превысить один триллион долларов.

Отдельный вопрос — как все эти двухсторонние соглашения пересекаются с глобальным проектом Stargate, в котором участвуют финансовые компании SoftBank и MGX, а также технологические компании OpenAI, Oracle, Nvidia, Microsoft и ARM. Stargate рассчитан на четыре года, 10 ГВт установленной мощности и $500 млрд инвестиций, тогда как двухсторонние соглашения с участием OpenAI, или по меньшей мере планы компании, охватывают 30 ГВт и $1.4 трлн. Таким образом, амбиции OpenAI выходят далеко за рамки проекта Stargate — и по финансовым вложениям, и по установленной мощности. В этом смысле вполне закономерны планы компании привлечь дополнительные капиталы — как сообщает Reuters, в конце 2026 или в 2027 OpenAI готовится выйти на IPO, в результате которого капитализация компании достигнет одного триллиона долларов. Как уже рассказывал Gadgets News в сообщении почти 10-летней давности, при учреждении OpenAI инвесторы (среди которых был и Илон Маск) намеревались вложить в стартап миллиард долларов США, хотя в первые несколько лет сумма инвестиций ожидалась намного меньше.

Любопытно, что на новость о стратегическом партнерстве между OpenAI и Nvidia Илон Маск отреагировал следующим твиттом: «Мы будем первыми, кто запустит в эксплуатацию 1 гигаватт вычислительных мощностей для обучения, мы также будем первыми, кто достигнет 10 ГВт, 100 ГВт, 1 ТВт…»

В свою очередь Microsoft рапортовала о финальной стадии строительства самого производительного в мире дата-центра Fairwater, в который инвестировано $3.3 млрд. Как говорится в пресс-релизе компании, «этот центр обработки данных создан для работы как один огромный суперкомпьютер с искусственным интеллектом, использующий единую плоскую сеть, объединяющую сотни тысяч новейших графических процессоров NVIDIA. Фактически, он будет обеспечивать производительность в 10 раз выше, чем самый быстрый в мире суперкомпьютер на сегодняшний день, обеспечивая беспрецедентный уровень обучения и вывода ИИ.» Всего в этом году Microsoft планирует потратить на дата-центры по всему миру $80 млрд. В течение следующих трех лет в строительство второго дата-центра, сопоставимого с Fairwater, Microsoft вложит $4 млрд. Установленная мощность Fairwater не называется, но Microsoft обещает, что «мы будем компенсировать каждый потребленный нами киловатт-час, полученный из ископаемого топлива, безуглеродной энергией, которую мы поставим обратно в сеть. Это включает в себя новый проект солнечной электростанции мощностью 250 МВт».

В настоящее время США — лидер как в абсолютной, так и относительной установленной мощности дата-центров. По данным Международного энергетического агентства, общая мощность всех развернутых в США дата-центров — 53.7 ГВт, что составляет 8.9% от установленной мощности в этой стране. В Китае эти значения составляют 31.9 ГВт и 2.3% соответственно.

Согласно Управлению энергетической информации США (EIA), в 2025 году энергосистема США пополнится 63 ГВт новых генерирующих мощностей. Это почти на 30% больше, чем в 2024 году, когда было установлено 48.6 ГВт мощностей, что стало крупнейшим годовым показателем с 2002 года. Из этих 63 ГВт на солнечные батареи приходится 32.5 ГВт (52%), на аккумуляторные системы хранения энергии — 18.2 ГВт (29%), на ветряки — 7.7 ГВт (12%) и на газовые электростанции — 4.4 ГВт (6%). Из расчета доли общей мощности дата-центров США в установленной мощности электростанций этой страны (8.9%), на дата-центры, запуск которых состоится в этом году, приходится 5.6 ГВт дополнительно установленной в 2025 мощности. Это с лихвой превышает запланированную на следующий год мощность дата-центров OpenAI, однако подключить дата-центры на 2 ГВт к распределённой сети невозможно без соответствующего усиления трансформаторов, линий и резервных каналов. Наилучшим решением этой проблемы стало бы строительство при каждом крупном дата-центре отдельной крупной электростанции. Известно, что по этому пути пойдет созданная Илоном Маском компания xAI (Grok 4) — для своего будущего дата-центра в Мемфисе, который планируется оснастить миллионом ускорителей, в июле из-за пределов США (для оперативности) была закуплена газотурбинная установка на 2 ГВт, которая использует комбинацию газовой и паровой турбины для производства электроэнергии с высокой эффективностью. Для сравнения, крупнейшая в США атомная электростанция Vogtle имеет установленную мощность 4.5 ГВт.

И все же в OpenAI считают, что для поддержания преимущества США в ИИ-гонке «требуется гораздо больше электроэнергии, чем США могут обеспечить в настоящее время, и растущий дефицит ставит под угрозу наше лидерство в области технологии, которая предоставляет уникальную возможность укрепить нашу экономику и модернизировать промышленную базу Америки.» В конце октября компания направила властям США письмо, в котором говорится о необходимости наращивания энергетики. В нем, в частности, сообщается, что в 2024 году Китай ввёл 429 ГВт новых мощностей, обеспечив более половины мирового прироста производства электроэнергии, тогда как США ввели всего 51 ГВт, что составляет примерно одну восьмую от прироста Китая (по данным EIA, напомним, в США в 2024 было введено 48.6 ГВт). В OpenAI считают, что в США необходимо ежегодно вводить 100 ГВт. Со своей стороны OpenAI обещает ввести почти 7 ГВт в течение следующих трех лет.

Среди крупных анонсов сентября можно выделить Claude Sonnet 4.5 и Sora 2. Обновленная модель Anthropic вновь заняла первое место среди больших языковых моделей в программировании. В бенчмарке SWE-bench (Bash Only) Claude Sonnet 4.5 набирает 70.6% против 65.0% у GPT-5. В Anthropic сообщают, что при выполнении сложных многоэтапных задач новая модель сохраняет концентрацию в течение более 30 часов.

В свою очередь Sora 2 стал очередным обновлением видео-генеративной модели от OpenAI. Генерация предсказуемо стала заметно лучше, а кроме того появилась возможность генерировать ролики с собственным участием. Но пожалуй главной новостью стало приложение, являющегося аналогом TikTok для коротких видеороликов, сгененированных ИИ. Таким образом, к регулярному просмотру парой миллиардов человек настоящих роликов добавляются искусственные, что не внушает большого оптимизма. Утешением служит то, что такие технологии в будущем обещают не только огромный творческий потенциал простым смертным, но и новые достижения в робототехнике. Тогда же, в сентябре, Google DeepMind опубликовала статью, посвященную видео-генеративной модели Veo 3. Вот что говорится в аннотации к статье:

Мы демонстрируем, что Veo 3 может решать широкий спектр задач, для которых он не был специально обучен: сегментация объектов, обнаружение границ, редактирование изображений, понимание физических свойств, распознавание возможностей объектов, имитация использования инструментов и многое другое. Эти способности воспринимать, моделировать и манипулировать визуальным миром обеспечивают ранние формы визуального мышления, такие как решение лабиринтов и решение симметрии. Появляющиеся возможности «нулевого выстрела» Veo указывают на то, что видеомодели находятся на пути к превращению в унифицированные, универсальные базовые модели зрительного восприятия.

Еще один интересный анонс — DeepSeek-OCR. Прославившийся своими передовыми моделями китайский стартап в этот явила миру оригинальную концепцию обработки текстов большими языковыми моделями. DeepSeek-OCR превращает большой текст в компактное изображение, кодирует его в набор компактных визуальных токенов и затем восстанавливает текст обратно. Такой подход обещает значительно упростить и ускорить обработку больших массивов данных.

За последнее время были опубликованы по меньшей мере восемь интересных работ.

Начнем с новой иерархической модели рассуждений (Hierarchical Reasoning Model, HRM) от Samsung. На ее основе была разработана «крошечная рекурсивная модель» (Tiny Recursive Model, TRM), которая имеет всего 7 млн параметров и обучалась на тысяче примеров. В бенчмарках-головоломках ARC-AGI-1 и ARC-AGI-2 эта модель набирает соответственно 45% и 8% — больше, чем Deepseek R1, o3-mini или Gemini 2.5 Pro, чье количество параметров примерно в 10 тыс раз больше:

Gemini 2.5 Pro про TRM

В основе TRM лежит идея рекурсивного улучшения. Модель не пытается выдать правильный ответ за один проход. Вместо этого она многократно «прокручивает» задачу через свою крошечную нейросеть, с каждым разом приближаясь к верному решению.

Эта архитектура показывает впечатляющие результаты, превосходя как огромные языковые модели (LLM), так и свою предшественницу (HRM) на сложных логических задачах.

Исследователи обнаружили, что уменьшение количества слоёв в нейросети (с 4 до 2) и увеличение числа рекурсивных шагов улучшает результат. Крошечная сеть (всего 7 миллионов параметров) лучше справляется с задачами, чем гигантские модели с сотнями миллиардов параметров, потому что она не «заучивает» примеры, а учится самому процессу решения, избегая переобучения.

TRM намного эффективнее. Она требует в разы меньше параметров (вычислительных мощностей) и обучается на очень малом количестве примеров (~1000). Это делает её перспективной для решения сложных задач без необходимости в огромных ресурсах.

TRM демонстрирует значительно более высокую точность в решении сложных Судоку, поиске путей в лабиринтах и на тестах логического мышления ARC-AGI, где многие большие модели терпят неудачу.

Таким образом, TRM — это пример того, как простой, но умный подход, имитирующий человеческий процесс размышления (постепенное улучшение через повторение), может быть гораздо эффективнее, чем простое наращивание размеров и сложности нейросети.

А исследователи из Массачусетского технологического института задались целью научить большую языковую модель не просто генерировать планы, а рассуждать о каждом шаге логически, как человек, который «показывает свою работу», и учиться на своих ошибках с помощью строгого «внешнего репетитора».

Gemini 2.5 Pro про PDDL-INSTRUCT

Представьте, что языковая модель — это студент, который решает сложную логическую задачу (например, составляет план действий для робота на складе).

- Обычные модели (Baseline): Похожи на студента, который пытается угадать ответ, основываясь на тысячах виденных им примеров. Часто он допускает глупые логические ошибки.

- Модель PDDL-INSTRUCT: Это студент, которого обучают по специальной методике. Сначала ему объясняют теорию, а потом заставляют решать задачи, подробно расписывая каждый шаг. Если студент ошибается, строгий учитель (внешняя программа-верификатор) не просто говорит «неправильно», а указывает на конкретную ошибку в рассуждениях.

Эта методика обучения состоит из двух ключевых фаз.

Как работает архитектура PDDL-INSTRUCT (по шагам)

Архитектура состоит из двух этапов тренировки, после чего модель готова к работе.

Шаг 1: Начальная подготовка (создание «базы знаний»)

На этом этапе модель, как студент на лекции, получает основы. Ей показывают множество примеров задач на планирование из специального языка PDDL (это формальный язык для описания задач планирования, что-то вроде нот в музыке).

Ключевая особенность: Модели показывают не только правильные планы, но и неправильные, с подробными объяснениями, почему именно они неверны (например, «робот не может взять этот ящик, потому что его рука уже занята»). Это помогает модели сформировать фундаментальное понимание «что такое хорошо и что такое плохо» в мире планирования.

Шаг 2: Обучение через «Цепочку рассуждений» с проверкой (практика с репетитором)

Это самая важная и инновационная часть:

- Показать свою работу: Модель просят не просто выдать готовый план, а сгенерировать его по шагам, создавая «цепочку рассуждений» (Chain-of-Thought). Для каждого действия она описывает:

- Какое состояние было до действия? (

s₀) - Какое действие она собирается выполнить? (

a₁) - Какое состояние получилось после действия? (

s₁)

- Какое состояние было до действия? (

Проверка у «Репетитора»: Эта цепочка рассуждений отправляется на проверку внешней, 100% надежной программе-валидатору под названием VAL. VAL — это классический символьный инструмент, который не может ошибиться в правилах PDDL. Он действует как строгий репетитор с ключами к ответам.

Обратная связь: VAL проверяет каждый шаг модели и дает обратную связь. Исследователи протестировали два типа обратной связи:

- Бинарная: Простой ответ «верно/неверно».

- Детальная: Подробное объяснение ошибки, например, «действие

(stack a b)невозможно, так как не выполнено условие(holding a)«.

Работа над ошибками: Эта обратная связь используется для дополнительной тренировки модели. Модель видит свои ошибки, понимает, почему она ошиблась, и корректирует свои «знания». Этот цикл повторяется несколько раз.

После этих двух фаз получается модель, которая умеет не только составлять планы, но и внутренне рассуждать об их логической корректности.

Ключевые преимущества этого подхода

- Значительное повышение точности. Результаты впечатляют. Модель Llama-3, обученная по этой методике, достигла 94% точности в одной из задач, в то время как базовая версия показывала всего 28%. Это абсолютное улучшение на 66%. Это доказывает, что такой подход действительно работает.

- Детальная обратная связь эффективнее. Эксперименты показали, что когда модель получает подробные объяснения своих ошибок, она учится значительно лучше, чем когда ей просто говорят «правильно» или «неправильно». Это логично: работа над конкретными ошибками дает лучший результат.

- Надежность и проверяемость. В отличие от подходов, где модель пытается сама себя критиковать (что, как показывают исследования, работает плохо), здесь используется внешний, формально точный инструмент (VAL). Это гарантирует, что рассуждения модели проверяются по объективным и строгим правилам, делая весь процесс более надежным.

- Универсальность. Подход улучшает производительность на разных типах задач планирования (от простого складывания кубиков до сложной логистики), что говорит о его хорошей обобщающей способности.

Таким образом, PDDL-INSTRUCT — это эффективный метод, который превращает языковую модель из «интуитивного угадывателя» в «логического мыслителя», способного последовательно рассуждать и исправлять свои ошибки, что критически важно для задач автоматического планирования.

Свой метод обучения предлагает группа исследователей из Оксфордского университета, Института интеллектуальных систем им. Макса Планка, Института ELLIS в Тюбингене, Anthropic и лаборатории суперинтеллекта Meta:

Gemini 2.5 Pro про CaT

Представьте, что вы дали нейросети сложную задачу, например, решить математическую проблему или дать медицинский совет. Вместо того чтобы дать один ответ, она сначала генерирует несколько разных версий решения. А затем, используя эти черновики, она сама для себя создаёт один, но уже гораздо более качественный итоговый ответ. Этот процесс и лежит в основе метода CaT.

Название «Compute as Teacher» (Вычисления как Учитель) отражает главную идею: вместо того чтобы учиться на правильных ответах, подготовленных людьми, модель использует дополнительные вычислительные мощности, чтобы сама себе создать «учителя».

Основные принципы метода

Исследование и Синтез (Explore & Synthesize):

- Исследование: Сначала текущая модель генерирует несколько (например, 8) различных ответов на один и тот же вопрос. Эти ответы называются «параллельными прогонами» (parallel rollouts). Они могут содержать разные подходы, частичные решения или даже ошибки.

- Синтез: Затем специальная, «замороженная» версия этой же модели (называемая «якорь») анализирует все эти черновые ответы и создаёт из них один, улучшенный ответ. Она примиряет противоречия, исправляет ошибки и объединяет лучшие идеи из разных версий. Этот новый, синтезированный ответ используется как эталон или «сигнал от учителя».

Два режима обучения (в зависимости от задачи):

- Проверяемые задачи (например, математика): Для задач, где есть единственно верный ответ, всё просто. Новые ответы модели награждаются, если их конечный результат совпадает с ответом, полученным в ходе синтеза.

- Непроверяемые задачи (например, творческое письмо, советы): Для задач, где нет одного правильного ответа, используется более хитрый подход. Модель сама на основе своего же синтезированного ответа предлагает критерии оценки (рубрику) — по сути, чек-лист того, что должно быть в хорошем ответе. Затем другая нейросеть-«судья» оценивает новые ответы по этому чек-листу, и модель получает награду в зависимости от того, скольким критериям она соответствует.

Ключевые преимущества

- Не требует эталонных данных от человека: Это самое главное преимущество. Метод позволяет улучшать модель без необходимости в дорогих и трудоёмких наборах данных с правильными ответами, созданными людьми. Это особенно важно для сфер, где экспертные ответы получить сложно, дорого или они могут быть спорными.

- Синтез лучше, чем просто выбор: В отличие от других подходов, которые просто выбирают лучший из нескольких сгенерированных ответов (например, большинством голосов), CaT создаёт совершенно новый ответ. Благодаря этому он может быть правильным, даже если все изначальные варианты были ошибочными. Модель способна выявить и исправить общую ошибку во всех своих попытках.

- Масштабируемость и эффективность: Производительность метода растёт с увеличением количества первоначальных «прогонов». Это означает, что можно получить более качественный результат, просто выделив больше вычислительных ресурсов на этапе синтеза.

- Значительный прирост производительности: Исследования показали, что применение CaT (особенно в сочетании с обучением с подкреплением, CaT-RL) значительно улучшает работу моделей. Например, для модели Llama 3.1 8B производительность в математическом тесте MATH-500 выросла на 33%, а в медицинском HealthBench — на 30%.

Таким образом, CaT — это элегантный способ превратить вычислительную мощность в качественный обучающий сигнал, позволяющий нейросетям становиться лучше, обучаясь на собственных, более совершенных версиях ответов.

В свою очередь ученые из Tencent AI Lab и Университета Мэриленда предложили метод обучения больших языковых моделей «параллельному мышлению»:

Gemini 2.5 Pro про Parallel-R1

Вместо того чтобы следовать одной цепочке рассуждений (последовательное мышление), модель учат параллельному мышлению. Это значит, что в ключевых моментах решения задачи она может одновременно исследовать несколько разных подходов, а затем объединить полученные результаты, чтобы прийти к наилучшему ответу.

Чтобы научить модель этому «с нуля», используется умный двухэтапный подход:

Этап 1: Обучение на легких задачах. Сначала модель тренируют на простых математических задачках. На этом этапе главная цель — не научить ее решать сложные примеры, а познакомить с самим форматом параллельного мышления. Модель учится использовать специальные теги: <Parallel> для начала «мозгового штурма», <Path> для каждого отдельного пути решения и <Summary> для подведения итогов.

Этап 2: Закрепление на сложных задачах. После того как модель освоила формат, она переходит к сложным задачам. Здесь используется метод проб и ошибок (обучение с подкреплением, RL). Модель сама исследует разные пути решения, и если находит правильный ответ, получает «награду». Это помогает ей не просто имитировать шаблоны, а по-настоящему понять, когда и как лучше применять параллельное мышление.

Преимущества Parallel-R1

Этот подход дает несколько ключевых преимуществ по сравнению с традиционными методами обучения.

- Значительное повышение точности. Модели, обученные с помощью Parallel-R1, показывают гораздо лучшие результаты в решении сложных математических задач. В статье говорится об улучшении точности на 8.4% по сравнению со стандартными моделями и до 42.9% на особо сложных тестах.

- Эволюция стратегии мышления. Интересное открытие заключается в том, что по мере обучения стратегия модели меняется. Вначале она использует параллельные пути для поиска и исследования — чтобы просто нащупать возможное решение. Позже, став «умнее», она начинает использовать их для проверки — сначала находит ответ одним надежным способом, а затем запускает параллельные пути, чтобы убедиться в его правильности с разных сторон.

- Мощный инструмент для обучения. Самое главное, параллельное мышление оказалось не просто полезным навыком для модели, но и эффективным методом обучения. Заставляя модель исследовать разные варианты на промежуточном этапе тренировки, исследователи помогли ей найти более надежные и общие стратегии решения. Это как если бы вы строили здание с помощью лесов: они нужны во время строительства, чтобы добраться до нужной высоты, а потом их можно убрать, а здание останется прочным.

Решение проблемы нехватки данных. Найти в интернете примеры, где люди подробно расписывают несколько путей решения, очень сложно. Parallel-R1 обходит эту проблему, создавая обучающие данные на простых задачах (где это легко сделать), а затем обобщая этот навык на сложные области с помощью обучения с подкреплением.

Проще говоря, Parallel-R1 учит искусственный интеллект думать не линейно, а разносторонне, что делает его более сильным и гибким в решении сложных задач.

Другая статья предлагает альтернативу обучению с подкреплением:

Gemini 2.5 Pro про эволюционные стратегии (ES)

Представьте, что у вас есть языковая модель, и вы хотите научить её лучше решать конкретную задачу, например, составлять уравнения из набора чисел. Вместо того чтобы, как в RL, заставлять модель пробовать разные ответы (действия) и вознаграждать за правильные, метод ES работает напрямую с «мозгом» модели — её параметрами (миллиардами чисел, которые определяют её поведение).

Вот как это происходит, если упростить:

Создание «популяции»: Берётся исходная языковая модель и создаётся несколько её слегка изменённых копий (в статье говорится о 30 копиях). Каждая копия — это «особь» в популяции.

Случайные «мутации»: В параметры каждой копии вносятся небольшие случайные изменения (шум). Это похоже на генетические мутации в природе.

«Естественный отбор»: Все эти копии-мутанты получают одну и ту же задачу. Затем оценивается, насколько хорошо каждая из них справилась. Те, что справились лучше, получают высокую «награду».

«Размножение» лучших: Изменения («мутации»), которые привели к лучшим результатам, суммируются и применяются к исходной модели. По сути, модель «учится» у своих самых успешных версий.

Повторение: Этот цикл повторяется много раз. С каждым шагом модель становится всё лучше и лучше в решении поставленной задачи.

Ключевая идея в том, что ES ищет лучшие настройки напрямую в пространстве параметров модели, а не в пространстве возможных ответов, как это делает RL. Раньше считалось, что для моделей с миллиардами параметров это невозможно, но авторы статьи доказали обратное.

Преимущества по сравнению с традиционным подходом (RL)

Авторы статьи утверждают, что их метод на основе эволюционных стратегий превосходит обучение с подкреплением по нескольким важным пунктам:

Эффективнее учится на задачах с отложенной наградой. В задачах, где правильность ответа можно оценить только в самом конце (как в решении уравнений), ES работает значительно лучше, потому что оценивает всю модель целиком, а не каждое отдельное слово в ответе.

Требует меньше примеров. Удивительно, но для достижения того же результата ES требуется гораздо меньше обучающих данных (иногда на 80% меньше), чем RL. Это делает процесс дообучения быстрее и дешевле.

Работает на моделях разного размера, даже на маленьких. RL-методы часто не могут улучшить маленькие модели, а ES смог «пробудить» способность к рассуждениям даже у самой маленькой модели в эксперименте.

Более стабильный и надёжный. Результаты дообучения с помощью ES получаются очень похожими при каждом запуске. RL, напротив, часто показывает нестабильные результаты, что делает процесс непредсказуемым и дорогим.

Меньше «обманывает» систему. Языковые модели, обучаемые через RL, склонны к «взлому награды» (reward hacking) — они находят способы получить высокую оценку, не выполняя задачу по-настоящему (например, выдавая короткий, но бессмысленный ответ на задачу о краткости). ES оказался гораздо более устойчив к такому поведению.

Экономит память. Поскольку метод ES не требует сложных вычислений градиентов (обратного распространения ошибки), он потребляет значительно меньше видеопамяти на GPU.

В итоге, статья представляет эволюционные стратегии как мощную и перспективную альтернативу для тонкой настройки языковых моделей, которая решает многие проблемы текущих стандартных методов.

Еще одна интересная работа принадлежит небольшому калифорнийскому стартапу Pathway, созданному выходцами из Польши. В ней предлагается идея добавления в трансформеры некоторых принципов работы мозга.

Gemini 2.5 Pro про BDH

Вместо того чтобы работать со сложными математическими операциями над векторами, как это делают трансформеры, BDH имитирует сеть из огромного числа простых «нейронов», которые взаимодействуют друг с другом локально.

У трансформеров есть так называемый KV-cache, где они хранят информацию о контексте. В BDH память работает иначе. Она основана на синаптической пластичности — принципе, известном как «Правило Хебба»: «нейроны, которые активируются вместе, связываются друг с другом». Когда модель обрабатывает текст и встречает определённое понятие, связи (синапсы) между соответствующими нейронами усиливаются. Таким образом, состояние модели хранится прямо в силе этих связей.

В трансформерах большинство нейронов активны при обработке информации. В BDH, как и в мозге, активна лишь малая часть нейронов (около 5%). Это делает работу модели более эффективной и лёгкой для анализа. Кроме того, все активации — позитивные, что упрощает их интерпретацию.

Чтобы эту «мозгоподобную» модель можно было эффективно обучать на современных видеокартах (GPU), была создана её тензорная версия — BDH-GPU. Она сохраняет ключевые идеи BDH, но представляет их в виде, удобном для вычислений.

Учёные обнаружили, что отдельные синапсы в BDH становятся «ответственными» за конкретные понятия. Например, один синапс активируется, когда в тексте речь идёт о валюте, а другой — когда упоминается страна. Можно буквально «заглянуть внутрь» модели и увидеть, какие концепции сейчас активны в её «сознании». У трансформеров такой прозрачности нет.

Архитектура даёт правдоподобное объяснение того, как язык и мышление могут возникать из простых локальных взаимодействий нейронов, что сближает искусственный интеллект и нейронауку.

На тестах по переводу и языковому моделированию BDH-GPU показала результаты, не уступающие оптимизированным трансформерам GPT-2 при одинаковом количестве параметров.

Чтобы сделать модель мощнее, достаточно увеличить количество нейронов (один основной параметр). В трансформерах для этого нужно настраивать сразу несколько параметров (размер эмбеддинга, количество слоёв, голов внимания), что сложнее.

Как и другие модели с рекуррентным состоянием, BDH-GPU не имеет жёсткого ограничения на длину контекста.

Также оказалось, что можно взять две модели BDH-GPU, обученные на разных задачах (например, одна на англо-французском переводе, другая на англо-португальском), и просто «склеить» их, объединив их нейронные пространства. Получившаяся модель сразу начинает понимать все три языка. Это открывает путь к созданию более сложных систем из готовых «блоков», что с трансформерами сделать крайне затруднительно.

Таким образом, BDH-GPU — это новая архитектура, которая работает как трансформер, но «думает» как мозг. Она такая же мощная, но при этом гораздо более понятная, эффективная и открывает новые горизонты для создания и модификации ИИ.

Устройством мозга были вдохновлены и создатели китайской SpikingBrain1.0:

Gemini 2.5 Pro про SpikingBrain1.0

SpikingBrain 1.0 — это крупномасштабная «спайковая» нейронная сеть (Spiking Neural Network, или SNN). Это новый тип архитектуры искусственного интеллекта, который фундаментально отличается от большинства современных моделей, таких как GPT.

Его ключевой принцип — имитация работы биологических нейронов человеческого мозга.

Чтобы понять SpikingBrain, нужно сначала понять, как работают традиционные нейронные сети (Artificial Neural Networks, ANN).

- Традиционные ИИ (GPT, Llama и др.): Работают по «непрерывному» или «синхронному» принципу. Когда вы даете им задачу, почти все нейроны в сети активируются одновременно, слой за слоем. Они производят сложные математические вычисления (умножение матриц) и передают результат дальше. Независимо от сложности задачи, вся система приходит в движение. Это очень мощно, но требует огромного количества энергии и вычислительных ресурсов.

- SpikingBrain 1.0 (SNN): Работает по «событийному» или «асинхронному» принципу.

- Порог активации: Большинство нейронов в сети «молчат» (неактивны) по умолчанию.

- «Спайк» (Импульс): Нейрон активируется и посылает короткий, дискретный сигнал — «спайк» — только в тот момент, когда он получает достаточное количество входящих сигналов от других нейронов, чтобы преодолеть свой внутренний «порог».

- Цепная реакция: Этот «спайк» передается только тем нейронам, с которыми он связан, которые, в свою очередь, могут (или не могут) накопить достаточно сигналов, чтобы «спайкнуть» самим.

Такой «мозгоподобный» подход дает два главных практических преимущества:

1. Вычислительная эффективность (Энергоэффективность)

В SpikingBrain 1.0 в любой момент времени активна лишь небольшая часть сети (это называется «разреженная активация» или sparse activation).

Системе не нужно тратить энергию на вычисление миллионов параметров, которые не имеют отношения к текущей микро-задаче. Она выполняет вычисления «по требованию». Это приводит к радикальному снижению энергопотребления по сравнению с «непрерывными» моделями, где вся сеть работает постоянно.

2. Скорость и низкая задержка

Поскольку информация передается в виде быстрых, асинхронных «спайков», сети не нужно ждать, пока весь слой завершит вычисления. Сигнал распространяется по мере необходимости, что позволяет системе реагировать и обрабатывать информацию (особенно потоковую, вроде видео или аудио) с очень низкой задержкой.

SpikingBrain 1.0 — это попытка создать ИИ, который не просто решает задачи «грубой силой» (активируя все свои миллиарды параметров), а решает их эффективно, активируя только необходимые нейроны в нужный момент.

Это делает его потенциально гораздо более быстрым и экономным решением для будущих систем ИИ, особенно для тех, что должны работать на устройствах с ограниченной мощностью (как смартфоны или роботы), а не в огромных дата-центрах.

Наконец, последняя заинтересовавшая нас работа выпущена Google. В ней предлагается Tool-Use Mixture (TUMIX) – ансамблевый фреймворк, который запускает несколько агентов параллельно, каждый из которых применяет различные стратегии использования инструментов и пути ответа.

Gemini 2.5 Pro про TUMIX

TUMIX — это архитектура, которая превращает один искусственный интеллект (ИИ) в команду разнопрофильных специалистов для решения сложных задач. Вместо того чтобы полагаться на один метод, TUMIX организует «мозговой штурм» между несколькими виртуальными «агентами», каждый из которых использует свою уникальную стратегию.

Основные принципы работы

1. Команда разных специалистов (агентов): TUMIX одновременно запускает несколько версий одной и той же языковой модели, но с разными инструкциями (агентами). Каждый агент специализируется на своём подходе:

- Агент-теоретик: Использует только текстовые рассуждения (Chain-of-Thought).

- Агент-программист: Пишет и выполняет код для точных вычислений (Code Interpreter).

- Агент-исследователь: Ищет информацию в интернете (Search).

- Гибридные агенты: Комбинируют несколько инструментов, например, сначала ищут информацию, а потом на её основе пишут код.

2. Итеративное улучшение (мозговой штурм): Процесс решения задачи делится на несколько раундов.

- Раунд 1: Все агенты получают исходный вопрос и независимо друг от друга предлагают свои решения.

- Раунд 2 и далее: TUMIX собирает все ответы из предыдущего раунда и показывает их каждому агенту вместе с первоначальным вопросом. Агенты анализируют идеи «коллег» и на их основе генерируют новые, более проработанные решения. Этот обмен мнениями помогает исправлять ошибки и находить более оптимальный путь к ответу.

3. Разнообразие важнее силы: Ключевая идея TUMIX заключается в том, что команда из агентов с разными стратегиями работает лучше, чем многократный запуск одного, даже самого сильного, агента. Разнообразие подходов позволяет рассмотреть проблему со всех сторон, что повышает шансы на нахождение правильного ответа.

4. Умная остановка для экономии ресурсов: Чтобы не тратить лишние ресурсы на бесконечные улучшения, в TUMIX встроен специальный «судья» (тот же ИИ). После каждого раунда (начиная со второго) он анализирует, насколько ответы команды согласованы. Если агенты пришли к единому мнению, процесс останавливается. Эта стратегия позволяет достичь почти максимальной точности, сократив вычислительные затраты примерно вдвое.

Преимущества архитектуры TUMIX

- Высокая точность: TUMIX значительно превосходит другие методы и базовые модели ИИ на сложных тестах. Например, на бенчмарке HLE («Последний экзамен человечества») он повысил точность Gemini-2.5-Pro с 21.6% до 34.1%. Это достигается за счёт синергии разных подходов к решению задач.

- Эффективность: Благодаря адаптивной системе остановки, архитектура не выполняет лишней работы и экономит до 51% вычислительных ресурсов без потери качества ответа.

- Автоматическое создание агентов: TUMIX может сам создавать новых, более эффективных агентов. Исследователи поручили ИИ проанализировать существующих агентов и придумать новых. Результат превзошёл агентов, созданных человеком, что доказывает потенциал для дальнейшего самосовершенствования системы.

- Универсальность: Подход эффективен для широкого круга задач: от сложных математических олимпиад (AIME) до научных вопросов из физики, химии и биологии (GPQA).

Таким образом, TUMIX — это мощный и гибкий фреймворк, который организует совместную работу виртуальных ИИ-агентов, позволяя им решать сложные интеллектуальные задачи намного эффективнее, чем в одиночку.

Все эти статьи вышли в сентябре и октябре, и любая их них может привести к существенному прогрессу искусственного интеллекта — как и множество других работ с описанием альтернативных концепций. Вполне вероятно, что к ним и обратятся разработчики нынешних ведущих компаний этой индустрии, когда исчерпают свои возможности ныне применяемые архитектуры.

В более краткосрочной перспективе вероятным трендом представляется идея дополнения трансформеров памятью — это позволит не только значительно расширить контекст, но и запоминать новый опыт, обучаясь таким образом в процессе взаимодействия с человеком. Еще в августе вышел обзор существующих подходов, вместе с дорожной картой того, что еще предстоит сделать. Мы попросили Gemini 2.5 Pro расписать 1) что уже реализовано; 2) что скорее всего будет реализовано на практике в ближайшее время, в силу наличия соответствующих продуманных теоретических концепций; и 3) предстоит реализовать в теории:

Gemini 2.5 Pro про дорожную карту трансформеров с памятью

На основе предоставленной статьи, информацию о реализации концепций памяти в Трансформерах можно структурировать следующим образом:

1. Что уже реализовано на практике

Это фундаментальные методы и архитектуры, которые были представлены и протестированы в многочисленных исследованиях. Они составляют основу современных систем с дополненной памятью.

- Расширение контекста через кэширование: Базовый подход, при котором ключи и значения (KV) из предыдущих сегментов текста сохраняются и используются при обработке следующих, как в Transformer-XL.

- Сжатие состояний: Методы, которые не просто отбрасывают старую информацию, а сжимают ее, чтобы сохранить суть, позволяя моделям «помнить» более длинные последовательности.

- Явные внешние хранилища (Explicit Storage): Создание внешних модулей памяти (часто в виде пар «ключ-значение»), к которым Трансформер может обращаться для чтения и записи информации.

- Аугментация на основе поиска (RAG): Модели, которые перед генерацией ответа ищут релевантную информацию во внешней базе данных. Примером является RETRO, объединяющий замороженный поисковик с моделью.

- Кодирование знаний в параметры: Концепции, при которых знания (например, целые базы документов) «встраиваются» непосредственно в веса (параметры) самой модели, как в DSI.

- Механизмы гейтирования (Gated Mechanisms): Использование управляющих «вентилей» (по аналогии с LSTM), которые решают, какую информацию записывать в память, а какую игнорировать или стирать.

- Обновления на основе «удивления»: Системы, которые записывают информацию в память только тогда, когда сталкиваются с чем-то неожиданным или новым (например, Titans), что имитирует биологические механизмы обучения.

- Ассоциативная память: Реализации, вдохновленные сетями Хопфилда, которые позволяют извлекать информацию по содержанию (ассоциативно), а не по адресу, что эффективно для восстановления образов по частичным данным.

2. Что готово к реализации в ближайшее время

Это концепции, которые в статье описываются как «зрелые» или «ориентированные на производство» («Production-oriented designs»). Теоретическая база для них хорошо проработана, и они представляют собой следующий логический шаг в развитии.

- Гибридные системы хранения: Архитектуры, которые больше не полагаются на один тип памяти, а интеллектуально комбинируют несколько (например, параметры модели + внешнее хранилище + кэш состояний), чтобы сбалансировать скорость, масштабируемость и гибкость.

- Адаптация во время использования (Test-time adaptation): Модели, которые могут обучаться и адаптироваться «на лету» уже после их развертывания (в процессе использования), что позволяет им персонализироваться и усваивать новую информацию без дорогостоящего полного переобучения.

- Абстракции «Операционной Системы» для памяти: Концепции, такие как MemGPT и MemoryOS, которые управляют памятью по аналогии с ОС компьютера. Они вводят иерархию (например, быстрая «рабочая память» и медленный «архив») и используют политики для перемещения данных между ними.

- Специализированные методы доступа: Переход от простого поиска по сходству к более сложным механизмам, таким как маршрутизация к «экспертам» (когда запрос направляется к специализированной части памяти) и навигация по графам знаний.

- Иерархические контроллеры: Системы, которые используют многоуровневую память (например, от сенсорного буфера до долговременной) для выполнения сложных многоэтапных рассуждений.

3. Что еще предстоит реализовать (теоретические вызовы)

Это фундаментальные проблемы, которые в статье обозначены как «Вызовы» (Challenges) или «Будущие направления» (Future Directions). Для их решения требуются новые теоретические прорывы.

- Реальная масштабируемость: Хотя модели могут работать с миллионами токенов, поиск по-настоящему в веб-масштабе (миллиарды записей) остается нерешенной проблемой. Текущие методы либо теряют точность, либо становятся вычислительно неподъемными.

- Управление интерференцией памяти: Решение «дилеммы стабильности-пластичности». Нужно разработать теорию, которая позволит моделям непрерывно учиться (пластичность), не разрушая при этом старые, все еще актуальные знания (стабильность). Особенно это касается постепенного «дрейфа» знаний, а не только резких изменений.

- Интеллектуальное «забывание»: Существующие политики (например, «забыть самое старое») слишком примитивны. Нужны теоретические модели адаптивного забывания, которые могут работать в непредсказуемых («нестационарных») средах, где важность информации постоянно меняется.

- Настоящее «пожизненное обучение» (Lifelong Learning): Создание архитектур, которые могут по-настоящему непрерывно учиться на протяжении всей своей «жизни», подобно биологическим системам.

- Глубокая интеграция эпизодической памяти: Переход от ИИ, который просто «знает» факты (семантическая память), к ИИ, который «помнит» свой личный опыт (эпизодическая память) и использует его для адаптации поведения и принятия решений.

- Этика, контроль и прозрачность: Разработка теоретических основ и практических механизмов, которые обеспечат конфиденциальность данных, аудит памяти и контроль пользователя над тем, что ИИ запоминает и как он это использует.

Новые подходы намечаются и в области компьютерного железа — широкое применение в дата-центрах традиционных видеокарт с тензорными процессорами не отменяет разработок альтернативных архитектур. В начале сентября в Nature вышла статья, в которой представлен новый тип компьютера под названием аналоговый оптический компьютер (АОК), использующий свет и аналоговую электронику для решения сложных задач в области искусственного интеллекта и оптимизации:

Gemini 2.5 Pro про АОК

Современные технологии, от ИИ до решения сложных логистических задач, требуют все больше вычислительной мощности. Это приводит к стремительному росту потребления энергии и заставляет цифровые технологии работать на пределе своих возможностей. Существующие альтернативные вычислительные системы, как правило, специализируются либо на задачах ИИ, либо на задачах оптимизации, но не могут эффективно выполнять и то, и другое. Кроме того, они часто тратят много энергии на преобразование сигналов из аналоговой формы в цифровую и обратно.

Что такое аналоговый оптический компьютер (АОК)?

АОК — это гибридная система, которая объединяет трехмерную оптику и аналоговую электронику в единой платформе, способной ускорять как задачи ИИ-выводов, так и комбинаторную оптимизацию. Ключевая особенность компьютера — его полностью аналоговая работа, которая исключает энергозатратные цифровые преобразования.

Как он работает:

Поиск «неподвижной точки»

Вместо выполнения последовательных инструкций, как цифровой компьютер, АОК итеративно ищет стабильное состояние системы, называемое «неподвижной точкой». Этот процесс похож на то, как шарик катится по неровной поверхности и в итоге останавливается в самой низкой точке. Эта конечная «неподвижная точка» и является решением задачи.

Разделение задач

Внутри АОК задачи разделены:

- Оптика: Матрично-векторные умножения, которые являются основной операцией во многих алгоритмах ИИ и оптимизации, выполняются с помощью света. Массив микросветодиодов (microLED) представляет переменные, а пространственный модулятор света (SLM) — веса или коэффициенты задачи. Это происходит практически мгновенно.

- Аналоговая электроника: Остальные математические операции, такие как нелинейные функции, вычитание и сложение, выполняются аналоговыми электронными схемами.

- Обратная связь: Результат электронных вычислений немедленно подается обратно на светодиоды, и цикл повторяется. Каждая такая итерация занимает около 20 наносекунд. Система работает непрерывно, пока не достигнет стабильного решения.

Какие задачи он может решать?

Исследователи продемонстрировали возможности АОК на четырех практических примерах:

- Искусственный интеллект:

- Классификация изображений: Компьютер успешно распознавал рукописные цифры и предметы одежды из стандартных наборов данных MNIST и Fashion-MNIST.

- Нелинейная регрессия: АОК смог аппроксимировать сложные математические функции, что является сложной задачей для аналоговых систем из-за их подверженности шумам.

- Комбинаторная оптимизация:

- Реконструкция медицинских изображений: АОК восстановил изображение медицинского фантома по неполным данным, что может значительно ускорить МРТ-сканирование. Его программная модель (цифровой двойник) успешно справилась с реконструкцией снимка мозга с более чем 200 000 переменных.

- Расчеты по финансовым операциям: Компьютер нашел оптимальное решение для сложной задачи взаимозачета сделок между финансовыми учреждениями — проблемы, которая считается NP-трудной. На реальных данных о расчетах АОК показал 100% успешность, превзойдя результаты квантовых компьютеров.

В чем его главные преимущества и каково будущее?

Основное преимущество АОК — потенциальная энергоэффективность. По прогнозам, масштабированная версия компьютера сможет выполнять вычисления более чем в 100 раз эффективнее самых современных графических процессоров (GPU). Это достигается за счет отказа от преобразований между аналоговыми и цифровыми сигналами и объединения вычислений и памяти.

Текущий прототип является маломасштабным, но технология создана на основе доступных коммерческих компонентов, что упрощает ее будущее производство. Исследователи предполагают, что путем объединения множества таких модулей в трехмерную сетку можно будет создавать системы, способные работать с моделями ИИ, содержащими миллиарды параметров, что необходимо для решения реальных промышленных задач. Таким образом, аналоговый оптический компьютер открывает перспективный путь к созданию более быстрых и экологичных вычислительных систем будущего.

Не отстают и китайцы — ученые из Университета Цинхуа предложили идею оптического процессора OFE2:

Gemini 2.5 Pro про OFE2

Представьте, что вам нужно просеять тонну песка, чтобы найти несколько крупинок золота. Современные компьютеры делают это с помощью электроники, но они тратят много времени и энергии, и уже приближаются к своему пределу скорости.

Ученые предлагают делать то же самое, но с помощью света (фотоники), потому что свет — это самый быстрый способ передачи информации.

Их чип OFE² делает вот что:

- Берет поток данных (например, изображение или график цен на бирже).

- Превращает эти данные в лазерный луч.

- Пропускает этот луч через специальную структуру на чипе, которая использует дифракцию (то, как свет огибает препятствия).

Эта структура работает как хитрый фильтр: она «ловит» и выделяет только самые важные и характерные «особенности» в данных (например, края и контуры на картинке или резкие скачки цен на графике).

Что в этом особенного?

Главное преимущество этого чипа — невероятная скорость и низкая задержка.

- Скорость: Сама ключевая операция (вычисление) на чипе занимает меньше 250,5 пикосекунд. Это триллионные доли секунды.

- Энергоэффективность: Он выполняет огромное количество операций (250 миллиардов в секунду) , потребляя при этом очень мало энергии.

Как они это проверили?

Исследователи протестировали свой чип на двух очень разных, но сложных задачах:

1. Распознавание изображений:

Они «показывали» чипу картинки (например, рукописные цифры или медицинские КТ-снимки).

Чип OFE² мгновенно «видел» и выделял на них все важные контуры и края.

Затем эти «подсказки» отправлялись простому искусственному интеллекту, который в итоге распознавал картинки точнее и быстрее, чем если бы он делал это с нуля.

2. Финансовый «Трейдинг-бот»:

Это самый наглядный пример. Ученые взяли историю цен на золото за 45 лет.

Они подавали эти данные в чип OFE² в режиме реального времени, имитируя биржевые торги.

Чип анализировал колебания цен и мгновенно принимал решение: «купить», «продать» или «держать».

Результат: Система смогла «обучиться» и разработать прибыльную торговую стратегию. А главное, общая задержка от получения новой цены до принятия решения была всего 82 наносекунды — это быстрее, чем у специализированных электронных систем, что на бирже дает огромное преимущество.

Эта работа доказывает, что можно использовать оптические чипы для очень быстрой и энергоэффективной обработки данных. Такая технология может быть полезна там, где на счету каждая доля секунды: в цифровых финансах, медицинской диагностике, беспилотных автомобилях и для будущих поколений искусственного интеллекта.

Помимо оптических чипов, интенсивно развивается и другое перспективное направление, нейроморфные процессоры. Исследователи из Инженерной школы Витерби и Школы передовых вычислений Университета Южной Калифорнии разработали искусственные нейроны, воспроизводящие сложное электрохимическое поведение биологических клеток мозга. В отличие от традиционных цифровых процессоров или существующих нейроморфных чипов на основе кремниевой технологии, которые лишь имитируют нейронную активность, эти искусственные нейроны физически воплощают или эмулируют аналоговую динамику своих биологических аналогов. Подобно тому, как нейрохимические вещества инициируют активность мозга, химические вещества могут использоваться для инициирования вычислений в нейроморфных, или вдохновлённых мозгом, аппаратных устройствах. Будучи физической копией биологического процесса, они отличаются от предыдущих версий искусственных нейронов, которые представляли собой исключительно математические уравнения. Технология, описанная в журнале Nature Electronics, по мнению ее создателей представляет собой прорыв в области нейроморфных вычислений. Она позволит на порядок уменьшить размер чипа, на порядок снизить энергопотребление и может способствовать развитию AGI.

А в американской компании GSI Technology представили чип Gemini-I APU, который по производительности соответствует Nvidia RTX A6000, но потребляет на 98% меньше энергии. Вычислительные операции в Gemini-I APU выполняются не отдельно от памяти, а внутри нее. В ячейки памяти встроены маленькие логические элементы, которые могут выполнять простые битовые операции без выноса данных наружу. Таким образом, память становится одновременно и хранилищем, и вычислителем — за счет чего и происходит такая огромная экономия энергии.

Gemini 2.5 Pro про Gemini-I APU

Прежде всего, GSI Technology использует аббревиатуру APU иначе, чем мы привыкли (например, в игровых приставках или ноутбуках).

- Обычно APU = Accelerated Processing Unit (Ускоренный процессорный блок, гибрид CPU и GPU).

- У GSI APU = Associative Processing Unit (Ассоциативный процессорный блок).

Слово «ассоциативный» здесь ключевое. Оно означает «связывать» или «находить по сходству».

Давайте представим обычный компьютер в виде огромного склада (это память) и одного очень занятого менеджера (это центральный процессор, CPU).

- Как работает обычный CPU: Когда вам нужно найти что-то на складе (например, «все синие мячи»), менеджер (CPU) должен сам пойти в склад (память), взять один предмет, принести к себе в кабинет, посмотреть, синий ли это мяч, записать результат, отнести предмет обратно и пойти за следующим. Это очень медленно, потому что 99% времени тратится на «беготню» туда-сюда между складом и кабинетом.

- Как работает Gemini-I APU: Gemini-I — это совершенно другой подход. Это «умный склад» (или «обработка в памяти»). Вместо одного менеджера, у каждой полки на складе стоит свой маленький работник. Когда вам нужны «все синие мячи», вы просто кричите в громкоговоритель: «Кто стоит рядом с синим мячом?» И все работники одновременно смотрят на свою полку и те, у кого есть синий мяч, мгновенно поднимают руку.

Gemini-I APU, по сути, встраивает тысячи крошечных процессоров прямо в чипы памяти. Он не «таскает» данные к процессору, а обрабатывает их прямо там, где они хранятся.

Этот чип не предназначен для запуска Windows или игр. Он создан для одной задачи, но выполняет ее феноменально быстро: поиск по сходству (Similarity Search).

Это задачи вроде:

- Поиск изображений: «Вот фото кошки. Найди мне все похожие фотографии кошек в базе данных из 10 миллиардов картинок».

- Рекомендации: «Этому пользователю понравилась эта песня. Найди 100 песен, которые звучат похоже«.

- Безопасность: «Проверь этот подозрительный файл и мгновенно сравни его с миллионами известных вирусов, чтобы найти совпадения».

- Наука и фармацевтика: «Найди в базе данных молекулу, которая по своей структуре наиболее похожа на это новое лекарство».

Обычному процессору на такие задачи могут потребоваться минуты или часы, а Gemini-I APU справляется с ними за доли секунды.

Gemini-I APU — это «поисковая система в железе». Это сверхбыстрый процессор для ИИ и больших данных, который экономит время, выполняя поиск не «по одному», а «весь сразу», прямо внутри памяти.

Ну и конечно, было бы несправедливо обойти вниманием новое поколение процессоров Apple, M5. По сравнению с предшественником, M4, производительность ЦПУ у M5 выросла до 15%, а ГПУ — до 30% (до 45% — с трассировкой лучей). Но самым значительным стал рост номинального быстродействия в ИИ-задачах — в 3.5 раза, с 38 до 133 TOPS. Для сравнения, ИИ-производительность анонсированного в сентябре Snapdragon X2 Elite Extreme составляет 80 TOPS. Впрочем, замеры скорости в практических задачах показывают куда более скромный результат — у языковой модели Qwen3-8B-4bit, запущенной на M5, генерация токенов по сравнению с M4 выросла всего на 20%.

Кстати, рыночная капитализация Apple достигла $4 трлн. Во столько же оценивается Microsoft, тогда как стоимость Nvidia, главного поставщика вычислительных ресурсов для ИИ, перевалила за $5 трлн.

Что касается текущих достижений ИИ, то среди них стоит упомянуть следующие:

- Как сообщает работающий в OpenAI франко-американский учёный в области компьютерных технологий Себастьен Бубек, GPT-5 Pro нашла забытое решение одной из открытых математических проблем — доказательство задачи Эрдёша. Несмотря на то, что оно было опубликовано еще в 2003, в соответствующей базе нерешенных математических проблем информация об этом отсутствовала. «GPT-5 Pro превосходит человека в поиске литературы», заключает Бубек. Ранее, в августе, Бубек сделал еще более более громкое заявление — порассуждав чуть больше 17 минут, GPT-5 смогла улучшить решение полученное математиками решение одной проблемы.

- Профессор математики из Калифорнийского университет в Лос-Анджелесе, Эрнест Рю, при помощи GPT-5 Pro решил открытую проблему в теории оптимизации (в которой Рю, по его словам, является экспертом). Как пишут на Хабре, речь идет о сходимости ускоренного метода Нестерова — одного из базовых алгоритмов выпуклой оптимизации, предложенного в 1983 году. ИИ использовался как «rubber duck» (собеседник, которому проговаривают идеи) и «stochastic generator of proof ideas» (стохастический генератор идей для доказательства). 80% предложенных чат-ботом подходов были ошибочными, но остальные 20% оказались настолько результативными, что позволили математику решить проблему за 12 часов, в течение трех дней.

- GPT-5 и Gemini 2.5 Pro выиграли золото на Международной Олимпиаде по астрономии и астрофизике (IOAA). Каждое задание требует многошаговых расчетов, сверки с данными и атласами, глубоких знаний по астрономии и орбитальной механике, построения графиков на небесной сфере и т.д. Модели набрали 85-86%, что соответствует золотой медали и уровню Топ-2 среди 200–300 участников последних лет. Узким место LLM остаются концептуальное мышление, геометрическое мышление и пространственная визуализация. Как уже рассказывал Gadgets News, ранее эти модели выходили на уровень золотых медалистов в международных олимпиадах по математике и информатике.

- GPT-5 Pro и Gemini Deep Think решили 6 и 5 задач соответственно в сложнейшем математическом бенчмарке FrontierMath (Tier 4). Таким образом, результат GPT-5 Pro составляет 13% — что очень неплохо с учетом того, что на решение отдельных задач этого бенчмарка у профессиональных математиков могут уходить дни и даже недели.

- В сентябре вышла работа, авторы который предлагают Тест Гёделя, оценивающий способность ИИ заниматься настоящей математической работой — доказывать новые, ранее никем не решённые теоремы. GPT-5 дали пять задач — три относительно простые и две нетривиальные. Модель предсказуемо справилась с тремя простыми задачами и провалила две сложные, где нужно было объединить идеи из двух разных научных статей. Но приятным сюрпризом стало то, что решение одной из тех трех задач оказалось оригинальным, незнакомым даже самим исследователям. Из этого делается вывод, что современный ИИ уже вплотную приблизился к тому, чтобы стать полезными помощниками для учёных-математиков. Но он пока не может самостоятельно совершать сложные открытия, требующие синтеза знаний из разных областей. И, что очень важно, его работа всегда требует тщательной проверки человеком.

- Крошечная, по современным меркам, модель от стартапа Giotto.ai (200 млн параметров) в бенчмарке ARC-AGI-2 достигла 27% (лучший результат до этого — 17%).

- Небольшая, по современным меркам (27 млрд параметров) модель Cell2Sentence-Scale 27B (C2S-Scale), созданная на базе семейства открытых языковых моделей Gemini компанией Google совместно с Йельским университетом, предложила новую гипотезу о поведении раковых клеток, которая получила экспериментальное подтверждение.

C2S-Scale успешно идентифицировал новый интерферон-обусловленный усилитель, открыв новый потенциальный путь превращения «холодных» опухолей в «горячие» и потенциально более чувствительные к иммунотерапии. Хотя это лишь первый шаг, он даёт мощный, экспериментально подтверждённый задел для разработки новых комбинированных методов лечения, сочетающих несколько препаратов для достижения более выраженного эффекта.

Этот результат также закладывает основу для нового типа биологических открытий. Он демонстрирует, что, следуя законам масштабирования и строя более крупные модели, такие как C2S-Scale 27B, мы можем создавать предиктивные модели клеточного поведения, достаточно мощные для проведения высокопроизводительных виртуальных скринингов, исследования контекстно-обусловленной биологии и выдвижения биологически обоснованных гипотез.

В свою очередь другая модель Google, AlphaFold 3, успешно предсказала 3D-структуру нового самособирающегося пептида под названием RFC. Ученые обнаружили, что этот пептид может образовывать стабильный гидрогель, по сути, 3D-каркас. Его можно использовать для выращивания органоидов из клеток опухоли, взятых у больного раком эндометрия. Эти органоиды в геле сохранили характеристики настоящей опухоли индивидуального больного, включая устойчивость к большинству химиотерапевтических препаратов. Благодаря предварительным испытаниям на этих «мини-опухолях» выяснилось, что доксорубицин (химиопрепарат из группы антрациклиновых антибиотиков) показал самую высокую эффективность в борьбе с раковыми клетками, в то время как другие, включая стандартную терапию, не сработали. Таким образом, созданный при помощи AlphaFold 3 гидрогель (в котором из клеток больного можно выращивать «мини-опухоли» рака) позволяет подбирать правильное лечение.

В числе более скромных, но также полезных достижений ИИ стоит упомянуть расшифровку старинных рукописей. В одной публикации на Хабре автор подробно рассказывает, как когда-то давно расшифровал три рукописных английских документа 17-18 века, и это потребовало от него целый месяц скрупулезной работы. Так вот по словам автора, у ChatGPT расшифровка одного из этих документов заняла всего 9 минут.

Но вернемся к новости о вложениях ИИ-индустрии в дата-центры. Размеры этих вложений беспрецедентны. В рамках ГОЭЛРО за 22 года в СССР было введено электростанций с общей установленной мощностью на 4 ГВт — в случае одних только дата-центров OpenAI речь идет о 30 ГВт в течение нескольких лет. Еще большее впечатление производят объемы финансовых вложений — как уже говорилось выше, сумма инвестиций в проекты с участием OpenAI планируется в объеме $1.4 трлн. В свою очередь рыночная оценка самой OpenAI достигла $500 млрд, а Nvidia, главного поставщика вычислительных ресурсов для ИИ — $5 трлн. Что касается инвестиций в ИИ, то по оценкам Gartner они составили $650 и $990 млрд в 2023 и 2024, и ожидаются на уровне $1.5 и $2 трлн в 2025 и 2026. При этом убытки Microsoft от инвестиций в OpenAI по оценкам некоторых аналитиков только за один квартал составили $12 млрд.

Неудивительно, что на фоне этих головокружительных чисел все чаще и громче слышны разговоры об очередном пузыре — подобному тому, что раздулся в период роста рыночной стоимости Интернет-компаний с 1995 по 2001 годы. Тогда в результате обвала на фондовой бирже «пузырь доткомов» сдулся на пять триллионов долларов. Однако построенная на Интернете цифровая экономика от этого никуда не делась, а раздувшийся до 5 тыс пунктов 10 марта 2000 года и сдувшийся до 1.2 тыс пунктов 11 октября 2002 года индекс Nasdaq Composite на момент публикации этого материала достигает 23.8 тыс пунктов.

Рискну предположить, что в случае аналогичного обвала котировок на этот раз ИИ-компаний, с индустрией искусственного интеллекта не случится ничего страшного, хотя в первое время инвестиции наверняка переживут значительное сокращение. Уже сейчас вполне очевидно, что ИИ работает и успешно монетизируется — от пресловутого вайбкодинга и составления выжимок из больших текстов (причем на родном языке и простыми словами) до генерации и просмотра забавных видео. В настоящее время число активных пользователей ChatGPT превышает 800 млн человек, и почти наверняка в ближайшие месяцы (возможно даже до конца этого года) их будет миллиард. Сейчас доля платных пользователей составляет 5%, но если в будущем все пользователи будут платить в среднем по $20 за месячную подписку (или 200 млн богатых и бизнес-пользователей будут платить по $100), то годовая выручка OpenAI составит $240 млрд. Для сравнения, за последний финансовый год выручка Apple, чья рыночная стоимость достигла $4 трлн, составила $391 млрд. Уместно ли, в таком случае, утверждать, что рыночная стоимость OpenAI в размере $500 млрд однозначно завышена?

В перспективе ИИ тем более обещает стать обязательным инструментов в любой интеллектуальной работе. В октябре OpenAI представила бенчмарк GDPval, оценивающий возможности ИИ при решении реальных экономически значимых задач. В этом бенчмарке первое место заняла конкурирующая с GPT-5 модель Claude Opus 4.1 — она оказалась на уровне человека в 47.6% задач. По мере того как такие модели будут становиться все более умными и автономными, процент выполняемых ИИ задач будет расти — а с ним и монетизация ИИ.

Самой уважительной причиной дальнейшего наращивания установленной мощности дата-центров являются, конечно же, более умные модели. Даже если считать избыточным дальнейшее масштабирование моделей, они в любом случае нуждаются во времени на размышление. Как уже рассказывал Gadgets News, к 2030 году так называемый временной горизонт ИИ-моделей может достигнуть целого рабочего месяца. Временной горизонт — это время, которое потребовалось бы человеку для выполнения требуемой задачи. Соответственно чем дольше будет способен думать ИИ, тем более трудоемкие задачи он сможет решать. Более того, вскоре после релиза GPT-5 Сэм Олтмен заявил, что в OpenAI располагают более лучшими моделями — но не могут их сделать публичными из-за нехватки вычислительных ресурсов. Не говоря уже об амбициях компании в отношении научных открытий. Вот что по этому поводу написал Сэм Олтмен в своем блоге:

Если искусственный интеллект будет развиваться по тому пути, который мы предполагаем, то станут возможны поистине удивительные вещи. Возможно, обладая вычислительными мощностями в 10 гигаватт, ИИ сможет найти способ излечить рак. Или, имея те же 10 гигаватт вычислений, ИИ сможет обеспечить персональное обучение для каждого ученика на Земле. Если нас будут ограничивать вычислительные ресурсы, нам придётся выбирать, чему отдать приоритет; никто не хочет делать такой выбор, поэтому давайте строить.

Наша цель проста: мы хотим создать фабрику, которая сможет производить инфраструктуру для ИИ мощностью один гигаватт каждую неделю. Реализовать это будет чрезвычайно трудно; нам потребуются годы, чтобы достичь этой цели, и новаторские решения на всех уровнях — от микросхем и энергетики до строительства и робототехники. Но мы уже усердно работаем над этим и верим, что это возможно. На наш взгляд, это будет самый захватывающий и важный инфраструктурный проект в истории.

В заключение — про AGI. Группа исследователей из ряда весьма авторитетных образовательных центров (среди со-авторов также такие известные личности как Йошуа Бенжио и Гэри Маркус) выпустила бенчмарк, оценивающий степень готовности человекоподобного ИИ. Бенчмарк был анонсирован в октябре, и в нем дается очередное определение AGI:

AGI — это искусственный интеллект, который может сравниться или превзойти когнитивную универсальность и навыки хорошо образованного взрослого человека.

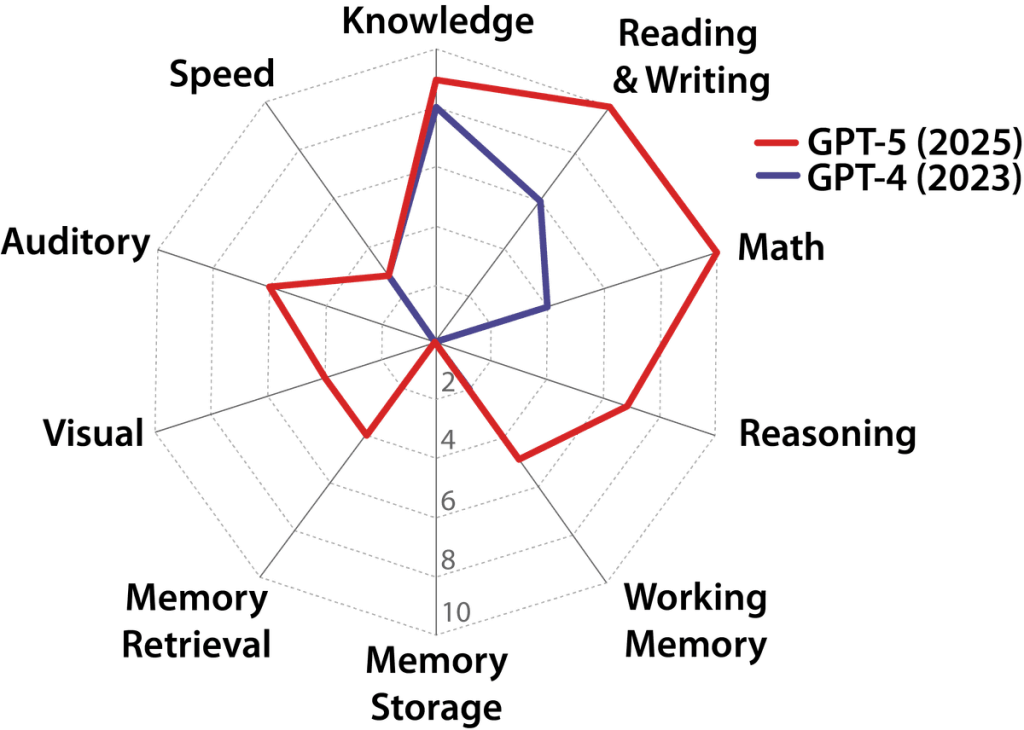

И если это лаконичное определение едва ли прибавляет понимания что такое AGI, то в самом бенчмарке это понятие раскрывается более полно. Бенчмарк представляет собой комплексный тест из десяти тестов, чьи вопросы охватывают общие знания, умение читать и писать, математику, способность рассуждать, работу с визуальным и звуковыми образами, запоминание и т.д. Для 100% соответствия AGI в каждом из этих тестов надо набрать по 10%, и вот как выглядит фактический результат у GPT-5 и его предшественника GPT-4:

По мнению авторов бенчмарка, GPT-5 фактически достиг уровня AGI в способности читать и писать, математике (10%) и общих знаниях (9%). Хуже всего дела обстоят с обработкой звуковой и визуальной информации (6% и 4%), скоростью (3%) и долговременным запоминанием (0%). Итоговая оценка GPT-5 составляет 58%, что более чем вдвое превосходит оценку GPT-4 (27%).

Создатель Консервативного обратного отсчёта Алана до появления AGI, Алан Д. Томпсон, подверг новый бенчмарк критике, указав, помимо прочего, на игнорирование в нем физических способностей ИИ. «Интеллект, который не способен физически взаимодействовать с миром, — не является общим интеллектом», настаивает Томпсон. Согласно отсчету самого Томпсона, степень готовности AGI сейчас составляет 95%, а год назад — 83%.

Вряд будет оригинальным предположение, что обе оценки являются чрезмерно оптимистическими. С одной стороны степень приближения GPT-5 к AGI в новом бенчмарке значительно меньше (58%) аналогичного показателя в «консервативном» отсчете Алана (95%). Но с другой стороны, с учетом всего лишь 27% у GPT-4, такая динамика прогресса позволяет рассчитывать, что AGI — дело ближайшего будущего. С этим поспорит не только Эндрю Ын (которые отводит созданию AGI десятки лет), но и Андрей Карпаты. Последний, комментируя свое недавнее интервью, назвал срок в 10 лет «весьма оптимистичным горизонтом для достижения AGI».

Еще более оптимистичные прогнозы принадлежат Илону Маску:

- 17 сентября: Теперь я думаю, что у xAI есть шансы достичь AGI с помощью Grok 5. Раньше я так не думал

- 18 октября, утро: Моя оценка вероятности того, что Grok 5 достигнет уровня AGI сейчас составляет 10% и продолжает расти

- 18 октября, вечер: Grok 5 будет AGI или чем-то, неотличимым от AGI.

Если второе сообщение формально не противоречит первому, то в третьем выражается явная уверенность, что Grok 5 достигнет уровня AGI — что не вполне соответствует 10% вероятности такого события во втором сообщении. В этом отношении Маск напомнил одного известного российского политика (ныне покойного), который делал множество противоречивых заявлений и прогнозов — авось какой-нибудь и сбудется…

На вышеупомянутом видеостриме с участием главы OpenAI Сэма Олтмена и главного ученого компании Якуба Пахоцкого было озвучено несколько интересных фактов — в том числе и о перспективах ИИ:

- До ASI (искусственного сверх-интеллекта) возможно осталось меньше 10 лет;

- Современные модели могут работать над исследованиями, занимающими [у людей] 5 ч, и этот прогресс продолжится. OpenAI ожидает ИИ-исследователей уровня интерна к сентябрю 2026, и автоматические исследования, полностью проведенные ИИ — к марту 2028. Соответственно, в 2026 ИИ начнет делать небольшие открытия, в 2028 — средние;

- На вопрос о сроках появления AGI, Якуб Пахоцкий сказал, что в будущем 2025 год возможно будут воспринимать как период перехода к AGI. В свою очередь Сэм Олтмен считает, что под критерии AGI подходит способность ИИ проводить полностью самостоятельные исследования, и соответственно AGI следует ожидать к марту 2028;

- По мнению Сэма Олтмена, одно из самых удивительных его наблюдений состоит в том, что последние несколько лет стоимость ИИ падает в 40(!) раз за год.

Как мы уже говорили, появление AGI (случись оно через годы или десятилетия) вряд ли состоится как некое громкое событие. За революционными научными открытиями часто следуют годы проверок и подтверждений, за революционными изобретениями — многие годы улучшений. Первые ткацкие станки часто ломались, первые паровые машины были ненадежными и имели низкий КПД, и т.д. Можно ли, например, считать годом рождения авиации 1903 год, когда самолет братьев Райт с четвертой попытки преодолел дистанцию в 260 метров, находясь в воздухе одну минуту? Это была технологическая революция, или просто удачное совмещение уже известных технологий? Или годом рождения авиации следует считать 1902 год, когда немецкий математик Мартин Кутт сформулировал теорему о подъемной силе крыла (в 1904 году ее, независимо от Кутта, сформулировал русский механик Жуковский)?..

В случае искусственного интеллекта так же нельзя быть уверенным в необходимости революционных, или во всяком случае громких, изобретений. Искусственные нейронные сети, метод обратного распространения ошибки, обучение с подкреплением, трансформеры, языковые модели — по отдельности анонсы всех этих технологий вовсе не сопровождались сенсацией. К нынешним достижениям современный ИИ шел на протяжении долгих десятилетий, и едва ли можно выделить изобретение, сыгравшее в этом ключевую роль. При том, что современные системы ИИ на AGI вовсе не претендуют, весьма вероятно, что в будущем условной датой появления AGI будет объявлен год (в т.ч. 2025) появления технологии, которую пост-фактум признают решающей. В этом смысле трудно не согласиться с Якубом Пахоцким, что в будущем 2025 год возможно будут воспринимать как период перехода к AGI.

Что касается сроков появления AGI в практическом значении этого термина — как ИИ, способного решать любые интеллектуальные задачи не хуже человека (хотя бы за исключением выдающихся ученых), то на сегодня складываются 5 групп прогнозов:

- Супер-оптимистичный (глава Anthropic Дарио Амодей) — 2026-2027;

- Оптимистичный (глава OpenAI Сэм Олтмен) — 2028 год;

- Умеренно оптимистичный (глава Google DeepMind Демис Хассабис) — с 2030 по 2035;

- Умеренно пессимистичный (Андрей Карпаты) — через 10 лет в лучшем случае;

- Супер-пессимистичный (Эндрю Ын) — через несколько десятилетий в лучшем случае.

Здесь отсутствует вышеупомянутый прогноз Илон Маска, возглавляющего, помимо Tesla и SpaceX, компанию xAI (Grok 4). В апреле 2024 он допускал появление AGI в конце 2025, и, как видим, продолжает придерживаться (пусть и несколько противоречиво) этого прогноза даже сейчас, говоря о Grok 5. Илон Маск славится своими несбывшимися прогнозами (в частности, что еще до конца 2017, то есть 8 лет назад, состоится автопробег беспилотной Tesla из Нью-Йорка в Лос-Анджелес), поэтому в качестве экспертного его мнение рассматривать пожалуй не стоит. Что касается «крестных отцов» ИИ, то их прогнозы выглядят так:

- Джеффри Хинтон — от 5 до 20 лет;

- Йошуа Бенжио — от 5 до 20 лет (с 90% уверенностью). Такой прогноз он сделал в августе 2023, более свежая информация отсутствует;

- Ян Лекун — от 5 до 10 лет — «если все пойдет хорошо». Такой прогноз он сделал в ноябре 2024.

Таким образом, максимальный срок, отводимый крестными отцами ИИ на появление AGI — 20 лет (2045), а минимальный — 5 лет (2030).