Cerebras WSE-3: третье поколение суперчипа с 4 трлн транзисторов

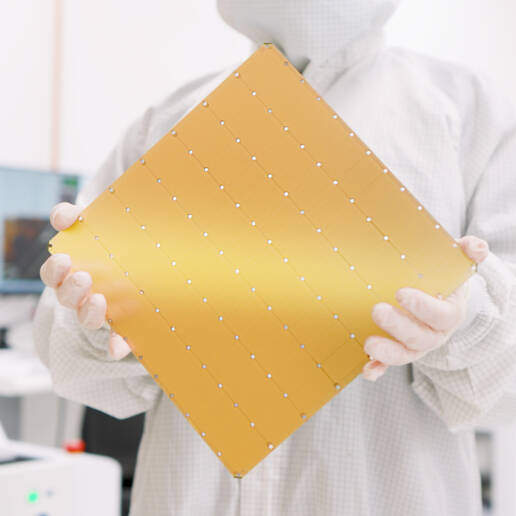

Сегодня американская компания Cerebras представила 3-е поколение своего суперчипа, WSE-3. Напомним, что это самый большой в мире монолитный процессор — его площадь составляет невообразимые 462 см2 — в 57 раз больше, чем у и без того немаленького Nvidia H100 (826 мм2).

Вот как изменились характеристики WSE-3 по сравнению с его двумя предшественниками:

| Cerebras WSE | Cerebras WSE-2 | Cerebras WSE-3 | |

| Дата анонса | август 2019 | апрель 2021 | март 2024 |

| Цена | ~ $2.5 млн | ~ $2.5 млн + 20-25% | |

| Энергопотребление пиковое | 23 кВт | 23 кВт | 23 кВт |

| Техпроцесс | TSMC 16 нм | TSMC 7 нм | TSMC 5 нм |

| Площадь кристалла | 462 см2 | 462 см2 | 462 см2 |

| Кол-во транзисторов | 1.2 трлн | 2.6 трлн | 4 трлн |

| Плотность транзисторов (на 1 мм2) | 25.96 млн | 56.246 млн | 115.563 млн |

| Кол-во ИИ-ядер | 400 тыс | 850 тыс | 900 тыс |

| Объем и пропускная способнсть SRAM | 18 Гб 9.6 Пб/с | 40 Гб 20 Пб/с | 44 Гб 21 Пб/с |

| Пропускная способность между процессорами | 100 Пб/с | 220 Пб/с | 214 Пб/с |

Суперкомпьютер, в который устанавливается процессор WSE-3, называется Cerebras CS-3. Его пиковая производительность в ИИ-задачах составляет 125 петафлопс. Согласно производителю, этого достаточно для обучения модели с 24 трлн параметров. В партнерстве с компанией G42 начато создание кластера Condor Galaxy 3, который будет состоять из 64 систем CS-3. Соответственно, производительность такой системы составит 8 экзафлопсов, что сделает Condor Galaxy 3 одним из самых быстрых в мире суперкомпьютеров. Вообще же CS-3 способен масштабироваться в кластер до 2048 систем, на котором обучение Llama 70B (70 млрд параметров) заняло бы всего один день.

Сегодняшний анонс Cerebras как никогда актуален в свете стремительно растущих потребностей ИИ-индустрии в компьютерной производительности. Например, вчера стали известны подробности про два вычислительных кластера Meta, предназначенных для обучения Llama 3 — каждый оснащен 24,576 графических ускорителей Nvidia H100. Ранее глава компании Марк Цукерберг сообщал о намерении довести её вычислительную инфраструктуру к концу года до эквивалента 600 тыс Nvidia H100.