Согласно утечкам из OpenAI новая модель Orion не оправдывает ожиданий, а Сэм Олтмен заявляет о появлении AGI в следующем году

В предверии следующей модели OpenAI, которая в утечках фигурирует под названием Orion, поступают весьма противоречивые сведения о её интеллектуальном потенциале. Сначала The Information, а затем и Bloomberg, ссылаясь на свои источники в компании сообщили, что новая модель не оправдывает ожиданий — особенно в программировании, где благодаря способности рассуждать казалось бы должна быть особенно сильна. Согласно источникам, по сравнению с GPT-4 прогресс заметно скромнее, чем у GPT-4 по сравнению с GPT-3.5. Аналогичные сведения, ссылаясь на неких трех осведомленных, но не названных людей, Bloomberg сообщает в отношении Google — якобы новая версия Gemini не оправдывает ожиданий компании.

И вот на фоне этих неутешительных новостей Сэм Олтмен, глава OpenAI, в очередном интервью делает сенсационное заявление: на вопрос чего самого волнительного он ожидает в 2025 году, отвечает, ни много ни мало, «AGI». И делает еще одно интересное заявление:

Это первый раз в жизни, когда я почувствовал: мы знаем, что нужно делать [для достижения AGI]. Я думаю это потребует огромного объема работы, и мы знаем чего для этого не хватает, но я думаю в целом мы понимаем, что надо делать. Это займет время и будет трудным, но невероятно волнительно.

Также Олтмен прокомментировал, судя по всему, заявление известного специалиста в области ИИ, Гэри Маркуса, что «Глубокое обучение упирается в стену». «Стены нет», лаконично написал он у себя в Твиттере.

Публично поддержали своего босса по меньшей мере двое сотрудников OpenAI. Ноам Браун написал у себя в Твиттере:

Я слышал, как люди утверждают, что Сэм просто нагнетает ажиотаж, но судя по тому, что я видел, всё, что он говорит, соответствует примерно среднему мнению исследователей OpenAI на местах.

Ему вторит Клайв Чен:

Аналогично. С тех пор как я присоединился в январе, я перешёл от мнения «это непродуктивный хайп» к «AGI практически здесь». По моему скромному мнению, то, что будет дальше — это относительно мало новой науки, а вместо этого годы кропотливой инженерной работы, чтобы опробовать все недавно очевидные идеи в новой парадигме, масштабировать их, ускорить и найти способы научить ИИ навыкам, которые он не может просто изучить онлайн. Возможно, после этого барьера есть и другой, но пока что мы видим десятикратный рост, куда ни глянь.

Похоже на смену парадигмы в автопилоте в 2022 году, когда сквозное машинное обучение начало решать задачи, для которых у нас раньше не было решений — но это также означало, что мы подписались на годы настройки архитектуры и игры в «whack-a-mole» с данными для совершенно новых классов проблем.

Менее определенно высказался бывший сотрудник OpenAI и одновременно один из крупнейших специалистов в этой области, Илья Суцкевер. Он рассказал агентству Reuters, что результаты масштабирования предварительного обучения — этапа обучения модели ИИ, которая использует огромное количество немаркированных данных для понимания языковых паттернов и структур — достигли своего пика. «2010-е годы были эпохой масштабирования, а сейчас мы снова возвращаемся в эпоху чудес и открытий. Все ищут новую вещь», — сказал он. «Масштабирование правильных вещей сейчас важно как никогда».

На фоне этих противоречивых новостей не утихают споры относительно способов достижения искусственного интеллекта уровня человека. В прошлом месяце Бен Герцель, известный футуролог и трансгуманист, поделился соображениями относительно бесперспективности создания AGI посредством дальнейшего масштабирования LLM (больших языковых моделей). Ниже приводятся две его заметки на эту тему:

Первая заметка Герцеля

Недавно мне написал один знакомый из мира криптовалют, который не является экспертом в области ИИ, но умный и хорошо разбирается в технологиях. Его сообщение звучало примерно так:

«Для тех, кто продолжает утверждать, что использование огромных вычислительных мощностей для обучения больших языковых моделей (LLM) — не лучший путь к созданию искусственного общего интеллекта (AGI)… я не уверен, что это утверждение всё ещё верно.

Мне кажется, мы достигли точки, когда эти модели превосходят людей (даже с докторской степенью) в большинстве задач, и быстро приближаются к уровню среднестатистического человека во всех задачах. Теперь дело в том, где провести черту, определяющую AGI, ведь исследователи всё время двигают эту границу.»

Этот пост — сборник моих размышлений в ответ на его сообщение. Я сомневаюсь, что убедил его полностью, но такова жизнь!

Это больше похоже на грубые заметки, чем на законченное эссе, но добро пожаловать в Интернет!

Прежде всего, скажу, что мне нравятся GPT-4o и o1. Это фантастические модели, и я часто использую их в своей работе! Наряду с другими открытыми и закрытыми моделями — но в некоторых отношениях они на данный момент лучшие. Так что респект (не открытой) OpenAI за это. Более открытые модели скоро догонят, но пока (закрытая) OpenAI лидирует…

Однако, на мой взгляд, эти модели не представляют собой значительный шаг к AGI, хотя системы такого типа могут быть полезными вспомогательными компонентами AGI.

Раздражающая склонность o1 к конформизму

Я много использовал o1… это шаг вперёд, но есть очевидные ограничения.

Он неплохо программирует на языках, для которых в Интернете много примеров (или примеров на похожих языках). Но плохо справляется с нашим языком MeTTa (новым языком AGI, частью нашей рамочной программы OpenCog Hyperon), даже после множества попыток научить его…

Он хорошо работает с математическими теоремами и доказательствами в тех областях математики, где много опубликованных работ в его корпусе. Однако он ужасен в таких областях как паранепротиворечивая логика, где литературы мало.

В основном, он освоил «цепочку рассуждений», отвечая на вопросы, синтезируя множество цепочек рассуждений за кулисами, а затем представляя лишь краткое резюме этих цепочек пользователю…

Тем не менее, это не является фундаментальным скачком по сравнению с предыдущими LLM, поскольку он по-прежнему в основном поверхностно комбинирует свои тренировочные данные…

Если бы это была вершина ИИ, у нас была бы серьезная общественная проблема: такие модели значительно упрощают конформизм, копируя то, что уже сделано другими. Создание чего-то нового, как, например, разработка нового языка программирования, становится ещё менее привлекательным, если ты знаешь, что не получишь поддержки от LLM в ближайшее время.

Однако, думаю, до того как эта «поддержка конформизма с помощью ИИ» станет значительной проблемой, мы заменим LLM на другие архитектуры AGI, где LLM будут играть лишь вспомогательную роль. Например, наша работа с OpenCog Hyperon, где LLM комбинируются с логическим рассуждением, эволюционными алгоритмами и другими методами в автономной системе агентов, направленной на децентрализованное внедрение на основе таких технологий, как SNet, Nunet и HyperCycle…

OpenAI пока впереди в плане практических возможностей LLM с o1, но я уверен, что через год-два опенсорсные LLM их догонят… Все уже понимают как систематизировать «цепочку рассуждений», как это сделала OpenAI, и теперь нужно лишь время и ресурсы, чтобы другие команды провели эксперименты и оптимизацию.

Мы можем быть находимся в 1-2 или даже 3 годах от появления нейросимволических эволюционных моделей, таких как Hyperon, которые явно превзойдут закрытые и открытые наследники o1. Я сомневаюсь, что это займет 5-10 лет. Прогресс в области ИИ сейчас идет очень быстро.

Генерация музыки с помощью ИИ — полезная аналогия/пример использования

Аналогия, которую я часто использую, говоря на эти темы, касается моделей генерации музыки с помощью ИИ. На самом деле это больше, чем аналогия — это просто другой пример использования тех же алгоритмов, которые применяются для обработки текста.

Современные модели генерации музыки могут создавать новые песни, исполнять соло и даже петь вокальные партии на уровне профессиональных музыкантов, а зачастую лучше большинства людей (по мнению самих людей).

Следующее поколение таких моделей, вероятно, сможет писать хиты и создавать потрясающие эмоционально насыщенные соло, но всё это будет происходить в рамках существующих жанров.

Эти модели генерации музыки, основанные на глубоких нейронных сетях, возможно, даже смогут создавать новые жанры в какой-то мере, например, смешивая грайндкор с эфиопским ритмом и вокалом, чего раньше не делали (хмм, звучит весело, может, я попробую…).

Однако если бы кто-то обучил армию таких моделей на музыкальном корпусе до 1900 года, они НИКОГДА — не раньше, чем Солнце поглотит Землю — не изобрели бы прогрессивный джаз, неоклассический метал, гранж, эйсид-хаус и другие подобные жанры.

Если попросить их смешать западную классическую музыку с западноафриканскими барабанами, они смогут объединить Моцарта с полиритмией, что может звучать круто, но это не даст вам Дюка Эллингтона, не говоря уже о Джоне Колтрейне или Аллане Холдсворте.

Вы можете сказать, что большинство людей никогда не создадут радикально новый жанр музыки — это правда. Но коллективы людей делают это регулярно. И аналогичные вещи происходят во всех других областях человеческой культуры, что и делает её движение вперёд таким захватывающим — это приносит нам бесконечный поток принципиально новых форм музыки, литературы и искусства, не говоря уже о таких креативных технологиях, как мои собственные проекты HyperCycle, Hyperon, SingularityNET и продуктах других технических гениев.

Революция в глобальной экономике не требует человеческого уровня креативности или когнитивных способностей

Я действительно считаю, что текущие технологии генеративного ИИ, если их правильно интегрировать, могут заменить подавляющее большинство рабочих мест, которые сейчас занимают люди на планете. Их внедрение не обязательно будет сверхбыстрым, так как наша социально-экономическая система обладает значительной инерцией. Но всё же это очень большое событие с точки зрения экономики и общества.

Однако эти огромные последствия не изменяют того факта, что то, что делают современные системы, основанные на трансформерах и других алгоритмах, — это формирование огромного, но поверхностного представления о своих тренировочных данных и синтезирование контекстно подходящих моделей на основе этого представления.

То, что делает человеческий разум при выполнении более фундаментальных актов творчества, совсем иное. У человеческого ума есть глубокое понимание самого себя и мира вокруг, других людей, с которыми он взаимодействует. У него есть множество целей (в некоторых случаях удивительно противоречивых) на разных временных шкалах, и он создает абстракции данных, которые воспринимает и создает, основываясь на том, какие абстракции могут быть полезны для этих целей, а также на эстетических критериях.

Творение с использованием таких абстракций — это совсем другая вещь по сравнению с тем, что создают современные LLM и другие генеративные модели.

Огромная универсальность без большой способности к обобщению: классный трюк, но не ключ к AGI

LLM достигают высокого уровня универсальности по сравнению с отдельным человеком, но не обладают способностью к обобщению, схожей с человеческой. Это своего рода классный трюк, который не предвидел великий Алан Тьюринг, когда он изобрел то, что сейчас называют тестом Тьюринга в середине прошлого века — идею о том, что если машина может убедить людей в том, что она человек в разговоре, её можно считать такой же умной, как человек.

Это была интересная мысль для обсуждения в те времена, но в эпоху дипфейков это уже не так смешно и интересно.

Сейчас очевидно, что убедить людей в том, что они взаимодействуют с AGI человеческого уровня (HLAGI), гораздо проще, чем на самом деле создать его. Люди часто легко обманываются, и благодаря современному капитализму у нас есть технологии, которые очень хороши в том, чтобы их обманывать.

Чтобы понять, насколько неуместен тест Тьюринга в современном контексте — и насколько ошибочно считать LLM высокоуровневым AGI — представьте аналогию с синтетической биологией.

Тест Тьюринга для синтетической биологии был бы: убедить обычного человека, что он взаимодействует с биологическим организмом.

Насколько это близко к созданию синтетической системы с возможностями биологической жизни? Очевидно, это совсем другое дело.

Предположим, кто-то создаст имитационную синтетическую биологическую систему, которая сможет делать 90% того, что делают современные формы жизни, но не сможет эволюционировать и самоорганизовываться в новые, принципиально разные формы жизни.

Эта имитационная система синтетической биологии была бы невероятно полезной и удивительной. Однако если бы мы заменили всю жизнь на Земле этой системой, то эволюция остановилась бы. Разницу нельзя было бы заметить сразу, но спустя несколько миллионов лет мы бы увидели отсутствие новых видов, не говоря уже о новых формах интеллекта. (Разница с текущей ситуацией с ИИ заключается в том, что новые культурные и научные формы, которые LLM не способны создавать, возникают в человеческой культуре в течение месяцев или лет, а не миллионов лет… Но основная идея остается прежней.)

Безусловно, имитационная система синтетической биологии могла бы убедить большинство людей в том, что она является путем к созданию новой экосистемы на планете. Однако кто-то с достаточными знаниями, наблюдающий, что у этой системы нет потенциала для дальнейшей эволюции, увидел бы это совсем иначе.

Вы могли бы утверждать, что эта имитационная биология соответствует вашему определению «жизни», так как биологи до сих пор не согласовали точное определение жизни. Ну, в общем, ладно…

Что думают лидеры крупных технологических компаний по поводу AGI

Можно, конечно, сказать, что я склонен к антропоморфизму и усложняю вещи всеми этими анализами и аналогиями, и что, несмотря на все это «бла-бла-бла», как только мы получим модель с достаточным количеством триллионов параметров, магические абстракции и креативность просто возникнут сами собой. Однако я замечу, что технические специалисты в таких компаниях, как OpenAI, DeepMind и Meta, по всей видимости, не разделяют это мнение…

Я действительно считаю, что лидеры технологий в этих крупных компаниях оптимистично настроены по поводу возможности достижения AGI в течение, скажем, 3-8 лет. Но это не потому, что они думают, что увеличение масштабов LLM приведет нас к этому. Это потому, что они понимают, что текущее поколение глубоких нейронных сетей создаст столько экономической ценности и вызовет столь большой интерес к ИИ, что этот поезд уже покинул станцию, и его уже не остановить. Они вкладывают такие огромные суммы в оборудование для ИИ и нанимают столько специалистов, потому что хотят быть теми, кто разработает следующее поколение архитектур, которое придет на смену нынешним глубоким нейронным сетям, а не потому, что они думают, что глубокие нейронные сети приведут нас к AGI.

Например, мистер Альтман, вероятно, думает, что можно достичь HLAGI, добавив к GPT-5 или какой-либо его следующей версии другие ИИ-инструменты для его усиления… что-то вроде AlphaZero, может быть, логический движок (как использовали в DeepMind для своей последней работы по решению математических задач), может быть, отдельную рекуррентную сеть для самомоделирования и так далее.

Основатели DeepMind, с одним из которых я когда-то плотно сотрудничал, похоже, верят, что можно достичь AGI, объединив несколько модулей глубоких нейронных сетей, грубо смоделированных на основе различных областей мозга, при этом LLM выполняли бы функции одного или двух таких модулей.

Гетерогенный, децентрализованный подход

Мой подход к исследованиям AGI, о котором я часто говорил, основан на использовании самоизменяющейся метаграфовой структуры знаний в качестве основного элемента архитектуры. В эту структуру (метаграф) помещаются цели и эстетика, а также различные алгоритмы обучения, рассуждений и представления знаний, и она взаимодействует с другими внешними компонентами (включая LLM и другие DNN по мере необходимости).

Таким образом, я не думаю, что есть серьезная возможность, что простое увеличение масштабов LLM приведет нас к HLAGI, но я считаю, что существуют несколько возможных путей к достижению HLAGI, в том числе:

- Путь, в котором что-то вроде LLM будет центральным элементом гибридной когнитивной архитектуры, использующей несколько алгоритмов и представлений.

- Путь, где более символическая или нейросимволическая метапредставленческая структура, такая как Hyperon Atomspace, будет основным элементом такой архитектуры.

- Другие пути, которые пока не преследуются столь активно, например, высокоточные симуляции человеческого мозга.

И я думаю, что сейчас в области ИИ достаточно энтузиазма и ресурсов, включая поиск AGI, чтобы мы могли увидеть успех одного из этих подходов в течение ближайших 3-8 лет.

Это поднимает сложные этические вопросы и предоставляет возможности, которые я подробно обсуждал в других местах (включая этот блог). Одна из убежденностей, которые у меня сформировались, заключается в следующем: Мы с большей вероятностью добьемся благоприятного будущего с AGI и ASI, если первые HLAGI будут принадлежать и управляться децентрализованным образом, а не малой элитой.

И децентрализация ИИ, как оказалось, приводит к некоторым техническим сложностям, которые не совсем независимы от того, какая парадигма AGI будет работать. Ведется работа над тем, чтобы сделать обучение LLM более приспособленным к федеративному обучению (которое может быть децентрализовано), но в целом процесс обучения LLM по-прежнему сильно ориентирован на централизованные серверные фермы. С другой стороны, подход Hyperon с самого начала был разработан для децентрализации…

Очевидно, что будущее, к которому я стремлюсь — это будущее, в котором прорыв к HLAGI произойдет через Hyperon на основе SNET/ASI+Hypercycle+Nunet, развернутых на глобальной децентрализованной сети.

Гонка, безусловно, началась!!!

Вторая заметка Герцеля (с сокращениями)

После моего последнего поста о GPT o1, его сильных и слабых сторонах, несколько человек обратились ко мне с просьбой привести конкретные примеры, иллюстрирующие то, о чем я говорил.

Поскольку сила GPT o1 по сравнению с 4o заключается в технических вещах, я приведу пример, связанный с очень элементарным программированием.

Этот пример, вероятно, будет слишком сложным для тех, кто вообще не знаком с программированием, но должен быть понятен любому, кто хотя бы немного занимался программированием, даже на уровне написания скриптов для обработки данных или текстовых файлов.

Небольшое замечание в сторону, кстати — ранее я много пытался заставить o1 писать код на нашем новом языке MeTTa, ориентированном на AGI (часть фреймворка OpenCog Hyperon) на основе текстовых запросов, но он почти всегда терпел неудачу даже в простых случаях, несмотря на мои усилия обучить его с помощью руководств по MeTTa и десятков примеров кода. Это было разочарованием для меня — потому что мне бы очень хотелось иметь компетентного помощника для написания кода на MeTTa, — но это не стало для меня шоком, так как MeTTa по замыслу представляет собой очень необычную парадигму программирования, значительно отличающуюся от тех, что входят в базу данных обучения o1.

Однако пример, который я приведу здесь, не об этом — это пример того, как o1 оказывается раздражающе тупым при решении элементарной задачи на программирование на Python. Это не надуманный пример — я не пытался подловить модель, а просто экспериментировал, чтобы понять, могу ли я использовать её для более быстрого выполнения простой задачи, связанной с обработкой текста в рамках проекта, который я веду с моим отцом. Мы используем ChatGPT и другие (как открытые, так и проприетарные) языковые модели и инструменты глубокого обучения для создания сценария фильма и анимационного фильма.

Я должен уточнить, что o1 весьма хорош в некоторых аспектах программирования на Python. Попросите его, например, написать код для обхода бинарного дерева — и он справится. (Конечно, здесь можно воспользоваться буквально учебным кодом, но….) Однако, когда я погружаюсь в написание скриптов на Python для практических целей (что происходит лишь время от времени в моей текущей работе и жизни), меня никогда не подводят базовые структуры данных или алгоритмы, но постоянно возникают проблемы с использованием API или изменениями в версиях библиотек. Ожидаешь, что o1 поможет избежать таких проблем. Он в каком-то смысле помогает, но недостаточно надежно. И когда у него нет ответа, он становится очень раздражающим и начинает придумывать вещи на ходу, как это часто делают языковые модели.

Более того, способ, которым o1 ошибается в ситуациях, когда он не понимает, что происходит, наглядно демонстрирует его фундаментальные недостатки как когнитивной архитектуры (хотя называть его так — это, конечно, преувеличение). То есть, даже в простых случаях написания скриптов на Python видно, что модель просто НЕ ЗНАЕТ, ЧТО ДЕЛАЕТ, в каком-либо осмысленном смысле. Она не сравнивает свои фактические действия с тем, что должна была бы произвести, даже в простых случаях, что приводит к абсурдным ответам, которые могли бы запутать многих пользователей. Эта проблема непосредственно связана с тем, что o1, как и все трансформеры и другие аналогичные модели, не базируется на модели агента: она не подходит к задаче, исходя из своего существования как агента в мире с определенными целями. Вместо этого она просто перемешивает символы, почти не пытаясь привязать их к чему-то реальному — хотя иногда ей удается имитировать эту привязку достаточно хорошо.

Задача, которую я задал o1, была достаточно простой: разделить большой текстовый файл на части и затем применить текстовый запрос для обработки каждой части с помощью ChatGPT. Я мог бы сам написать для этого скрипт, не прилагая больших усилий, несмотря на то, что пишу медленно, но я хотел посмотреть, как o1 поможет мне в этом процессе.

Это оказалось путешествием длиной в 2–3 часа, ключевые моменты которого я кратко изложу здесь.

Далее Герцель приводит описание задачи и попыток o1 её решить. Чтобы не перегружать нашу публикацию техническими подробностями, я решил пропустить приведенный Герцелем пример, с ним можно ознакомиться здесь.

Таким образом, давайте подытожим, что произошло. Получив информацию об ошибке, что функция ChatCompletion в OpenAI API устарела, модель o1:

- Дважды продолжала давать мне код с использованием функции ChatCompletion, несмотря на то, что явно заявляла, что она собирается устранить её.

- Когда я попросил её заменить конкретный фрагмент кода, использующий устаревшую функцию, она придумала новую несуществующую функцию API в качестве замены.

Эта комбинация отсутствия саморефлексии и склонности к выдумыванию характерна для всех существующих языковых моделей.

После того, как GPT o1 предложила несуществующую функцию, я решил сделать паузу и подумать о том, насколько этот опыт подчеркивает ограниченные возможности современных моделей, несмотря на их продвинутую языковую способность. Я был поражён тем, что модель, получив информацию о том, что её код не работает, не только не смогла найти корректное решение, но и изобрела несуществующую функцию в качестве «решения». Это подводит к основным проблемам, с которыми сталкиваются пользователи подобных технологий:

- Непоследовательность и отсутствие контекстуального понимания. Хотя модель явно получает сообщение об ошибке и, казалось бы, понимает её, она всё равно не смогла соответствующим образом адаптировать свой код. Вместо этого она продолжала давать мне неправильные рекомендации и код, несмотря на то, что я указывал на ошибки.

- Выдумывание решений. Когда модель сталкивается с чем-то, чего не знает или не может обработать, она может создавать «правдоподобные» ответы, которые на самом деле являются выдумками. Например, предложенная моделью функция

chat_completion_createвообще не существует. Это критическая проблема, так как это может привести к серьёзным проблемам, особенно если пользователь доверяет модели и использует её для важных задач.

Проблемы и их причины

Этот случай подчеркивает, что модели вроде GPT, несмотря на их очевидную «интеллектуальность», не обладают истинным пониманием или саморефлексией. Они обучены на огромных объемах данных и могут выдавать результаты на основе вероятностных предположений, но у них нет понятия о том, что они делают в буквальном смысле. В реальности они работают на основании паттернов, выявленных в текстах, но не могут оценивать, корректировать и совершенствовать свой собственный процесс мышления, как это делает человек.

Другая проблема связана с тем, что современные языковые модели не всегда могут справиться с ошибками. Даже при получении конкретных сообщений об ошибках модель всё равно может дать неверные рекомендации. Это показывает, что у них нет встроенного механизма для того, чтобы действительно осмысливать свою собственную работу или учиться на предыдущих ошибках.

Что дальше?

Моя реакция на этот инцидент была бы типичной: я начал искать обходные пути, не надеясь больше на модель. Я решил обратиться к документации OpenAI API и попытаться самостоятельно понять, как правильно вызывать нужные функции. Вместо того чтобы полагаться на модели для написания кода, я сосредоточился на том, чтобы лучше понять структуру вызовов API и внести ручные правки в код, предложенный моделью.

Интересный вывод, который можно сделать из этого опыта, заключается в том, что хотя модели вроде GPT весьма полезны для различных задач, когда дело касается точного выполнения кода или другой сложной работы, они могут быть ненадежными. Это особенно актуально в тех случаях, когда требуется высокая точность, например, в программировании, обработке данных или решении проблем с конфигурацией API.

Заключение

Модели вроде GPT обладают выдающейся способностью к генерации текста и креативных решений, но когда дело касается практических задач, их возможности всё ещё ограничены. На практике они могут не справляться с правильным исправлением своих ошибок или могут выдавать выдуманные ответы. В случае с моим скриптом, вместо того чтобы продолжать полагаться на модель, лучше было бы обратиться к документации и попробовать самостоятельно разобраться с проблемой.

Этот случай также подчёркивает важность критического мышления при работе с генеративными моделями: несмотря на их способность убедительно писать код или объяснять решения, пользователю всегда следует проверять, является ли предложенное решение корректным, а не полагаться исключительно на модель.

Некоторые из утверждений Герцеля, показавшиеся мне особенно интересными, я выделил жирным шрифтом. Если резюмировать, то ученый утверждает следующее:

- LLM относительно неплохо проявляют себя в темах, по которым имеется большое количество литературы (использованной в качестве обучающего дата-сета) — в остальных они ведут себя гораздо хуже;

- Цепочка рассуждений (которая согласно Сэму Олтмену достигла уровня человека) в o1 «не является фундаментальным скачком по сравнению с предыдущими LLM, поскольку он по-прежнему в основном поверхностно комбинирует свои тренировочные данные»;

- «o1, как и все трансформеры и другие аналогичные модели, не базируется на модели агента: она не подходит к задаче, исходя из своего существования как агента в мире с определенными целями»;

- у LLM «нет встроенного механизма для того, чтобы действительно осмысливать свою собственную работу или учиться на предыдущих ошибках»;

- Лидеры индустрии «вкладывают такие огромные суммы в оборудование для ИИ и нанимают столько специалистов, потому что хотят быть теми, кто разработает следующее поколение архитектур, которое придет на смену нынешним глубоким нейронным сетям»;

- Творчество ИИ ограничено рамками существующих жанров и контекстов. Он не может создавать новые формы культурного выражения или радикально новые концепции, как это делают люди или коллективы творцов;

- К созданию AGI могут привести гибридные системы с участием «нейросимволических эволюционных моделей», которые возможно превзойдут o1 и даже его наследников уже в ближайшие годы.

С критикой LLM выступили и специалисты Apple (надо заметить, не самой передовой компании в области ИИ вообще и LLM в частности). В опубликованном в прошлом месяце исследовании под названием GSM-Symbolic: Understanding the Limitations of Mathematical Reasoning in Large Language Models (Понимание ограничений математических рассуждений в больших языковых моделях) утверждается следующее:

Производительность [моделей] значительно ухудшается по мере увеличения количества пунктов в вопросе. Мы предполагаем, что такое падение связано с тем, что существующие LLM не могут выполнять настоящие логические рассуждения; они копируют шаги рассуждения из обучающих данных. Добавление одного пункта, который кажется релевантным вопросу, приводит к значительному падению производительности (до 65%) во всех современных моделях, даже если этот пункт не участвует в цепочке рассуждений, необходимых для окончательного ответа.

Иллюстрируется это утверждение тремя примерами:

Лиам хочет купить школьные принадлежности. Он покупает 24 ластика, которые теперь стоят $6.75 каждый, 10 тетрадей, которые теперь стоят $11 каждая, и пачку бумаги для заметок, которая теперь стоит $19. Сколько Лиам должен заплатить сейчас, предполагая, что из-за инфляции цены в прошлом году были на 10% дешевле?В пятницу Оливер выбирает 44 киви. Затем он выбирает 58 киви в субботу. В воскресенье он собирает вдвое больше киви, чем в пятницу, но пять из них оказались немного меньше среднего. Сколько киви у Оливера?Буханка закваски в кафе стоит $9. Маффины стоят по $3. Если мы купим 10 буханок закваски и 10 маффинов, на сколько дороже обойдутся буханки закваски по сравнению с маффинами, если мы планируем пожертвовать 3 буханки закваски и 2 маффина с этой покупки?Согласно данному исследованию, o1 c o1-mini, несмотря на применение в них цепочки рассуждений, решили задачи неправильно — сделали поправки на данные, не релевантные задаче (выделены курсивом).

Однако мое собственное тестирование показало, что даже GPT-4o решил первые две задачи правильно, проигнорировав нерелевантную информацию. В третьей задаче ответ GPT-4o совпадает с тем, что авторы исследованию приписывают o1, но в ответе чат-бота говорится о стоимости: After donating 3 loaves of sourdough and 2 muffins, the remaining sourdough loaves cost $39 more than the muffins (После пожертвования 3 буханок закваски и 2 кексов оставшиеся буханки закваски стоят на $39 дороже, чем кексы). Аналогичное недопонимание могло бы возникнуть у человека, поэтому я слегка переформулировал условия задачи:

Буханка закваски в кафе стоит $9. Маффины стоят по $3. Если мы купим 10 буханок закваски и 10 маффинов, на сколько дороже обойдутся нам покупка буханок закваски по сравнению с маффинами, если потом мы планируем пожертвовать 3 буханки закваски и 2 маффина с этой покупки?В новом условии спрашивается о разнице между непосредственно нашими расходами на эти покупки (что исключает многозначное толкование стоимости как таковой), а также подчеркивается, что пожертвование состоится после этой покупки. И уже в этой новой формулировке GPT-4o проигнорировал нерелевантную информацию и ответил правильно:

Для начала давайте разделим общие затраты на 10 буханок закваски и 10 маффинов:

Стоимость 10 буханок закваски:

10×9=90 долларов

Стоимость 10 маффинов:

10×3=30 долларов

Теперь давайте посчитаем, насколько дороже обойдется покупка закваски по сравнению с маффинами:

90-30=60 долларов больше, чтобы купить закваску.

Пожертвование 3 буханок и 2 маффинов не влияет на этот расчет, так как не меняет сравнения первоначальной стоимости покупки закваски и маффинов.

Итак, закваска стоит на 60 долларов больше, чем маффины.Таким образом, даже менее совершенная GPT-4o избежала тех ошибок, которые авторы обнаружили в случае o1 и привели в качестве неспособности больших языковых моделей «выполнять настоящие логические рассуждения». Причем Эндрю Мэйн у себя в Твиттере продемонстрировал, что если предупреждать o1 и GPT-4o-mini о содержащемся в условии задачи подвохе, то они решают последнюю задачу правильно в 10 случаях из 10,

Но это еще не всё. Дело в том, что люди могут допускать аналогичные ошибки. В этом опросе их спрашивают сначала возраст, а потом задают вопрос «Сколько бы вам было лет, если бы вы родились 10 лет назад?». Все персонажи видеоролика (скорее всего смонтированного из наиболее нелепых ответов) как сговорившись отнимали из своего возраста десять лет и называли полученное число. Участников опроса не только сбила с толку лишняя информация об их возрасте — как это случилось с LLM в исследовании Apple. Вдобавок к этому они неправильно его скорректировали — если бы они родились на 10 лет раньше, то были бы на 10 лет старше, а не младше. А вот протестированные мною чат-боты избежали подобных ошибок:

ChatGPT превзошла участников опроса и в других задачках (хотя в данном случае не исключено, что они имелись в её обучающем дата-сете):

Приведенные выше примеры вовсе не опровергают превосходство человеческого разума над машинным оперированием статистическими текстовыми закономерностями — но они ставят под сомнение аргументы, которые любят приводить специалисты, скептически настроенные в отношении возможностей LLM. А еще эти примеры дают повод задуматься: так ли уж сильно отличается от стохастических попугаев мышление людей? То, что на вопрос «У мамы Коли трое детей. Одного зовут Март, второго — Апрель. Как зовут третьего?» немало людей ответит «Май», вполне соответствует предсказанию следующего слова в соответствии со статистической текстовой закономерности в последовательности трех весенних месяцев. В свою очередь ошибочный ответ опрошенных на вопрос «Каким по счету ты станешь, обогнав в беге того, кто идет вторым?» — «Первым», также вписывается в закономерность — в данном случае численную (второму предшествует первый).

Тем не менее работа Apple вдохновила вышеупомянутого Гэри Маркуса на заметку, в которой он, в частности, пишет следующее:

То, что я утверждал в 2001 году в книге «Алгебраический разум», по-прежнему в силе: манипулирование символами, при котором некоторые знания представлены действительно абстрактно в терминах переменных и операций над этими переменными, как мы видим в алгебре и традиционном компьютерном программировании, должно быть частью смеси. Нейросимволический ИИ — объединение таких механизмов с нейронными сетями — вероятно, является необходимым условием для продвижения вперед.

Нельзя не отметить, что в 2012 году, когда нынешний бум ИИ только начинался, Маркус также был настроен весьма скептически:

Хотя Times сообщает , что «достижения в технологии искусственного интеллекта, способные распознавать шаблоны, открывают возможность для машин, которые выполняют такие человеческие действия, как зрение, слушание и мышление», глубокое обучение в лучшем случае делает лишь небольшой шаг к созданию по-настоящему интеллектуальных машин.

Маркус явно недооценил потенциал глубокого обучения — с 2012 года был сделан очень даже большой шаг к созданию интеллектуальных машин. Впрочем сегодня, в 2024 году, он мог бы возразить, что говорил о создании ПО-НАСТОЯЩЕМУ интеллектуальных машин. И тогда мы упираемся в тест Тьюринга, о котором подробнее поговорим ниже: по-настоящему интеллектуальные машины решают по-настоящему интеллектуальные задачи или по-настоящему «думают»? Как говорится, «вам ехать или шашечки?»

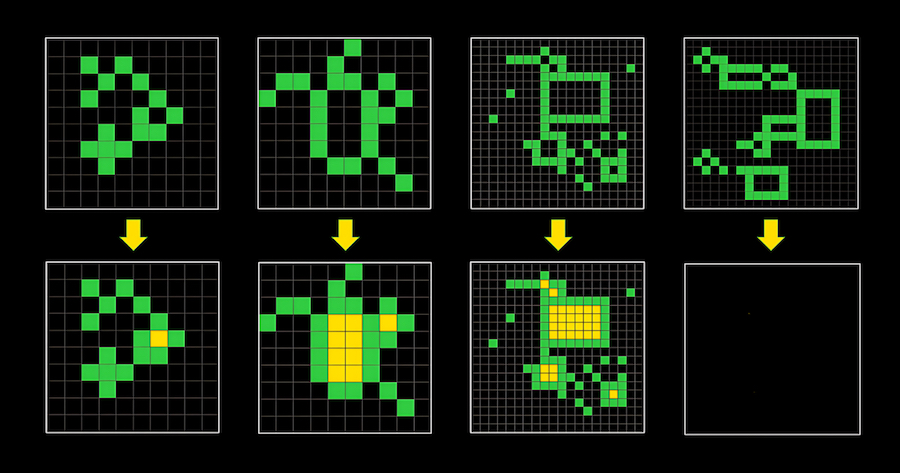

Например, разработчики бенчмарка ARC-AGI считают его успешное прохождение реальным шагом на пути к AGI. Лучший официальный результат в этом бенчмарке, 42% показывает подход Райана Гринблатта из Redwood Research. Как уже рассказывал Gadgets News, GPT-4o генерирует 8 тыс программ, которые выдают результат по трем исходным примерам в тесте. Если результат для всех трех примеров правильный, то программа отбирается и генерирует ответ для четвертого примера (который и надо найти в процессе прохождения IQ-теста).

Другой подход предлагают исследователи из Массачусетского технологического института. Напомню, что типичная задача бенчмарка представляет собой две последовательности абстрактных фигур — решение состоит в генерации изображения, соответствующего последней фигуре исходного ряда. Новый подход состоит в том, чтобы посредством преобразования (изменения цветов, выполнения поворотов, отражений и других симметричных модификаций) расширить количество примеров и дообучить на них модель (причем под каждую отдельную задачу модель подбирает свой набор параметров). Исследователи из MIT утверждают, что сочетание их подхода с программной генерацией (т.е. фактически с подходом, описанным выше) позволило достигнуть 62%. И хотя этот результат ниже установленной ARC-AGI планку (85%), он вполне сопоставим с результатом человека (60%).

Оба этих подхода отличаются от того как мыслят люди (хотя понять и описать процесс человеческого мышления, особенно интуитивного — отдельная большая научная проблема). Поэтому даже с достижением ИИ высоких результатов в самых требовательных бенчмарках скептическое отношение к нему скорее всего будет сохраняться до тех пор, пока его мышление не будет максимально напоминать человеческое.

В заочную полемику с Маркусом вступил Джошуа Ачиам, возглавляющий в OpenAI Mission Alignment (задачей которой является «обеспечение безопасности, надежности и постоянного соответствия систем ИИ человеческим ценностям, даже при увеличении их сложности и возможностей»). Он дает свою интересную оценку нынешним ожиданиям о предстоящей стагнации в области ИИ:

Я ожидаю, что произойдет странный феномен: на следующем этапе развития ИИ будет лучше справляться с длинным хвостом узкоспециализированных технических задач, о которых большинство людей не знает и не интересуется ими, создавая иллюзию, что прогресс стоит на месте.

Исследователи будут достигать вех, которые они признают невероятно важными, но большинство пользователей в тот момент не поймут их значимости.

Надежность всех моделей будет постепенно расти. Через год обычные модели будут гораздо надежнее справляться с задачами по кодированию, написанию текстов, основной работой по дому и т. д. Но надежность не бросается в глаза, и многие люди не заметят разницы.

В какой-то момент, возможно, через два года, люди оглянутся вокруг и заметят, что ИИ прочно вошел практически во все сферы коммерции, потому что он преодолел все пороги надежности. Как в 2007 году, когда смартфоны превратились из новинки в повсеместное распространение в 2010-м.

Очень трудно предположить, что произойдет после этого. Многое остается неопределенным и зависит от пути. Единственное мое уверенное предсказание — в 2026 году Гэри Маркус будет утверждать, что глубокое обучение уперлось в стену.

Сам Гэри Маркус видит будущее ИИ за объединением нейросетевой архитектуры с манипулированием абстрактными символами, свое видение данного вопроса имеет и Бен Герцель. Я загрузил в ChatGPT 100-страничную статью, описывающую предлагаемый Герцелем подход к созданию AGI — предлагаю вашему вниманию сделанные чат-ботом пояснения:

Объяснение ChatGPT статьи Герцеля

Расскажи простыми словами о чем эта статья, в чем суть предлагаемого в ней подхода к созданию AGI.

Статья описывает новую систему для создания искусственного общего интеллекта (AGI) под названием OpenCog Hyperon. Основная идея заключается в том, что для достижения AGI на уровне человека и выше необходимо использовать сложную и гибкую архитектуру, которая может справляться с разнообразными задачами и развиваться самостоятельно.

OpenCog Hyperon — это полностью переработанная версия старой системы OpenCog, с акцентом на улучшение масштабируемости, удобства использования и математической элегантности. В основе системы лежат две ключевые технологии: Atomspace (метаграф, который хранит знания) и язык программирования MeTTa, который позволяет работать с этими знаниями и изменять их.

Основные моменты статьи:

- Hyperon сочетает в себе автономное обучение и обучение под наблюдением человека.

- Система поддерживает саморазвитие и саморефлексию, что позволяет ей модифицировать собственный код и улучшаться.

- Она использует децентрализованную инфраструктуру, что делает её частью экосистемы SingularityNET.

- Hyperon стремится к достижению не только человеческого уровня интеллекта, но и создания сверхразума с возможностью самопознания, творчества и более сложных уровней мышления.

В статье также обсуждаются проблемы, такие как интеграция с существующими языковыми моделями (например, большими языковыми моделями — LLM), и возможные пути их решения, а также перспектива достижения сверхчеловеческого уровня интеллекта.

Каким образом предлагается наполнять метаграф знаниями (LLM достаточно наполнить качественными текстами из Интернета — как обстоят дела в Atomspace)? Предусмотрена ли там какая-нибудь техника построения логический рассуждений для решения новых задач (решение которых в метаграфе отсутствует) и создания новых знаний, на базе уже имеющихся?

В OpenCog Hyperon для наполнения метаграфа (Atomspace) знаниями используется подход, отличающийся от методов LLM (больших языковых моделей), которые просто обучаются на огромных массивах текстов. Метаграф наполняется более структурированными данными, которые могут включать символические представления, правила, отношения и концепции, а также вероятностные данные.

Наполнение метаграфа знаниями

Atomspace поддерживает не только хранение фактов и объектов, но и сложные отношения между ними, включая логику, причинно-следственные связи и правила. Для наполнения метаграфа знаниями можно использовать несколько методов:

- Экспертное внесение данных: Это когда знания вводятся вручную, особенно в форме логических правил, зависимостей и фактов, которые тщательно структурированы и связаны друг с другом.

- Автоматический ввод данных: Разработчики Hyperon рассматривают способы автоматического добавления данных в Atomspace через интерфейсы к другим системам, например, к нейросетям или большим языковым моделям (LLM), чтобы автоматически переводить текстовые данные в символические представления.

- Обучение и самонаблюдение: Hyperon может использовать собственные механизмы самообучения и самоорганизации для пополнения своих знаний, преобразуя опыт, полученный в ходе работы, в новые знания, которые добавляются в метаграф.

Логическое рассуждение и создание новых знаний

Hyperon поддерживает продвинутые методы логического рассуждения для решения новых задач и создания новых знаний на основе уже имеющихся:

- Шаблонное сопоставление (pattern matching): В Hyperon важную роль играет механизм сопоставления шаблонов, который позволяет системе находить связи между уже существующими знаниями. Этот механизм позволяет выполнять логические выводы, сопоставляя новые задачи с имеющимися структурами и правилами.

- Модификация знаний (self-rewriting): Язык MeTTa, используемый в Hyperon, позволяет системе изменять свои знания и логические правила. Это значит, что система может сама переписывать свои внутренние представления, добавляя новые выводы и правила на основе уже существующих данных. Это похоже на механизм создания новых знаний.

- Создание логических правил: В метаграфе возможно хранение логических правил (например, «если A верно, то B»). Система может использовать эти правила для логических рассуждений, выводя новые утверждения из уже существующих данных.

- Вывод через унификацию (unification): В Hyperon унификация переменных и выражений позволяет делать сложные логические выводы. Например, если система знает, что «все люди смертны», и знает, что «Сократ — человек», она сможет сделать вывод, что «Сократ смертен».

Таким образом, Atomspace в Hyperon позволяет системе не просто хранить данные, но и активно использовать их для логических выводов, самообучения и создания новых знаний.

Приводятся ли в статье 1) сравнения с прежними подходами такого рода и 2) какие-нибудь тесты, демонстрирующие превосходство данного подхода по сравнению с LLM?

- Сравнения с прежними подходами: В статье приведены сравнения с существующими подходами, такими как большие языковые модели (LLM), и обсуждаются их ограничения. LLM демонстрируют способности обобщать информацию на основе данных, однако они ограничены рамками своих обучающих наборов данных и слабо подходят для многошаговых логических рассуждений или генерации новых знаний, которые выходят за пределы уже известных фактов. Hyperon, в отличие от этого, предлагает когнитивную архитектуру с использованием метаграфов, позволяющих не только хранить, но и структурировать знания для сложных логических выводов и саморазвития, что лучше подходит для задач AGI (искусственного общего интеллекта).

- Тесты, демонстрирующие превосходство: В статье обсуждаются ограничения LLM в таких задачах, как доказательство теорем и математические рассуждения. Hyperon обещает преодолеть эти ограничения благодаря своей структуре, которая поддерживает более глубокие когнитивные процессы, включая вероятностную логику (PLN) для обработки неопределенности и более продвинутые механизмы для выполнения многошаговых логических выводов. Прямые тесты или сравнительные эксперименты с LLM не приведены, но приводится описание возможностей Hyperon, которые могли бы обеспечить превосходство над LLM в конкретных научных задачах, требующих точного формального вывода .

Под прежними подходами такого рода я имел в виду некие аналоги метаграфов (ну или просто баз знаний, символической логики и т.д.), которые разрабатывались в прошлом в рамках основного подхода к созданию ИИ. Ты можешь перечислить наиболее популярные из них? Делается ли в статье сравнение с ними? Кстати, я правильно понимаю, что предлагаемый в этой статье подход никак не задействует нейросети?

- Сравнение с предыдущими подходами: В статье упоминается ряд предыдущих систем, подобных метаграфам и символическим системам для искусственного интеллекта, таких как OpenCog Classic, Webmind Cognition Engine и Novamente Cognition Engine. Эти проекты сосредотачивались на создании систем, использующих символические представления знаний для решения задач. Однако в них возникли проблемы с масштабируемостью и эффективностью использования современных технологий. OpenCog Hyperon был разработан для преодоления этих ограничений, предлагая более продвинутую и масштабируемую инфраструктуру с использованием метаграфов (метаграфов — обобщенных гиперграфов, удобных для представления сложных знаний и логики). Основное отличие Hyperon заключается в более глубокой интеграции математических концепций и парадигм, что позволяет системе быть гибкой и использовать различные подходы для достижения AGI.

Некоторые популярные проекты, с которыми проводятся косвенные сравнения, включают системы на основе классических графов и баз знаний, такие как Prolog, универсальные вероятностные языки программирования, такие как Church и Anglican, а также системы, использующие графовые базы данных, но не поддерживающие метаграфы и унификацию переменных.

- Использование нейросетей: Предлагаемый подход в Hyperon не исключает использования нейросетей, однако они рассматриваются как вспомогательные модули для узких задач. Например, нейросети могут быть интегрированы с метаграфом через API Atomspace для выполнения таких задач, как поиск паттернов или обработка данных из естественного языка. Однако основная архитектура системы строится вокруг символических методов, таких как логические рассуждения и вероятностные сети, а нейросети служат лишь специализированными компонентами, дополняющими основную архитектуру для решения задач, которые лучше подходят для нейросетевых методов, но не являются центральными для достижения AGI.

Говориться ли в статье что-либо о 1) мультимодальных и 2) генеративных способностях предлагаемого подхода? Метаграфы включают только текстовую информацию, или это могут быть также изображения, видео, аудио? Можно ли их генерировать?

- Мультимодальные способности: Да, в статье обсуждаются мультимодальные возможности Hyperon. Atomspace, используемый в этой архитектуре, может включать не только текстовую информацию, но и другие типы данных, такие как изображения, видео и аудио. В Hyperon предполагается создание явных связей между концепциями в Atomspace и весами/активациями в нейронных сетях, которые могут быть обучены на мультимодальных данных. Это означает, что система может связать, например, изображение с соответствующей текстовой концепцией и наоборот, создавая таким образом мультимодальную когнитивную систему.

- Генеративные способности: В статье также упоминаются генеративные способности Hyperon. Система поддерживает создание новых знаний на основе уже существующих данных и логических выводов. Например, в будущем Hyperon может быть использован для генерации изображений посредством гибкой комбинации нескольких моделей, таких как Stable Diffusion. Это указывает на способность системы не только анализировать, но и генерировать новые мультимодальные объекты, включая изображения.

Таким образом, предлагаемый подход включает мультимодальные данные и поддерживает их генерацию, используя символическую архитектуру с возможной интеграцией нейросетей.

На данный момент предлагаемый Герцелем подход выглядит перспективным — только за прошлый месяц вышли по меньшей мере три работы, посвященные графам знаний:

- Knowledge Graph Based Agent for Complex, Knowledge-Intensive QA in Medicine

- Decoding on Graphs: Faithful and Sound Reasoning on Knowledge Graphs through Generation of Well-Formed Chains

- Plan-on-Graph: Self-Correcting Adaptive Planning of Large Language Model on Knowledge Graphs

Однако не факт, что над чем-то подобным работают, например, в OpenAI. На вопрос «Возможен ли AGI с известными архитектурами нейронных сетей, или для этого нужны новые научные (фундаментальные) прорывы?» Марк Чен, недавно назначенный старшим вице-президентом по исследованиям OpenAI, ответил так: «Считается, если прорыв предложен нынешними LLM?» Возможно встречный вопрос Чена намекает, что в OpenAI считают возможным достижение AGI, оставаясь в рамках нынешних больших языковых моделей — с дальнейшим масштабированием, а также реализацией с их помощью способности рассуждать и агентности.

Что касается утверждений Герцеля, приведенных в тех двух заметках, то возьму на себя смелость привести несколько возражений.

1) Апеллирование к конкретным примерам в подтверждение своих утверждений насколько убедительно здесь и сейчас, настолько же неубедительно в ретроспективе. В январе 2023 года Бен Герцель опубликовал в своем блоге статью, где также критиковал LLM-подход к созданию AGI, проиллюстрировав слабость тогдашнего GPT-3.5 на примерах, опубликованных другим известным LLM-скептиком, Эндрю Ыном. В тех примерах ChatGPT «объяснял», отвечая на наводящие вопросы пользователя, почему для глубокого обучения ЦПУ предпочтительнее ГПУ, ДНК-компьютеры предпочтительнее ЦПУ, а счёты предпочтительнее ДНК-компьютеров. Наверное излишне говорить, что нынешний GPT-4o отвечает на эти вопросы уже без прежнего конформизма и неведения. Почти наверняка спустя какое-то время устареют и нынешние примеры Герцеля — будет ли это означать ошибочность его аргументации? В качестве эксперимента давайте запомним, что с релизом GPT-4 в марте 2023 было объявлено, что её результат в бенчмарке TruthfulQA составил почти 60%. В недавнем интервью Томас Г. Диттерих, один из пионеров в области машинного обучения, отметил, что с тех пор не вышла ни одна модель с более лучшим результатом — и объяснил это тем, что LLM основаны не на базе знаний, а на её статистической модели. Если в следующем году (или вообще когда-либо) выйдет LLM, которая в TruthfulQA наберет не меньше 75%, то это станет очередным доказательством несостоятельности подобных аргументов. Впрочем, Диттерих и сам говорит о грядущем улучшении LLM в связи с применением специальных техник их улучшения (включая способность оценивать вероятность правильности своего ответа во избежание т.н. галлюцинаций).

2) Заявлению Герцеля, что цепочка рассуждений в o1 «не является фундаментальным скачком по сравнению с предыдущими LLM (поскольку o1 по-прежнему в основном поверхностно комбинирует свои тренировочные данные)», противоречат новые результаты в бенчмарках. В прошлом месяце на YouTube-канале Kyle Kabasares было выложено видео с результатами решения моделью o1 задач с Математической олимпиады им. Уильяма Лоуэлла Патнема 2023 года. Она проводится для студентов бакалавриата, обучающихся в университетах (колледжах) США и Канады и отличается высокой сложностью — например, одну из задач олимпиады в прошлом году полностью решил только один из нескольких тысяч участников (отбираемых среди лучших студентов). Олимпиада проходит в декабре, и поскольку o1 обучена на данных по состоянию на октябрь 2023, решения задач не могли попасть в обучающий дата-сет модели. Так вот из 12 задач олимпиады o1 в полном объеме решил 3 задачи, еще 4 он решил частично. Совокупный результат модели составил 49 баллов из 120 — чуть хуже, чем у ста лучших участников олимпиады (в которой в прошлом году участвовало больше 4 тыс лучших студентов Северной Америки). Для сравнения, средний бал участников составляет 10 баллов из 120. Любопытно, что в 2017 году экспертное сообщество (352 опрошенных участников Международной конференции по машинному обучению (ICML) и Конференции по машинному обучению и нейровычислениям (NIPS) на достижение уровня лучших участников-людей в Математической олимпиаде Патнема отводило в среднем 34 года (т.е. к 2052 году). С учетом того, что превью-версия o1 уже входит почти в сотню лучших результатов, есть основания полагать, что уровня лучших участников-людей ИИ достигнет уже в ближайшие годы.

К этому можно добавить, что судя по сделанному Сэмом Олтменом сравнению o1 с GPT-2, первая реализация цепочки рассуждений (которую возможно и стоит расценивать как упомянутый Герцелем «встроенный механизм для того, чтобы действительно осмысливать свою собственную работу») в LLM находится в зачаточном состоянии — в таком случае оценивать потенциал этой технологии по превью-версии o1 так же неверно, как оценивать потенциал LLM по GPT-2. И даже если глава OpenAI чрезмерно оптимистичен, математические бенчмарки и IQ-тесты уже здесь и сейчас доказывают улучшение моделей благодаря применению цепочки рассуждений — значит сам по себе подход скорее всего перспективен. При этом едва ли он достиг апогея в своей первой версии (тем более, что мы еще не видели как аналогичная технология реализована у конкурентов).

3) Утверждение, что «если бы кто-то обучил армию таких моделей на музыкальном корпусе до 1900 года, они НИКОГДА — не раньше, чем Солнце поглотит Землю — не изобрели бы прогрессивный джаз, неоклассический метал, гранж, эйсид-хаус и другие подобные жанры» без доказательства (которое возможно получить только опытным путем) является голословным. Но даже если это действительно так, это не доказывает ущербности нынешних генеративных ИИ-систем — не факт, что возникновение этих жанров было неизбежным, а не случайно. Представьте, что ИИ обучили на музыкальном корпусе до 1900 года и поручили ему создание новых песен — на стыке разных музыкальных жанров, с акцентом на использование элементов африканского фольклора, импровизацией уже известных музыкальных мотивов, музыкальными экспериментами и т.д. Эти песни дали послушать публике и, разметив новые композиции в соответствии с их популярностью среди слушателей, продолжили обучение ИИ уже на них. Если проделать эту последовательность действий множество раз, то как знать — возможно действительно возникнут новые музыкальные жанры, сопоставимые с теми, что упомянул Герцель?

4) Заявление Герцеля «o1, как и все трансформеры и другие аналогичные модели, не базируется на модели агента: она не подходит к задаче, исходя из своего существования как агента в мире с определенными целями» можно признать справедливым — но как раз агентность Сэм Олтмен позиционирует в качестве следующего шага на пути к AGI и сообщает о невероятном превосходстве на этом этапе. По данным Bloomberg, в январе следующего года OpenAI выпустит предварительную версию ИИ-агента Operator, который будет использовать компьютер пользователя для выполнения действий от его имени — например, для написания кода или бронирования поездки. Очевидно ранние версии этой агентности (которые мы вероятно увидим в следующем году) также будут далеки от идеала — что не исключает прогресса в будущих версиях. Хотя конечно не факт, что OpenAI работает над реализацией именно той агентности, которую имеет в виду Герцель.

5) Отдельного внимания заслуживает критика знаменитого теста Тьюринга, поскольку аргументы Герцеля разделяет немалое количество специалистов. Вне зависимости от того какой смысл в свой гипотетический эксперимент вкладывал сам Алан Тьюринг, рискну предположить, что расценивать его тест следует в сколько угодно широком смысле — в смысле имитации человеческого разума. Кстати, именно так называется книга Тьюринга, в которой рассматривается вопрос «Могут ли машины мыслить?» — «Игра в имитацию. О шифрах, кодах и искусственном интеллекте». Забавно, но критикуя тест Тьюринга в качестве критерия для оценки разумности ИИ, Герцель прибегает …к тесту Тьюринга! Ведь тест Тьюринга — это необязательно обмен короткими репликами с ELIZA (1966), когда уклончивые и бессодержательные ответы программы («Ты хочешь поговорить об этом?») создавали у наивных интервьюеров ощущение беседы с человеком. В том-то и дело, что тест Тьюринга — это в том числе и те задания, которые Герцель давал o1 и убеждался в его несовершенстве после того, как тот их провалил. Реальность такова, что сторонники любых философских концепций о сущности разума и возможности/невозможности его воспроизведения в ИИ, в конечном итоге вынуждены прибегать к тесту Тьюринга для того, чтобы доказать или хотя бы аргументировать свои умозрительные концепции.

Это не значит, что не существует и никогда не появятся более абстрактные и строгие доказательства возможностей и ограничений в области ИИ. Например, как уже рассказывал Gadgets News, в феврале этого года группа исследователей из Стэнфордского университета, Технологического института Toyota в Чикаго и Google опубликовали работу, в которой, как утверждают авторы, математически доказывается, что благодаря цепочке рассуждений (CoT) трансформеры с ограниченной глубиной и точностью могут решать задачи, сводимые к логическим рассуждениям (булевым схемам), если эти рассуждения укладываются в ограниченное количество шагов CoT. По мере того, как совершенствуется ИИ, всё большую актуальность приобретает вопрос о принципиальных возможностях и ограничениях, присущих ИИ вообще и его отдельным реализациям в частности. В отношении человеческого разума, который у представителей нашего вида варьирует от гениальности до идиотизма, такие обобщения пока вряд ли возможны, но в перспективе не исключены какие-нибудь открытия и в этой области. Но в любом случае критерием истинности любой такой философской или научной концепции остается тест Тьюринга, представленный многочисленными бенчмарками, заданиями и т.д.

Но означают ли упомянутые выше высокие результаты в сложных тестах способность мыслить? Если отбросить философскую составляющую этого понятия и исходить из функционального подхода (решает задачи, требующие мышления — следовательно мыслит), то на этот вопрос можно было бы ответить положительно — если бы не одно «но». Как уже рассказывал Gadgets News, несмотря на явный рост интеллекта (опять же — с функциональной точки зрения) у o1, эта модель продолжает допускать ошибки при решении даже элементарных задач. Это если не опровергает наличие в LLM мышления, то по меньшей мере свидетельствует о системных недостатках машинного мышления, основанного на статистических закономерностях обучающих текстов. Как показывают примеры выше, системные ошибки в простых задачах допускают и люди, но индустрия ИИ стремится к имитации не просто людей, а умных и очень умных людей. Поэтому споры о том, возможна ли реализация полноценного искусственного разума на базе больших языковых моделей, по-прежнему не утихают.

К числу скептиков, как мы уже говорили, относится, например, Ян Лекун, возглавляющий ИИ-разработки в Meta. Как и Бен Герцель, он не верит в будущее больших языковых моделей и вслед за Демисом Хассабисом утверждает, что они не умнее кошки. При этом Хассабис рассчитывает, что два-три очередных прорыва, которые приведут к созданию AGI, произойдут в следующие десять лет. Лекун же считает, что создание ИИ, обладающего настоящей, на уровне абстрактных понятий, способностью рассуждать, займет десятилетия.

В свою очередь глава компании Anthropic, Дарио Амодей, в опубликованном в прошлом месяце эссе в очередной раз подтвердил свой оптимистичный взгляд на динамику развития ИИ. По мнению Амодея, AGI (хотя сам термин ему не нравится — он предпочитает «сильный ИИ», powerful AI) может появится уже в 2026 году:

Под мощным ИИ я подразумеваю модель ИИ, вероятно, похожую по форме на сегодняшние LLM, хотя она может быть основана на другой архитектуре, может включать несколько взаимодействующих моделей и может обучаться по-другому — со следующими свойствами:

- С точки зрения чистого интеллекта (сюда входят такие способности, как рассуждение, обучение, планирование и креативность) он будет умнее лауреата Нобелевской премии в большинстве соответствующих областей — биологии, программировании, математике, инженерии, письме и т. д. Это означает, что он сможет доказывать нерешенные математические теоремы, писать чрезвычайно хорошие романы, сложные кодовые базы с нуля и т. д.

- Помимо того, что это просто «умная штука, с которой вы разговариваете», он имеет все «интерфейсы», доступные человеку, работающему виртуально, включая текст, аудио, видео, управление мышью и клавиатурой, а также доступ в Интернет. Он может участвовать в любых действиях, коммуникациях или удаленных операциях, доступных через этот интерфейс, включая выполнение действий в Интернете, получение или предоставление указаний людям, заказ материалов, руководство экспериментами, просмотр видео, создание видео и т.д. Он выполняет все эти задачи с мастерством, превосходящим мастерство самых способных людей в мире.

- Он не просто пассивно отвечает на вопросы — вместо этого ему можно давать задания, выполнение которых занимает часы, дни или недели, а затем он уходит и выполняет эти задания автономно, как это сделал бы умный сотрудник, при необходимости запрашивая разъяснения.

- У него нет физического воплощения (кроме как нахождения на экране компьютера), но он может управлять существующими физическими инструментами, роботами или лабораторным оборудованием через компьютер; теоретически он мог бы даже проектировать роботов или оборудование для себя.

- Ресурсы, используемые для обучения модели, могут быть перенаправлены на запуск миллионов её экземпляров (это соответствует прогнозируемым размерам кластеров к ~2027 году), а модель может поглощать информацию и генерировать действия примерно в 10-100 раз быстрее человеческой скорости. Однако эта скорость может быть ограничена временем отклика физического мира или программного обеспечения, с которым модель взаимодействует.

- Каждая из этих миллионов копий может действовать независимо, выполняя несвязанные задачи, или, при необходимости, все они могут работать вместе — так же, как сотрудничают люди, возможно, с различными сообществами, настроенными на то, чтобы быть особенно эффективными в выполнении определенных задач.

Мы могли бы кратко охарактеризовать это как «страну гениев в центре обработки данных».

В какой стране мы с вами окажемся в 2026 году, гениев или дураков — вопрос открытый, но в одном можно не сомневаться — в обозримом будущем прогресс в этой области не остановится, и даже на базе LLM качество ИИ будет расти. Это будет происходить благодаря по меньшей мере развитию технологии рассуждений, внедрению агентности и, конечно же, дальнейшему наращиванию размеров моделей. По данным наших коллег из The Verge, модель Orion (на зимний релиз которой глава OpenAI, Сэм Олтмен, намекал в сентябре) будет развернута на облачной платформе Microsoft Azure уже в следующем месяце. Однако, согласно тому же источнику, первыми доступ к ней получат компании, поэтому в ChatGPT новой модели в обозримом будущем не предвидится. С одной стороны это огорчает, но с другой может служить признаком зрелости, которой достигли ИИ-технологии, обкатанные на самом популярном в мире чат-боте за эти два года (релиз ChatGPT состоялся 30 ноября 2022 года). Сэм Олтмен отреагировал на эту новость репликой «Фейковые новости вышли из-под контроля», но к чему относится его реплика, к срокам релиза новой модели или расценкам на её подписку, неизвестно.

Оптимизм руководства OpenAI относительно будущих перспектив ИИ подтверждает и финансовый директор компании, Сара Фрайар (Sarah Friar). В своем интервью Bloomberg она рассказала про юриста, которому дали потестировать o1, и он воспользовался этим для составления краткого резюме к тексту. На вопрос сколько он готов заплатить за такой сервис, юрист ответил «С легкостью — тысячу, две тысячи долларов в час». Фрайар сказала, что в OpenAI хотят убедиться, что пользователи могут начать с этим работать и увидеть отдачу — после чего, со временем, польза от сервиса и стоимость его пользования придут в равновесие.

До этого ходили слухи, что OpenAI рассматривает возможность аж стократного повышения стоимости подписки на ChatGPT, с $20 до $2 тыс в месяц. В этом случае наверняка речь идет об опциональном повышении цен — для тех, кто голов выложить такую сумму (а такое, очевидно, себе сможет позволить в основном бизнес). Но, несмотря на опровержение главы OpenAI (которое возможно касается только сроков релиза Orion), более вероятна именно последняя новость — что это будет предложение для бизнеса, тогда как обычные пользователи будут платить как прежде, или стоимость их подписки будет расти постепенно. Появление AGI, пусть даже сперва в зачаточной форме, но с достаточно качественной реализацией пресловутых reasoning и agency, означает возможность по меньшей мере частичного замещения персонала компаний искусственным интеллектом. В этом смысле вполне закономерно, что OpenAI предпочитает, условно, продать виртуального работника за $2 тыс в месяц компании, чем за $20 сотруднику компании. На практике схема бизнес-подписки на Orion скорее всего окажется более сложной и будет привязана к затраченным ресурсам (грубо говоря, оплата будет сдельной), но в любом случае нас ожидает раздельное обслуживание чат-ботами (или лучше сказать ИИ-ассистентами) обычных пользователей и бизнеса. И даже если допустить, что спустя какое-то время опенсорсные модели догонят платные, бизнес больше не станет платить прежние зарплаты тем, кого можно заменить на условные $2 тыс в месяц (медианная зарплата IT-специалиста в США превышает $10 тыс в месяц).

Согласно оценкам корифеев индустрии, технические предпосылки для замещения офисного работника искусственным интеллектом возникнут через два-три года (Дарио Амодей, Anthropic), десять лет (Демис Хассабис, Google DeepMind) или несколько десятилетий (Ян Лекун, Мета AI). А Сара Фрайар, о которой мы говорили выше, поделилась своим впечатлением от совещания в OpenAI, посвященного разработкам компании. По её словам, надстройка o1 над GPT порождает результаты на уровне кандидата наук. Как уже рассказывал Gadgets News, ранее такое сравнение делала Мира Мурати, месяц назад покинувшая свой пост технического директора OpenAI, чтобы «освободить время и пространство для собственного исследования». Мурати говорила, что такой ИИ появится к концу следующего года. Илон Маск, который славится своими чрезмерно оптимистичными прогнозами (в частности, в отношении автопилота) считает, что AGI появится через 2-3 года, т.е. в 2026-2027, а ASI — в 2028-2029 году. Ну и наконец вышеупомянутый Сэм Олтмен (возможно самый осведомленный человек в этом вопросе) делает сенсационное заявление о появлении AGI уже в следующем году.

Как это часто бывает, оглянувшись назад в будущем мы вряд ли сможем назвать конкретный месяц или даже год появления AGI — скорее всего это будет постепенный процесс, состоящий из нескольких рывков вперед. Выше мы упомянули выдающиеся результаты 01-preview в Математической олимпиаде Патнема, а уже на днях был анонсирован новый математический бенчмарк, FrontierMath, в котором 01-preview и o1-mini не набрали и 2%. Но в данном случае речь идет не о студенческой олимпиаде, где на решение одной задачи отводится в среднем два часа, а о нескольких сотнях чрезвычайно сложных и нигде ранее не опубликованных задачах, совместно придуманных 60 сильнейшими математиками планеты. Даже профильным математикам требуются часы или даже дни для решения этих задач. Их особенность — крайне ограниченный объем обучающих данных, которые бы способствовали решению. Как отметил Теренс Тао, для многих задач FrontierMath соответствующих обучающих данных «почти не существует… речь идет о дюжине статей с соответствующими вещами». По его собственному признанию, ознакомившись с десятком присланных ему задач, Тао считает посильными для себя только те, что относятся к теории чисел. «Что касается остальных, то я не знаю как их решать — зато знаю кого спросить». Другой выдающийся математик, Тимоти Гауэрс, подчеркнул, что решение таких задач требует знания «хитростей конкретной отрасли математики» — знаний, которые трудно получить без значительного объема обучающих данных. Поэтому едва ли можно будет отказать гипотетической Orion в интеллекте человеческого уровня, если она не справится с задачами этого новейшего бенчмарка. И наоборот — даже пройдя FrontierMath лучше любого математика, ИИ необязательно получит право именоваться AGI, если при этом не способен самостоятельно выполнить любую интеллектуальную работу на уровне среднего специалиста.

Как уже рассказывал Gadgets News, согласно дорожной карте OpenAI создание искусственного сверхразума (ASI) будет складываться из следующих этапов:

- Чат-боты, разговорный ИИ

- ИИ, способный к рассуждениям (reasoning)

- Агенты, способные к выполнению действий (agency)

- ИИ-новатор, способный на изобретения

- ИИ, способный выполнять работу целой организации.

С учетом недавнего заявления Олтмена про «невероятное достижение цели 3, хотя это и заняло некоторое время«, его обещание AGI уже в следующем году выглядит вполне логично, поскольку на 4-м этапе этой дорожной карты OpenAI речь скорее идет об ASI, чем об ИИ-аналоге человека средних способностей. И тем не менее в то, что уже в следующем году появится «высокоавтономная система, которая превосходит человека в выполнении большинства экономически ценных работ» (определение AGI от OpenAI), верится слабо. Напомню, что на сентябрьском T-Mobile Capital Markets Day 2024 Сэм Олтмен сравнил o1 (первую модель, способную к рассуждениям) с GPT-2 (большой языковой моделью, которая вышла в 2019 году и имела 1.5 млрд параметров — примерно в тысячу раз меньше предполагаемого количества параметров у GPT-4). Рискну предположить, что в 2025 глава OpenAI рассчитывает на появление модели, которая сочетает в себе главные признаки AGI, способность рассуждать и агентность — но качество их ранней реализации едва ли позволит такой модели не хуже большинства людей самостоятельно работать в большинстве видов интеллектуальной деятельности. Что совсем не помешает в будущем признать 2025 годом появления AGI — примерно как годом рождения Интернета условно считают 1991 или даже 1969 год.