Ученые научились преобразовывать сигналы мозга в устную речь

В ближайшие дни в СМИ возможно появится несколько публикаций с громкими заголовками, вроде «ученые научились читать мысли». Пока, к сожалению, до этого очень далеко, но группа исследователей из Калифорнийского университета сделали в этом направлении еще один шаг. В эксперименте участвовали пять добровольцев, страдающие эпилепсией, и по этой причине проходящие лечение при помощи электрокортикографии. Она заключается в том, что пациенту делается трепанация черепа и на открытую кору головного мозга укладывается набор электродов, способных как стимулировать мозговую активности слабыми электрическими сигналами, так и считывать её.

Участников эксперимента просили произносить вслух определенные фразы, и в это время считывали нервные сигналы, поступающие из мозга. Речь идет не о мыслях человека, а об электрических импульсах, посылающих гортани, языку, губам и челюсти такие сигналы, что из них складывается человеческая речь. Набрав достаточно данных, ученые при помощи машинного обучения произвели обратный процесс — преобразовали эти сигналы в искусственную речь. Делалось это в два этапа: преобразование мозговой активности в механические движения виртуального голосового тракта (трехмерной компьютерной модели органов, отвечающих за речь), и преобразование этих движений в речь.

Получилось не идеально, но разборчиво примерно на 50-70% (по результатам опросов нескольких сотен человек). Это существенно более лучший результат по сравнению с тем, что ранее получали в результате преобразования мозговой активности сразу в искусственную речь. Таким образом, ключевую роль сыграло использование промежуточной виртуальной модели голосового тракта. Причем модель, построенная для одного участника эксперимента, может применятся для распознавания мозговых сигналов другого участника.

Несмотря на впечатляющие результаты, необходимо сделать две важные оговорки. Во-первых, речь идет об относительно успешном преобразовании в искусственную речь той электрической активности, которая возникла в мозге во время реального произнесения вслух каких-то конкретных слов. Далеко не факт, что в будущем удасться синтезировать искусственную речь на основе мысленно произнесенных слов, да еще и новых, не охваченных обучением нейросети.

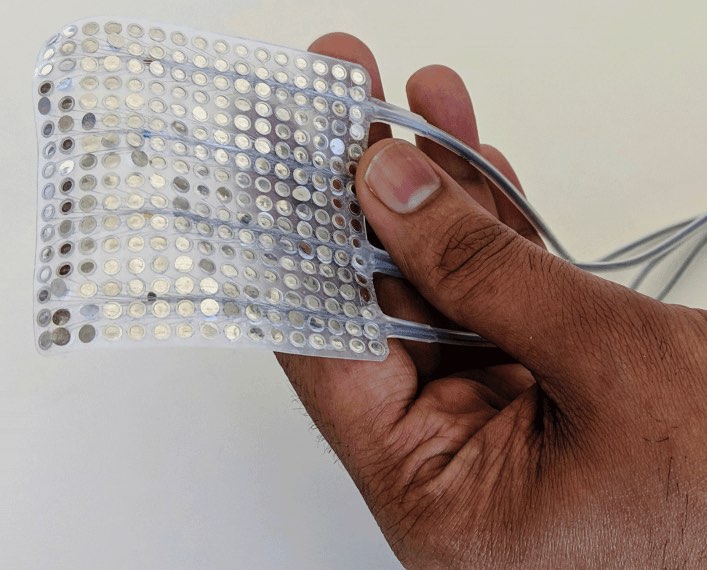

Во-вторых, речь идет о так называемом полуинвазивном интерфейсе, когда электроды не вживляются внутрь мозга, но трепанацию черепа делать все-таки приходится. В этом отношении электроэнцефалография (когда электроды просто прикладывают к голове) была бы куда предпочтительнее — но с ней и точность считывания электрических сигналов куда ниже.

Поэтому остается рассчитывать на то, что в будущем наука либо научится с высокой степенью точности считывать сигналы мозга методом неинвазивной электроэнцефалографии, либо освоит безопасные методы вживления электродов на поверхность коры головного мозга или даже внутри него (что обеспечит еще более высокую точность).

Пока же ученые из Сан-Франциско работают над повышением плотности электродов и улучшением алгоритмов машинного обучения. От себя рискну предположить, что по мере накопления достаточного количества речевых образцов, они смогут построить еще одну нейросеть, которая будет распознавать нынешнюю не вполне связную синтезированную речь и заменять её безупречной.