Microsoft анонсировала Azure Maia 100 и Cobalt 100, Nvidia — H200, а OpenAI приостанавливает подписку на ChatGPT из-за нехватки вычислительных ресурсов

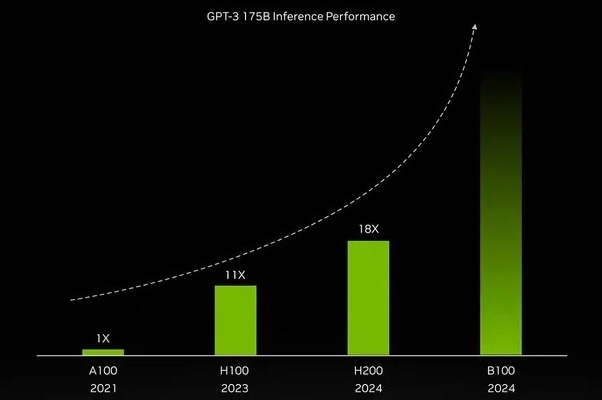

Сегодня мы расскажем о нескольких новостях этой и предыдущей недели, касающихся темы искусственного интеллекта. Эта неделя началась с анонса Nvidia нового ГПУ, H200. Оно представляет собой прокачанную версию графического ускорителя H100, по сравнению с которым объем памяти вырос с 80 Гб HBM3 до 141 Гб HBM3e, а её пропускная способность — с 3.35 Тб/с до 4.8 Тб/с. Улучшение этих параметров дало весьма ощутимы прирост скорости инференса GPT-3 (вывода данных из модели, который происходит в процессе её эксплуатации) :

Обратите внимание, что в этой иллюстрации фактически анонсировано следующее поколение серверных графических ускорителей Nvidia, B100 — его инференсная производительность, судя по графику, вырастет по меньшей мере вдвое даже по сравнению с H200.

Почти одновременно c анонсом Nvidia Аргоннская национальная лаборатория при министерстве энергетики США сообщила о начале обучения на экзафлопсном суперкомпьютере Aurora генеративной модели с 1 трлн параметров, AuroraGPT. Пока обучение производится на 256 узлах суперкомпьютера, но со временем будет масштабировано до его полных ресурсов (около 10 тыс узлов). Новость примечательна тем, что каждый узел суперкомпьютера оснащен двумя 52-ядерными процессорами Intel Xeon Max 9470 (2.4 ГГц) и шестью 128-ядерными графическими ускорителями Intel Max 1550 (128 Гб HBM2e).

Как уже рассказывал Gadgets News, четыре года назад Intel приобрела израильскую компанию Habana Labs. Так вот в следующем году состоится релиз её процессора Gaudi 3, который в BF16-вычислениях превзойдет своего предшественника, Gaudi 2, в целых четыре раза. 4-го поколения Gaudi уже не будет — Intel планирует объединить свои графические ускорители для серверных вычислений в единую платформу Falcon Shores.

На этой неделе обозначился еще один игрок на рынке серверных ускорителей ИИ-вычислений. Microsoft представила два процессора, разработанных совместно с OpenAI (в которую она инвестировала $10 млрд и чей ChatGPT интегрировала в свой поисковик Bing) — предназначенные для облачной платформы Microsoft Azure ГПУ Maia 100 и ЦПУ Cobalt 100. Maia 100 создан на базе 5-нм техпроцесса TSMC и содержит 105 млрд транзисторов. О производительности чипа ничего конкретного не сообщается — помимо того, что в OpenAI назвали его открывающим дорогу для обучения более передовых моделей и снижения стоимости обработки пользовательских запросов. В свою очередь Cobalt 100 — это 128-ядерный процессор с архитектурой ARM на базе кастомизированной версии Neoverse. По сравнению с нынешним поколением ARM-процессоров серверов Azure его производительность выросла на 40%.

Все перечисленное выше — задел на светлое будущее. А позавчера возглавляющий OpenAI Сэм Олтмен объявил, что компания приостанавливает подписку на ChatGPT Plus ($20 в месяц) по причине нехватки вычислительных ресурсов для обслуживания новых подписчиков. Для справки, хотя бы раз в неделю чат-ботом на сегодня пользуется 100 млн человек.

Несмотря на временные трудности с вычислительными ресурсами, на прошлой неделе OpenAI анонсировала обновление своей большой языковой модели, GPT-4 Turbo. Из наиболее примечательных улучшений:

- Размер промта (запроса) вырос c 32 тыс до 128 тыс токенов (около 300 страниц книжного текста).

- Обучающий дата-сет актуализирован на апрель 2023 (был сентябрь 2021). Как уже шутят в Интернете, это прямой путь к обретению самосознания — GPT-4 узнает о своем существовании, поскольку был запущен в марте 2023.

- Были существенно (в 2-3 раза) снижены расценки за использование API (интерфейса доступа к ChatGPT из других программ и сервисов). Кроме того, разработчики получили доступ к API моделей GPT-4V (которая выдает текстовое описание к загруженному изображению), Dall-E 3 (которая, наоборот, генерирует изображение по текстовому описанию), а также значительно улучшенному Audio (голосовому синтезатору text-to-speech).

- Появился инструментарий для создания персональных и специализированных ботов (например, обученных на отдельном дата-сете). Причем взаимодействовать с этим инструментарием можно на естественном языке, что открывает к нему доступ пользователей без программистского образования.

- Созданные пользователями чат-боты можно будет продавать в специальном онлайн магазине.

Последние два пункта, пожалуй, самые важные — в едва начавшейся истории массовых чат-ботов это момент, сопоставимый с анонсом App Store для индустрии смартфонов. Ведь именно этот магазин мобильных приложений превратил сначала iPhone, а потом и смартфоны вообще (с появлением Google Play) в по-настоящему многофункциональные, с миллионами доступных приложений, гаджеты. Благодаря API эти специализированные чат-боты (агенты) смогут взаимодействовать с любыми приложениями на вашем смартфоне, планшете, телевизоре, автомобиле, умном доме, различными интернет-сайтами — и в повседневной рутине станут посредниками между вами и внешним миром.

Таким образом, GPT-5 уже не за горами, тем более что на днях Сэм Олтмен в своем интервью Financial Times подтвердил, что в OpenAI уже работают над этой моделью. Впрочем, это вовсе не значит, что не за горами и AGI (в смысле полноценного интеллектуального эквивалента человека со средними умственными способностями) — в том же интервью Олтмен сказал, что для создания сильного искусственного интеллекта все еще недостает «большого куска».

Заключительная новость, о который мы хотели бы рассказать, исходит от Google DeepMind. Вчера это подразделение Alphabet (Google), занимающееся разработками в области ИИ, представило «свою самую продвинутую музыкальную генеративную модель», Lyria. На её базе будут работать два сервиса, Dream Track и Music AI. Первый позволяет создавать по текстовому описанию 30-секундные видеоролики в стиле заданных исполнителей. А один из инструментариев второго — синтезировать исполненную на заданном музыкальном инструменте мелодию, просто напев её голосом: