Google представила Gemini (сильно приукрасив её возможности) и открыла 2 млн кристаллических структур, Amazon анонсировала Graviton4 и Trainium2, а AMD начала продажи Instinct MI300X

На этой неделе произошло, возможно, главное событие года в индустрии ИИ — компания Google показала, наконец, Gemini — систему, которая «с нуля создана для мультимодальности» и «легко воспринимает текст, изображения, видео, аудио и код». Правда, впечатление от презентации Gemini было подпорчено сноской, что «для целей этой демонстрации задержка была уменьшена, а выходные данные Gemini были сокращены для краткости». На уточняющий запрос Bloomberg в Google ответили, что видео презентации было смонтировано «с использованием неподвижных кадров из видеозаписей и текстовых подсказок». Это совсем не похоже на то, на что показала Google на презентации. А показала она весьма впечатляющие вещи. В числе прочего, Gemini в режиме реального времени:

- описывает то, что рисует пользователь: «Вижу гладкие линии… Похоже на птицу… Это утка, плывущая по воде»

- угадывает под каким из трех стаканов находится шарик (трепещите, напёрсточники!)

- правильно отвечает на вопрос по какой из двух нарисованных дорожек лучше направиться игрушечному утёнку — в конце которой нарисована утка или в конце которой нарисовано нечто угрожающее, идентифицированное Gemini в качестве медведя

- исправляет ошибку в расположении небесных светил (Солнце, Юпитер и Земля)

- правильно отвечает на вопрос какой из нарисованных автомобилей съедет с горки быстрее (тот, у которой визуально явно лучшая аэродинамика).

Как пояснил один из топ-менеджеров Google, «Это видео иллюстрирует как может выглядеть мультимодальный пользовательский опыт, созданный с помощью Gemini. Мы сделали его, чтобы вдохновить разработчиков».

Также следует помнить, что в презентации демонстрируются возможности самой крупной и сильной версии Gemini, Ultra — тогда как в чат-бот Bard интегрирована более слабая, Pro. Последняя, по отзывам пользователей, заметно уступает GPT-4 и находится примерно на уровне GPT-3.5. От себя могу заметить, что логическую задачу, которую я люблю задавать чат-ботам, Bard на базе Gemini Pro с треском провалил — в отличие, например, от встроенной в Microsoft Bing модели GPT-4. Не справился он и с простенькой задачей по арифметике, которую правильно решили даже ChatGPT на базе GPT-3.5 и Claude 2. А непосредственно Ultra-версия Gemini станет доступной в начале следующего года.

Что касается бенчмарков, то в большинстве из них Gemini Ultra превосходит GPT-4 ненамного. И если предположить, что релиз Gemini Ultra состоится в марте 2024, то придется констатировать, что своего конкурента OpenAI компания Google догнала лишь год спустя — и ей придется догонять его снова с релизом GPT-5. Причем длина контекста у Gemini всего 32 тыс токенов — против 124 тыс у вышедшей в ноябре GPT-4 Turbo.

И тем не менее, Gemini (а точнее её Ultra-версия) знаменует собой если не прорыв (или даже пришествие AGI, как поспешили заявить некоторые блогеры), то серьезный шаг вперед. Пусть сервера Google и не способны в интерактивном режиме обрабатывать получаемое от пользователя видео (в это верилось с трудом с самого начала) и гораздо дольше обрабатывают его запросы, чем это выглядит на презентации — это временная проблема, которая упирается в производительность. Если в обозримом будущем дата-центры достигнут производительности, необходимой для подобной интерактивности, то с такими когнитивными способностями в нашем взаимодействии с компьютерами произойдет настоящая революция.

Предпосылки для этого существуют. С одной стороны, разработчики неустанно работают над повышением эффективности своих продуктов. Например, в ноябре Microsoft представила модель Orca 2, которая в версии с 13 млрд параметров заметно превосходит в бенчмарках LLaMA-2 с 70 млрд параметров.

С другой стороны, непрерывно растет производительность графических ускорителей (на которых главным образом обучаются и работают такие модели как Gemini и GPT-4). На этой неделе начались поставки анонсированного в июне AMD Instinct MI300X, чье быстродействие достигает 81.7 TFLOPS FP64. Это уровень пиковой производительности самого быстрого в мире суперкомпьютера в ноябре 2004 (BlueGene/L beta-System, 91.75 TFLOPS FP64) и на 70% больше, чем у анонсированного два года назад Instinct MI250x. А три года назад производительность самого быстрого (на то время) в FP64-вычислениях графического ускорителя, Instinct MI100, составляла всего 11.5 TFLOPS. На одном Instinct MI300X можно запустить модель с 40 млрд параметров. Согласно заявленным AMD результатам тестирования на бенчмарках Instinct MI300X до 60% превосходит Nvidia H100 (анонсирован в марте 2022). Правда, в ноябре этого года Nvidia представила H200, который заметно превосходит предшественника благодаря увеличению памяти и её пропускной способности.

В свою очередь Amazon (а точнее её дочерняя компания Amazon Web Services) в конце ноября представила два новых процессора для своих дата-центров, 96-ядерное ЦПУ (с архитектурой ARM) Graviton4 и ускоритель для задач искусственного интеллекта, Trainium2. Первый на 30% производительнее своего предшественника, второй — в целых 4 раза.

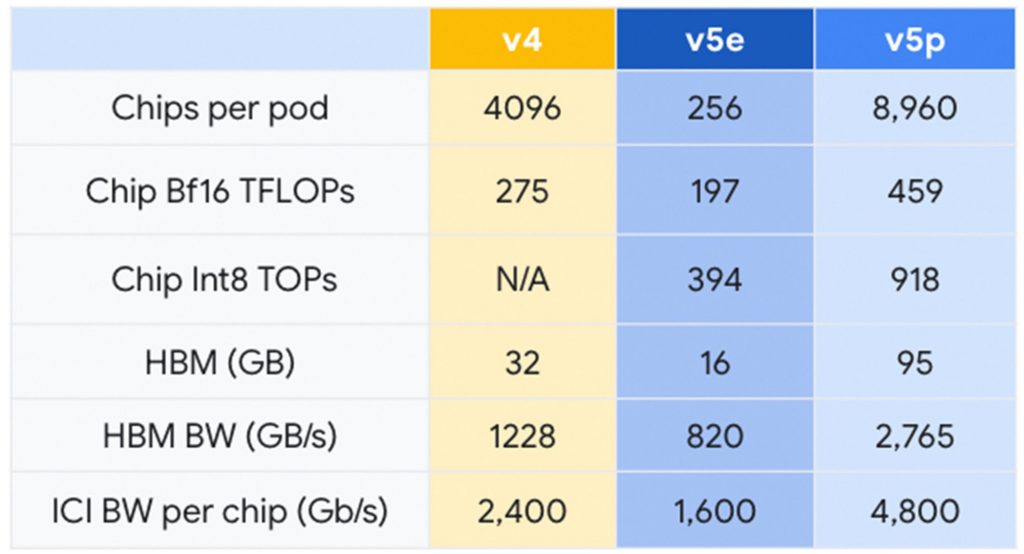

Подобно Amazon, Google предпочитает продукции Nvidia и AMD свои собственные процессоры. Одновременно с Gemini компания представила тензорный чип TPU v5p, который, в отличие от TPU v5e, заточен не на энергоэффективность (e — efficiency), а на производительность (p — performance). В вычислениях с точностью Bf16 он превосходит своего прошлогоднего предшественника на 67%:

Как можно видеть на примере всех этих графических и тензорных ускорителей, производительность платформ, на которых обучаются и работают системы искусственного интеллекта, растет довольно быстро. Сегодня графические ускорители имеют производительность на уровне суперкомпьютеров 20-летней давности, и если эта тенденция сохранится, то в 2040-х настольные системы будут иметь производительность на уровне нескольких экзафлопс. Этому может помешать окончательное прекращение, к тому времени, действия закона Мура — но способствовать появление новых архитектур. Например, нейроморфных процессоров. На днях стало известно, что компания OpenAI, прославившаяся своим чат-ботом ChatGPT, еще в 2019 году подписала соглашение о намерении инвестировать $51 млн в основанную за два года до этого компанию Rain AI. Уже по этой скромной сумме можно заметить, что пока эта индустрия находится в зачаточном состоянии, но сама по себе идея воспроизвести базовые принципы работы мозга не только в софте, но и в железе, представляется весьма перспективной.

Ну и конкретно в случае с Gemini стоит отметить фактор личности — Google DeepMind возглавляет Демис Хассабис. Это один из крупнейших в мире специалистов по искусственному интеллекту, который сочетает инженерное образование с глубоким знанием нейробиологии (PhD в области когнитивной нейробиологии, исследовательская работа по этому профилю в Массачусетском технологическом институте и Гарвардском университете, соавторство в нескольких влиятельных работах, опубликованных в т.ч. в Nature и Science). Словом, достойный соперник Ильи Суцкевера и Яна Лекуна, которые возглавляют разработку ИИ в OpenAI и Meta (Facebook) соответственно. Под руководством Хассабиса DeepMind прославилась сразу несколькими разработками. В частности, это AlphaGo (обыгравшая в го самого Ли Седоля) и AlphaFold (чье второе поколение c 92% точностью построила пространственную структуру 200 млн белков по их аминокислотным последовательностям).

А еще одновременно с Gemini была анонсирована созданная на её основе AlphaCode 2 — второе поколение предназначенной для написания компьютерных алгоритмов системы, в которой возможности большой языкой модели сочетаются со специально разработанным механизмом поиска и ранжирования (для отбора правильного алгоритма среди множества сгенерированных). Согласно Google, по сравнению с предшественником AlphaCode 2 лучше на 70%. Лежащий в основе этих моделей перебор выигрышных стратегий перекликается с научной работой Let’s Verify Step by Step, о которой рассказывал Gadgets News в публикации на тему возможного прорыва OpenAI. Напомню, что в той работе описываются модели вознаграждения с контролем процесса — в противовес нынешним моделям вознаграждения с контролем результата. По мнению некоторых экспертов, именно связка эффективного отбора выигрышного варианта с большими языковыми моделями может стать ключом к созданию AGI — искусственного интеллекта человеческого уровня.

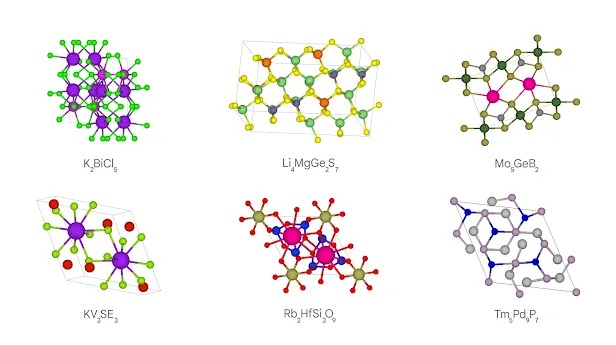

И в заключение про еще одну разработку Google DeepMind — GNoME. При помощи этого инструмента были открыты 2.2 млн кристаллических структур — включая 380 тыс стабильных материалов, которые могут сыграть важную роль в будущих технологиях. Например, это 528 потенциальных литий-ионных проводников, которые можно использовать для улучшения характеристик перезаряжаемых батарей. По мнению Google, этот огромный объем полученных данных эквивалентен знаниям, накопленным за 800 лет. AlphaFold и GNoME здесь и сейчас закладывают предпосылки для важных научно-технических достижений в будущем. А также для еще большего количества научных публикаций. И в этом отношении Gemini и подобные ей модели могут оказаться большим подспорьем. На презентации рассказали о способности Gemini отбирать среди сотен тысяч научных публикаций те, что отвечают заданным критериям, и извлекать из них необходимую информацию. Вероятно это еще не совсем то, о чем мечтал Gadgets News в публикации Будущее информационной революции: что нас ожидает в ближайшие десятилетия? — но уже нечто похожее.