Новинки Nvidia на GTC 2016

Главными технологическими событиями этой недели пожалуй стали первая в истории успешная посадка многоразовой ракеты Falcon 9 на платформу в открытом океане, а также презентация Nvidia на GTC 2016 — выставке, посвященной графическим ускорителям. И если космические технологии не вполне вписываются в формат нашего блога, то рассказать о новинках Nvidia мы просто обязаны.

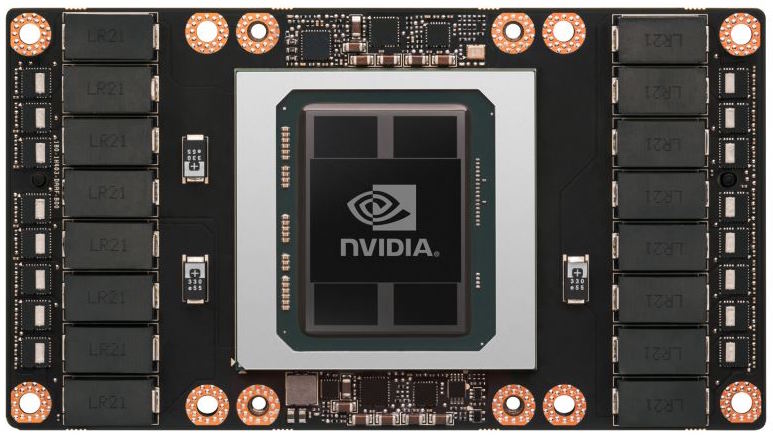

Начнем с Tesla P100. Её отличают следующие уникальные для видеокарт этой серии свойства:

- 16-нанометровый техпроцесс. Причем используемая в ГПУ кристаллическая пластина обладает самой большой в мире площадью среди пластин с этой топологией — 610 мм²

- Новейшая архитектура Pascal

- Память новейшего стандарта HBM2

- Поддержка разработанного Nvidia интерфейса NVLink, благодаря которому взаимодействие видеокарт между собой и с процессорами осуществляется в серверах в 5-12 раз быстрее традиционного PCIe 3-го поколения

- Поддержка новых алгоритмов искусственного интеллекта.

Это самое крупное обновление видеокарт Nvidia для рабочих станций с тех пор, как в ноябре 2014 года компания представила Tesla K80. Более того, глава Nvidia назвал этот плод усилий нескольких тысяч инженеров самым амбициозным проектом, когда-либо предпринятым компанией. Причем массовое производство новинки уже началось. Ниже представлены сравнительные характеристики Tesla P100 и её предшественников:

| Tesla P100 | Tesla K80 | Tesla K40 | Tesla M40 | |

| Техпроцесс | TSMC 16нм FinFET | TSMC 28нм | TSMC 28нм | TSMC 28нм |

| Архитектура | Pascal | Kepler | Kepler | Maxwell 2 |

| Кол-во транзисторов | 15.3 млрд | 2 x 7.1 млрд | 7.1 млрд | 8 млрд |

| Кол-во ядер FP32 | 3,584 | 2 x 2,496 | 2,880 | 3,072 |

| Кол-во ядер FP64 | 1,792 | 960 | 96 | |

| Частота ядер базовая | 1328 МГц | 562 МГц | 745 МГц | 948 МГц |

| Частота ядер разогнанная | 1480 МГц | 875 МГц | 810 МГц, 875 МГц | 1114 МГц |

| Память | HBM2 1.4 Гбит/с | GDDR5 5 ГГц | GDDR5 6 ГГц | GDDR5 6 ГГц |

| Разрядность шины памяти | 4096-бит | 2 x 384-бит | 384-бит | 384-бит |

| Пропускная способность памяти | 720 Гб/с | 2 x 240 Гб/с | 288 Гб/с | 288 Гб/с |

| Объем видеопамяти | 16 Гб | 2 x 12 Гб | 12 Гб | 12 Гб |

| Производительность FP16 | 21.2 терафлопс | |||

| Производительность FP32 (базовая/ускоренная частота) | 10.6 терафлопс | 5.6/8.74 терафлопс | 4.29/5 терафлопс | 6.82 терафлопс |

| Производительность FP64 (базовая/ускоренная частота) | 5.3 терафлопс | 1.87/2.91 терафлопс | 1.43/1.66 терафлопс | 0.21 терафлопс |

| ГПУ | GP100 | GK210 | GK110B | GM200 |

| Энергопотребление | 300 Вт | 300 Вт | 235 Вт | 250 Вт |

Появление серверов на базе Tesla P100 ожидается в начале 2017, впрочем один из них Nvidia предлагает уже в конце июня — DGX-1. Его конфигурация выглядит так:

| Процессоры | 2 x Intel Xeon E5-2698 v3 |

| Видеокарты | 8 x Nvidia Tesla P100 |

| Оперативная память | 512 Гб DDR4-2133 (LRDIMM) |

| Видеопамять | 128 Гб HBM2 |

| Постоянная память | 7 Тб SSD (4 x Samsung PM863 1.92 Тб) |

| Сеть | 4 x Infiniband EDR 2 x 10GigE |

| Энергопотребление | 3,200 Вт |

| Корпус | 3U Rackmount (86.6 x 44.4 x 13.1 см, 60.8 кг) |

| Производительность | FP16: 170 терафлопс FP32: 85 терафлопс FP64: 42.5 терафлопс |

| Операционная система | Ubuntu Server Linux |

DGX-1 представляет собой аппаратную платформу для научных вычислений и одной из самых интересных технологических задач новейшего времени — самообучения искусственного интеллекта. На презентации он был представлен как «первый в мире суперкомпьютер глубокого обучения«. И неудивительно — такие задачи действительно хорошо ложатся на архитектуру графических ускорителей. Если обучение в сети глубокого обучения Alexnet на платформе из двух процессоров Intel Xeon E5-2697 v3 (розничная цене $2.7 тысяч) длится неделю (150 часов), то на DGX-1 — всего два часа, т.е. в 75 раз быстрее. Если сравнивать с более подходящей для выполнения таких задач платформой, то на системе из четырех видеокарт с архитектурой Maxwell этот процесс занял бы сутки (25 часов).

Правда, столь ощутимый выигрыш в скорости будет стоить немалых денег — цена Nvidia DGX-1 в США составляет $129 тысяч. Но в принципе она делает его вполне доступным для крупных и средних коммерческих компаний, исследовательских и научных центров (по крайней мере на Западе).

Но пожалуй самой впечатляющей частью презентации Nvidia стала сеть глубокого обучения DCGAN, умеющая, ни много ни мало, писать картины в заданном стиле на заданный сюжет. Используется при этом т.н. «обучение без учителя» (unsupervised learning) — два десятка тысяч картин были представлены системе без всяких меток (обозначающих, например, сюжет данного полотна). На их основе при помощи кластерного анализа система не только обучается различать искомые жанры и сюжеты, но и создавать их. Например, вы можете поручить DCGAN написать картину в жанре классицизма, на которой будет изображено морское побережье на закате — и она с этим прекрасно справится. Выше вы видите не портрет кисти Ван Гога, а как раз одно из творений обучившегося живописи и, образного говоря, подражающего этому мастеру искусственного интеллекта. С учетом аналогичных экспериментов в музыке, вопрос, заданный роботу героем фантастического кинофильма «Я, робот», уже сегодня представляется совсем не риторическим…