Nvidia об искусственном интеллекте

— Ты всего лишь машина, только имитация жизни! Робот сочинит симфонию? Робот превратит кусок холста в шедевр искусства?

— А Вы? (из к/ф «Я, робот»)

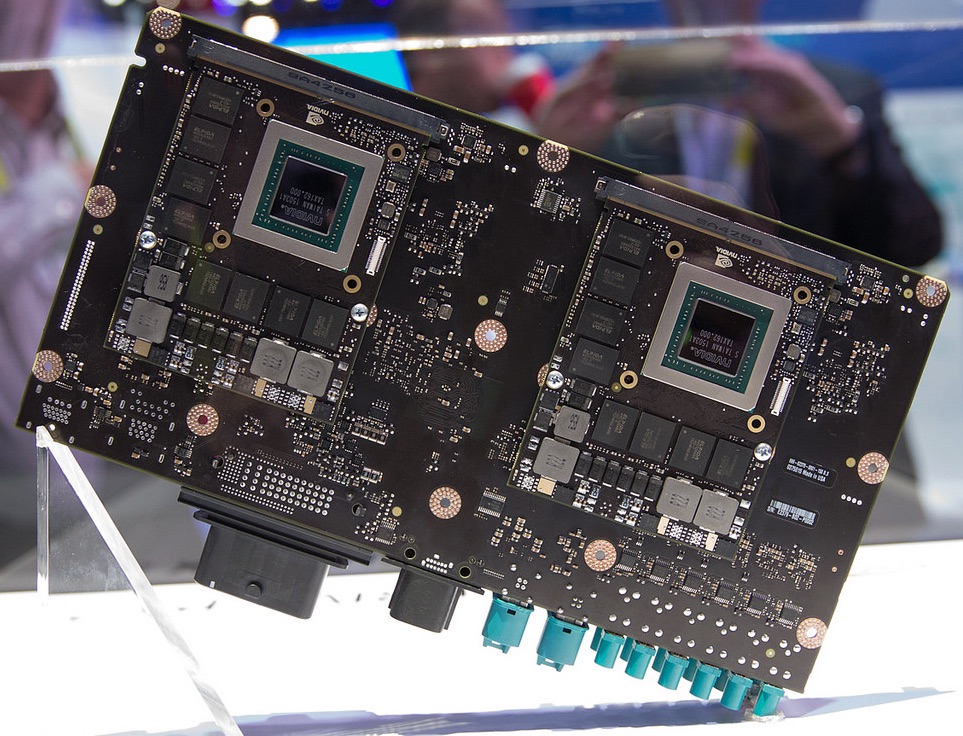

Пожалуй самым крупным и интересным анонсом прошедшей в начале января CES 2016 стала презентация Nvidia второго поколения «суперкомпьютера на колесах, Drive PX 2. Компания позиционирует его как полноценную систему искусственного интеллекта, главным критерием которого является самообучение — в отличие от классического программирования, в котором изначально прописан конкретный алгоритм для конкретной ситуации. В случае с Drive PX 2 самообучение реализовано на базе так называемых «глубоких нейронных сетей» (ГНС), которым Nvidia посвятила серию последних публикаций. С учетом заинтересованности компании в ажиотаже вокруг систем искусственного интеллекта (аппаратную основу большинства из которых составляют графические ускорители), изложенные в её публикациях сведения возможно и не претендуют на абсолютно достоверные и точные, но несомненно заслуживают внимания.

Прежде чем приступить к изложению этих сведений, я рискну вкратце описать свое собственное понимание принципов функционирования ГНС. Самообучение в них происходит разными методами, самым распространенным среди которых является сравнение сделанной ГНС догадки (например, «это собака, а не кошка») с фактическим результатом («нет — это кошка», или «да — это собака»). По мере выполнения тысяч и тысяч обучающих заданий, ГНС учится обнаруживать сложные, трудно формализуемые взаимосвязи между входными и выходными данными, которые фиксируются весовыми коэффициентами связей между нейронами. Схожим образом функционирует человеческий мозг (в котором роль весовых коэффициентов выполняет сила возбуждения живых нейронов). В результате даже разработчик ГНС не в состоянии дать формальное объяснение тому или иному решению своей системы — подобно тому, как мы затрудняемся объяснить каким образом узнаем знакомых людей. Конечно, это очень грубое, неполное и возможно даже некорректное объяснение принципа функционирования ГНС, поэтому за более точным описанием я рекомендую обратиться к соответствующей литературе.

Исследования в этой области ведутся по меньшей мере с пятидесятых годов 20 века. Подробнее с хронологией их разработки можно ознакомиться в Википедии, но вкратце среди ключевых событий можно выделить следующие:

- 1949: Написан первый алгоритм обучения

- 1958: Разработан перцептрон — математическая модель восприятия информации мозгом. Создание полноценных систем искусственного интеллекта представляется вопросом ближайшей перспективы.

- 1974: Написан алгоритм обратного распространения ошибки для обучения многослойных перцептронов. Изобретение не привлекает большого внимания.

- 1986: переоткрыт и существенно развит метод обратного распространения ошибки. Взрыв интереса к обучаемым нейронным сетям.

- 2007: в Торонтском университете (Канада) написан алгоритм глубокого обучения многослойных нейронных сетей (тех самых ГНС).

Эту хронологию Nvidia дополняет еще двумя датами:

- 2012: в соревновании по распознаванию изображений, ImageNet, разработанная Алексом Крижевским (Alex Krizhevsky) из Торонтского университета ГНС AlexNet с большим отрывом превосходит систему, распознающую изображения по заданному алгоритму.

- 2015: во все том же соревновании ImageNet разработанные Google и Microsoft ГНС превзошли результат, полученный человеком. Не написанного им алгоритма, как в 2012 году, а его собственного распознавания зрительных образов. Вскоре после этого Microsoft и Научно-технический университет Китая объявили, что созданные ими ГНС в IQ-тесте превзошли уровень аспиранта вуза. Затем китайский поисковик Baidu объявил, что разработанная им ГНС Deep Speech 2 на базе одного и того же алгоритма обучилась английскому и китайскому языкам.

Аппаратную основу Drive PX 2 (способного производить 24 триллиона операций глубокого обучения в секунду) составляют графические ускорители — для создания самообучающихся систем они подходят гораздо лучше традиционных процессоров. Согласно Nvidia, в подобных задачах 12 её ГПУ способны заменить 2,000 ЦПУ, а переход с ЦПУ на ГПУ всего за три года позволил повысить производительность самообучения в 50 раз. В ближайшие несколько лет компания ожидает 10-кратный рост производительности. И как мы уже говорили, при использовании связки ГНС+ГПУ в десятки раз вырастает скорость обучения. Какую роль в этом играет каждый из этих компонентов, Nvidia не поясняет, и вообще я бы рекомендовал относиться к её математическим выкладкам с изрядной долей скептицизма — с учетом имеющихся прецедентов. В любом случае бесспорно, что нынешний уровень графической производительности вполне созрел для распространения беспилотных автомобильных систем — одного из ключевых направлений нынешней стратегии Nvidia. Согласно компании, свыше 50 автопроизводителей, их поставщиков, разработчиков программного обеспечения и стартапов используют Drive PX для разработки ГНС.

Растут и денежные вливания — а интерес бизнеса говорит сам за себя. К упомянутым ранее двум миллиардам долларов, которые в разработку систем искусственного интеллекта намерены вложить Toyota и группа инвесторов из Кремниевой долины, включая Илона Маска, можно добавить полмиллиарда долларов General Motors и компании Lyft, а также четыре миллиарда долларов, которые в течение ближайших десяти лет намерены потратить власти США на поддержку беспилотных автомобилей и создание соответствующей инфраструктуры.

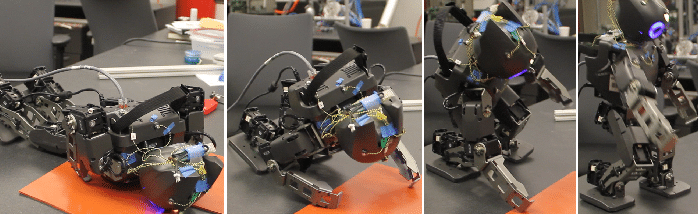

В целом же аппаратные платформы Nvidia для ГНС представлены Tesla для суперкомпьютеров и облачных приложений, GeForce — для ПК, Drive PX — для автомобилей и Jetson — для дронов с роботами. Последние используют ГНС для обучения ходьбе — подобно тому, как учится ходить ребенок.

Еще амбициознее выглядят планы ученых по использованию систем искусственного интеллекта …для сочинения музыки. С 22 февраля по 5 марта в лондонском Артс-театре состоится премьера экспериментального мюзикла «За забором» (Beyond the Fence), написанного, как утверждается, при помощи системы искусственного интеллекта. Причем фрагмент из мюзикла можно услышать уже сегодня: