Nvidia Shield Android TV: результаты тестирования производительности и энергопотребления

Сегодня в США поступила в продажу первая теле-игровая приставка Nvidia Shield Android TV. Компания анонсировала ее еще в марте, рекомендуемая цена в США составляет $200 за 16 Гб версию и $300 — с жестким диском в 500 Гб.

Самое интересное в Shield Android TV — процессор Tegra X1. Напомним, что Nvidia представила его в январе, и с тех пор многих любителей мобильной электроники интересовал вопрос: появится ли он когда-нибудь в мобильных устройствах (если не считать таковыми автомобили)? Поэтому, помимо быстродействия этого самого производительного в мире чипсета с архитектурой ARM, нас волнует вопрос о его энергопотреблении.

Но начнем пожалуй именно с производительности. Как мы уже рассказывали, в предварительных тестах чипсет выдавал такие цифры:

| Тесты | Apple A8X | Tegra K1 | Tegra X1 |

| BaseMark X 1.1 Dunes (Offscreen) | 40.2 к/с | 36.3 к/с | 56.9 к/с |

| 3DMark 1.2 Unlimited (Graphics) | 31,781 | 36,688 | 58,448 |

| GFXBench 3.0 Manhattan 1080p (Offscreen) | 32.6 к/с | 31.7 к/с | 63.6 к/с |

В свежем испытании Nvidia Shield Android TV у наших коллег из AnandTech получились следующие результаты:

- BaseMark X 1.1 Dunes (Offscreen) — 56.65 к/с

- 3DMark 1.2 Unlimited (Graphics) — 61,686

- GFXBench 3.0 Manhattan 1080p (Offscreen) — 65.6 к/с.

Таким образом, результаты графических тестов остались почти на прежнем уровне. Аналогичный результат в тесте GFXBench 3.0 Manhattan 1080p (63.4 к/с) можно видеть непосредственно на сайте этого бенчмарка. В свою очередь, в менее требовательном тесте GFXBench 3.0 T-Rex 1080p мы видим 121-123 к/с. Насколько стабильно держатся эти значения при длительном запуске тестов пока неизвестно.

Много 65 к/с в тесте GFXBench 3.0 Manhattan или мало? Для сравнения, самая производительная в этом тесте десктопная видеокарта, GeForce GTX 980, выдает 597 к/с. В сегменте настольных компьютеров результату Shield Android TV соответствует, например, GeForce GT 740 — бюджетная модель 2014 года ценой $89 в США.

Разумеется, все эти данные приведены для общего представления и вовсе не претендуют на исчерпывающую характеристику графической производительности — она может меняться от теста к тесту и тем более иначе проявить себя непосредственно в играх.

Перейдем к главному интересующему нас вопросу. Замеры энергопотребления Nvidia Shield Android TV производились в двух сценариях: на 46-дюймовом телевизоре Sony KDL46EX720 с разрешением Full HD (Таблица 1) и 40-дюймовом Samsung HU6950 с разрешением 4K (Таблица 2):

Таблица 1

| Вид нагрузки | Энергопотребление |

| Не занят | 3.6 Вт |

| Трансляция 1080p Netflix | 4.6 Вт |

| Воспроизведение 1080p YouTube | 4.7 Вт |

| Воспроизведение Kodi (аппаратное ускорение 1080p60 H.264) | 6.5 Вт |

| Воспроизведение Kodi (программное декодирование 1080i60 VC-1) | 10.4 Вт |

Таблица 2

| Вид нагрузки | Энергопотребление |

| Не занят | 4.2 Вт |

| Воспроизведение 4K HEVC | 9.1 Вт |

| Трансляция 4K Netflix | 10.3 Вт |

| Игры (4K с частотой 60 к/с) | 19.4 Вт |

К сожалению, энергопотребление в играх приводится только для второго сценария, тогда как именно на разрешении Full HD оно дало бы относительно адекватное представление об энергопотреблении на плашете. Но с учетом того, что при потоковом вещании сервиса Netflix выходит примерно двукратная разница, получаем около 10 Вт. Согласно Nvidia, столько потребляет один только процессор Tegra X1. Но, как мы уже рассказывали, по замерам AnandTech в тесте GFBench 3.0 Manhattan процессор потребляет гораздо меньше — около 1.5 Вт (против 2.7 Вт у процессора Apple A8X в планшете iPad Air 2).

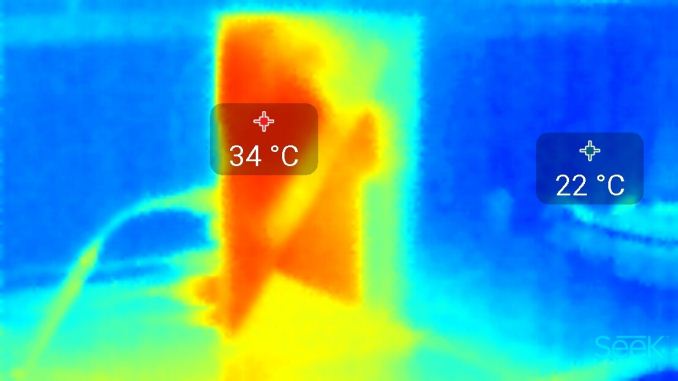

Что касается тепловыделения, то оно у Shield Android TV заслуживает только похвал — после двухчасового прогона теста GFXBench T-Rex она не поднялась выше 34°C:

Из всех этих данных по-прежнему затруднительно сделать какой-либо однозначный вывод о перспективах использования процессора Tegra X1 в планшетах. С точки зрения первоначальных замеров AnandTech это все-таки возможно, так что не исключено, что отсутствие интереса Nvidia к мобильному сегменту игровой индустрии обусловлено чисто коммерческими соображениями. Хотя логика создания настольной игровой приставки для мобильных игр представляется еще более спорной.

С использованием данных AnandTech