Google Assistant vs Siri vs Cortana vs Alexa: какой интеллектуальный помощник лучше

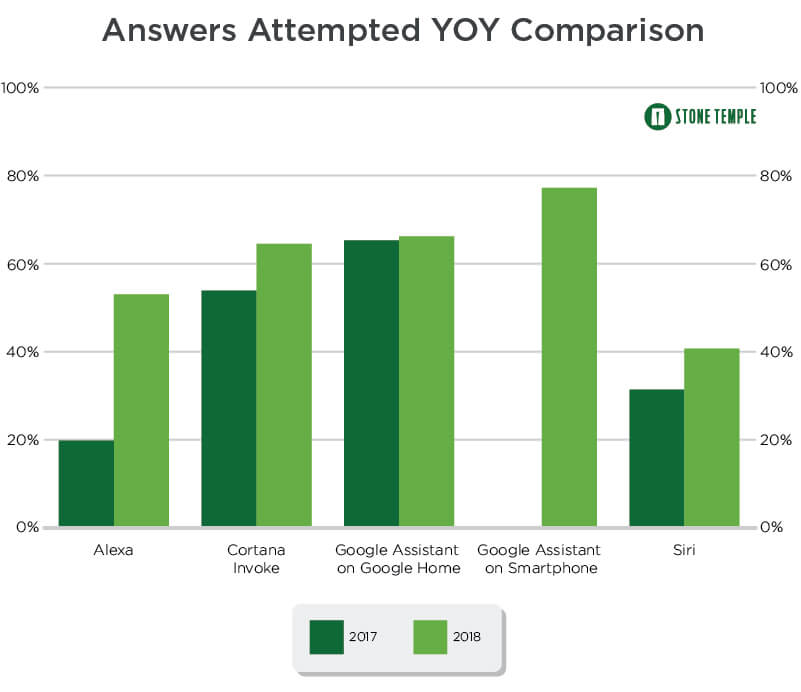

Маркетинговое агентство Stone Temple опубликовало свежие (на 24 апреля 2018) результаты тестирования популярных интеллектуальных помощников, Google Assistant, Siri (Apple), Cortana (Microsoft) и Alexa (Amazon). Каждому из них были заданы 4,942 вопросов, после чего по нескольким параметрам сделана оценка качества ответов.

Главными параметрами стали:

- доля попыток ассистента ответить на вопрос в общем количестве полученных им запросов (соответственно сюда не входят ответы «Я не знаю» и, очевидно, перенаправление запроса в поисковик)

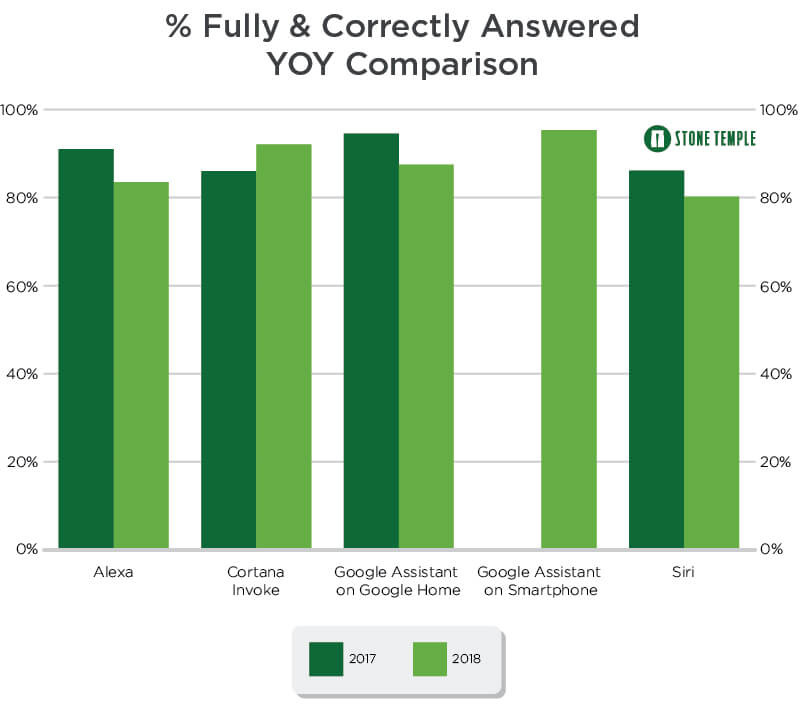

- доля полных и правильных ответов в этих попытках.

Результаты испытаний в 2017 и 2018 году выглядят следующим образом:

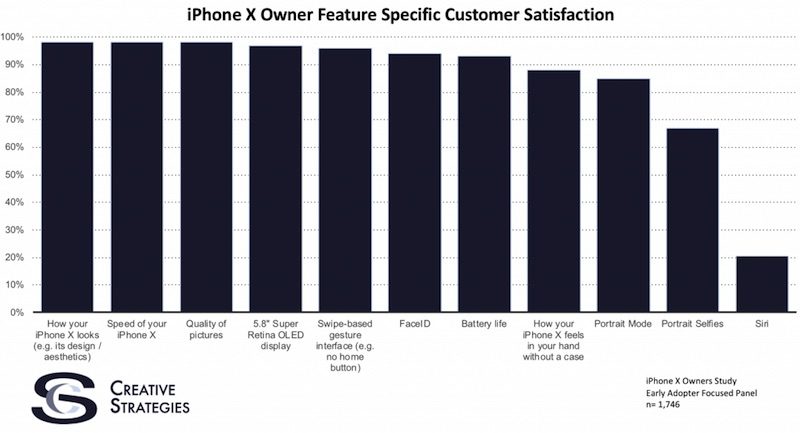

Как видим, наилучший результат по первому параметру в 2018 году показывает Google Assistant, который попытался ответить почти на 80% вопросов, а наихудший — Siri (40%). Последние данные вполне коррелируют с недавним исследованием уровня потребительской удовлетворенности смартфоном iPhone X, с провальным 20% результатом в части интеллектуального помощника:

При этом лидирующий в этом рейтинге Google Assistant с прошлого года, если судить по его версии на «умной колонке» Google Home, почти не улучшился. Зато весьма внушительную динамику с 2017 по 2018 продемонстрировала Alexa компании Amazon — доля попыток ответить на запрос пользователя выросла с 19.8% to 53.0%.

Следующая гистограмма иллюстрирует долю правильных ответов:

Здесь мы видим на удивление высокий результат, не ниже 80%. Почти у всех помощников он с прошлого года ухудшился, но это представляется вполне нормальным с учетом того, что выросло количество попыток ответить на запрос. Однако что интересно — несмотря на самую лучшую результативность по последнему показателю, Google Assistant одновременно лидирует и в правильных ответах. Если исходить из приблизительной визуальной оценки гистограммы, 78% попыток и 95% правильных ответов, то получается 74% правильных ответов на все запросы пользователя — на мой взгляд очень хороший результат.

В прошлом году Gadgets News рассказывал о результатах исследования китайских ученых, которые попытались оценить интеллектуальность поисковиков Google (очевидно в лице Google Assistant), Baidu, Bing (Cortana), а также помощника (или помощницы) Siri. Они сравнивались с человеком, чей интеллектуальный уровень, в зависимости от возраста, оценивался в 97 (18 лет), 84.5 (12 лет) и 55.5 баллов (6 лет). Интеллектуальному помощнику Google в 2016 году приписывались 47.28 баллов.

Может возникнуть впечатление, что уже тогда искусственный интеллект Google Assistant почти сравнялся с ребенком, и уж наверняка достиг его уровня спустя два года. Однако в действительности это далеко не так — искусственный интеллект пока не достиг даже уровня крысы, не говоря уже о хотя бы трехлетнем ребенке. Как я уже говорил в прошлых публикациях на эту тему, вопреки впечатляющим результатам тестов на понимание текста, никакого понимания у современных нейросетей в действительности нет. Для этого понимания требуется принципиально новый подход к архитектуре систем машинного обучения, способный воспроизвести такие свойства биологического интеллекта как, в частности, инвариантность и прогнозирование.

Это вовсе не значит, что до появления таких концепций относительное «понимание» текста нельзя реализовать в рамках нынешних технологий — в этом можно убедиться на примере приведенных выше результатов. Но если говорить о полноценном естественно-языковом интерфейсе взаимодействия с машиной (смартфоном, компьютером, роботом и т.д.) — таким образом, чтобы она не только понимала отдельно взятые команды, но и поддерживала с человеком диалог, понимала сложные тексты и т.д., то до этого еще очень далеко, по всей видимости несколько десятилетий.