Nvidia B200: 5-кратный прирост производительности за два года

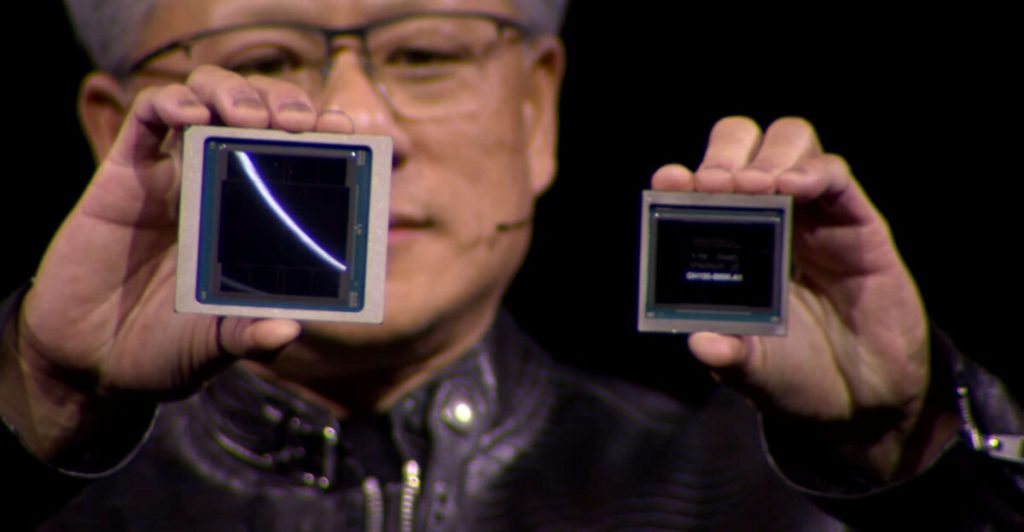

Этой ночью (по московскому времени) состоялась большая презентация Nvidia, на которой компания представила свой новейший суперчип — B200 с архитектурой Blackwell, названной так в честь американского математика Дэвида Блэквелла. До этого самых производительным чипом для графических ускорителей был анонсированный в ноябре прошлого года H200 с архитектурой Hopper, который представляет собой прокачанную версию H100. Тогда же Nvidia упомянула в своей презентации некий B100, который должен был стать преемником H200. Отдельный анонс B100 пока не состоялся, но его характеристики известны: техпроцесс TSMC 4NP, 104 млрд транзисторов, интерфейс 10 Тб/с. Nvidia представила его сдвоенную версию, B200, которая, соответственно, содержит 208 млрд транзисторов и имеет производительность 20 петафлопс с точностью FP8 в операциях с плавающей точкой (занимает в памяти 8 битов) и 40 петафлопс с точностью FP4.

Для сравнения, принятый для суперкомпьютеров стандарт — это FP64 (64 бита), поэтому сравнивать B200 с ними напрямую некорректно. Также следует помнить, что Nvidia приводит тензорную производительность в операциях на разреженных, т.е. с преимущественно нулевыми элементами, матрицах. Зато B200 можно сравнить с предшественником, чья скорость также измеряется в FP8 на разреженных матрицах — по сравнению с H200 и анонсированным два года назад H100 (4 петафлопса) производительность B200 выросла в 5 раз.

При столь внушительной скорости, B200 — всего лишь кирпичик, из которого собираются большие вычислительные кластеры. Плата из двух таких ГПУ, одного 72-ядерного (Neoverse) ЦПУ и 864 Гб памяти NBM3e (16 Тб/с) называется GB200 и имеет производительность 40 петафлопс FP8. А рабочая станция DGX B200 оснащена восемью ГПУ B200, двумя ЦПУ Intel Xeon Platinum 8570 и имеет производительность 72/144 (обучение/инференс) петафлопс. DGX B200 имеет размеры 44×48×90 см и энергопотребление 14 КВт. Впрочем, работающих над созданием искусственного интеллекта следующего поколения гигантов IT-индустрии (вроде финансируемого Microsoft стартапа OpenAI, Google DeepMind, Meta, Amazon, Apple и других) скорее заинтересует возможность масштабировать B200 до кластера из 32 тыс чипов общей производительностью 645 экзафлопс.

GPT-4, по слухам, обучалась на 25 тыс графических ускорителей Nvidia A100 (2020), чья тензорная производительность в операциях на разреженных матрицах составляет 624 терафлопс FP16. Если бы A100 поддерживал точность на уровне FP8, то это было бы 1,248 терафлопс — против 19,790 терафлопс у B200. Соответственно кластер из 32 тыс B200 будет в 20 раз быстрее того кластера, на котором, предположительно, в течение трех месяцев обучалась GPT-4. Причем за счет квантизации (перехода от более точных вычислений к менее точным, но компактным) происходит дополнительное ускорение. Так, только за счет поддержки FP8 два года назад вдвое выросла скорость H100, и теперь она вдвое вырастает у B200 за счет поддержки FP4 (помимо промежуточного стандарта FP6). Производительность в операциях на разреженных матрицах также приводится не только для того, чтобы завысить производительность — наименее важные веса при обучении ИНС зачастую обнуляются.

Как уже отмечал Gadgets News, бурное развитие искусственного интеллекта в настоящее время сдерживается нехваткой производительности, поэтому индустрия с нетерпением ожидает новинок вроде Nvidia B200. Благодаря ажиотажному спросу на графические ускорители выручка и прибыль Nvidia стремительно растут, а её рыночная капитализация перевалила за $2 трлн — при том, что еще осенью 2022 она не превышала $300 млрд, а до начавшегося в 2015 роста в течение многих лет колебалась в пределах $10 млрд.