Nvidia Geforce GTX 1080 vs Titan X и GTX 980 Ti: быстрее, экономнее, дешевле

Прошлой ночью состоялось мероприятие, на котором Nvidia сделала несколько важных анонсов:

- Ansel — инструмент для создания игровых скриншотов

- набор технологий VR Funhouse для более качественного погружения в виртуальную реальность

- систему одновременного построения множества проекций для игры на нескольких периферийных мониторах, и наконец

- Geforce GTX 1080 и Geforce GTX 1070 — первые игровые видекарты 1000-й серии серии с новейшей архитектурой Pascal и 16-нанометровым техпроцессом.

Пожалуй с них и начнем, поскольку по своим возможностям GTX 1080 претендует на значительный отрыв от обоих нынешних флагманов Nvidia. Приведем известные на сегодня характеристики новинок вместе с Titan X, 980 Ti и непосредственным предшественником GTX 1080, GTX 980:

| GTX Titan X | GTX 980 Ti | GTX 980 | GTX 1070 | GTX 1080 | |

| Дата анонса | 17.03.2015 | 01.06.2015 | 18.09.2014 | 07.05.2016 | 07.05.2016 |

| Цена при анонсе (США) | $999 | $649 | $549 | $379 | $599 |

| Производительность FP32 (терафлопс) | 7 * | 5.63 ** | 5 *** | 6.5 | 9 |

| Кол-во транзисторов | 8 млрд | 8 млрд | 5.2 млрд | 7.2 млрд | 7.2 млрд |

| Кол-во ядер CUDA | 3,072 | 2,816 | 2,048 | ? | 2,560 |

| Кол-во текстурных блоков (TMU) | 192 | 176 | 128 | ? | 160(?) |

| Скорость заполнения текстур (гига-текселей/с) | 192 | 176 | 144 | ? | ? |

| Кол-во растровых блоков (ROP) | 96 | 96 | 64 | ? | 64(?) |

| Базовая частота | 1,000 МГц | 1,000 МГц | 1,126 МГц МГц | ? | 1,607 МГц |

| Разогнанная частота | 1,075 МГц | 1,075 МГц | 1,216 МГц | ? | 1,733 МГц |

| Тип памяти | GDDR5 | GDDR5 | GDDR5 | GDDR5 | GDDR5X |

| Эффективная частота памяти | 7 ГГц | 7 ГГц | 7 ГГц | 7 ГГц | 10 ГГц |

| Разрядность памяти | 384-бит | 384-бит | 256-бит | ? | 256-бит |

| Максимальная полоса пропускания памяти | 336.5 Гб/с | 336.5 Гб/с | 224 Гб/с | ? | 320 Гб/с |

| Объем видеопамяти | 12 Гб | 6 Гб | 4 Гб | 8 Гб | 8 Гб |

| Доля ядер FP64 | 1/32 FP32 | 1/32 FP32 | 1/32 FP32 | ? | ? |

| Энергопотребление (TDP) | 250 Вт | 250 Вт | 165 Вт | ? | 180 Вт |

| Архитектура | Maxwell 2 | Maxwell 2 | Maxwell | Pascal | Pascal |

| ГПУ | GM200 | GM200 | GM204 | GP104(?) | GP104(?) |

| Техпроцесс | TSMC 28нм | TSMC 28нм | TSMC 28нм | TSMC 16нм | TSMC 16нм |

* По данным официальной презентации Nvidia. По неофициальным данным — 6.14

** По неофициальным данным

*** По другим данным — 4.6

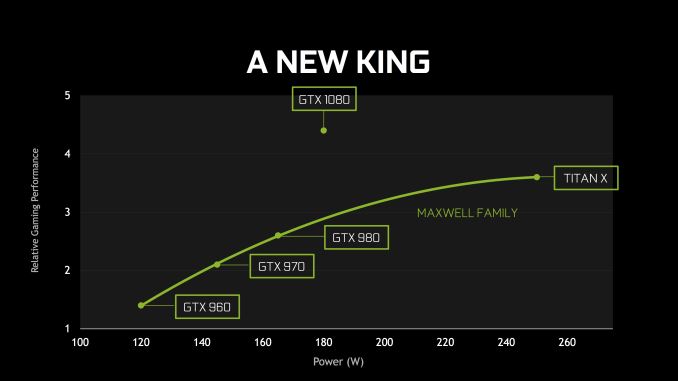

В первую очередь обращают на себе внимание значительное снижение энергопотребления GTX 1080 по сравнению с флагманами прошлого года (180 Вт vs 250 Вт) — и это несмотря на 1.6-кратный рост тактовой частоты. Благодаря в т.ч. последнему обстоятельству производительность GTX 1080 превысила даже самую производительную в мире игровую карту, прошлогоднюю GTX Titan X. Судя по графику на презентации, разница составляет 20-25%, причем в приложениях виртуальной реальности, в сочетании с применением анонсированных сегодня технологий, рост производительности становится двукратным. Главную роль в снижении энергопотребления очевидно сыграли два обстоятельства: новый техпроцесс и новая архитектура ГПУ.

Релизная цена GTX 1080 ($599) оказалась ниже не только по сравнению с GTX Titan X ($999), но и GTX 980 Ti ($649). Сравнивать с последним пожалуй корректнее, поскольку в играх у него примерно такая же производительность, что у Titan X.

Если же сравнивать с предшественником, GTX 980, то GTX 1080 немного прибавила в энергопотреблении (180 Вт vs 165 Вт) и цене ($599 vs $549), но при этом по быстродействию превосходит GTX 980 SLI, т.е. две объединенные GTX 980.

В качестве стандарта видеопамяти для GTX 1080 Nvidia предпочла GDDR5X вместо HBM2. Напомним, что последний используется в её первой видеокарте с архитектурой Pascal и 16-нанометровой литографией, Tesla P100. У видеокарты пять дисплейных выходов: 3 x DisplayPort 1.4, 1 x HDMI 2.0B и 1 x DVI. Для подключения второй карты потребуется разъём нового стандарта, SLI HB.

GTX 1080 поступит в продажу 27 мая, а GTX 1070 — 10 июня. Обе карты можно будет приобрести также в специальном издании, которое от традиционного отличается более высокой частотой и, соответственно, производительностью. Разогнанная до 2 ГГц GTX 1080 стоит $699 (при этом в ней по-прежнему используется воздушное охлаждение), а разогнанная до неназванной частоты GTX 1070 — $449.

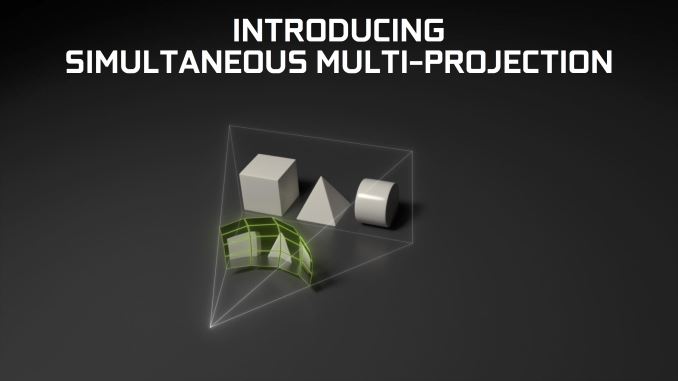

Как мы уже говорили выше, вместе с новыми видеокартами Nvidia представила и несколько новых технологий. Особенностью архитектуры Pascal стала поддержка Simultaneous Multi-Projection — одновременной мульти-проекции, когда видеокарта выводит одно и тоже изображение под несколькими (до 16) самостоятельными углами зрения. Это особенно актуально в игре на трех мониторах, которые воспроизводят, например, вид из салона гоночного автомобиля. Традиционно изображение выводится таким образом, словно мониторы стоят в ряд. Разумнее было бы поставить их полукругом, но тогда возникает визуальное искажение — вы под одним углом смотрите на изображение, сформированное из расчета обзора под другим углом. До сих пор этого можно было избежать с помощью нескольких видеокарт, но теперь, благодаря возросшей производительности, Nvidia предусмотрела такую возможность силами одной видеокарты.

Simultaneous Multi-Projection легла в основу двух других технологий, Lens Matched Shading и Single Pass Stereo, которые значительно оптимизируют процесс графического рендеринга на двух дисплеях в очках виртуальной реальности. Именно благодаря их применению производительность GTX 1080 в устройствах виртуальной реальности превосходит Titan X в два раза. Также Nvidia анонсировала несколько новых технологий, ставших расширением VRWorks и PhysX и образовавших набор инструментов VR Funhouse. В частности, речь идет о VRWorks Audio, которое обеспечивает более достоверное, соответствующее законам акустики, распространение звука в виртуальном пространстве. Компания рассчитывает, что благодаря VR Funhouse погружение в виртуальную реальность станет более реалистичным.

Еще одна технология, Ansel представляет собой инструмент, встроив который в свои новые игры разработчики позволят геймерам создавать весьма эффектные скриншоты, задавая нужные ракурс и точку обзора, применяя фильтры и фотоувеличение. Последнее станет возможным благодаря 32-кратному повышению разрешения сделанного скриншота (до 8 гигапикселей) по сравнению с разрешением самой игры. Скриншоты можно будет делать панорамными и стереоскопическими, с последующими просмотром не только на ПК, но и устройстве виртуальной реальности и даже на смартфоне.

Nvidia, AnandTech